コンピュータービジョンに関する欧州会議(ECCV)2024

(2024.08.07)キーポイントベースのフェイシャルイメージアニメーションの推論スクリプトをリリースしました!詳細については、こちらを参照してください。

(2024.07.15)軌跡ベースの画像アニメーションのトレーニングコードをリリースしました!詳細については、こちらを参照してください。

Mofa-VideoはECCV 2024に登場します! ??????

ハイブリッドコントロールのグラデーション推論コードとチェックポイントをリリースしました!詳細については、こちらを参照してください。

Huggingfaceスペースを介した無料のオンラインデモがまもなく登場します!

この作品が面白いと思うなら、お気軽にお願いします!

|  |  |

| 軌跡 +ランドマーク制御 | ||

|  |  |  |

| 軌跡制御 | |||

|  |  |  |  |

| ランドマークコントロール | ||||

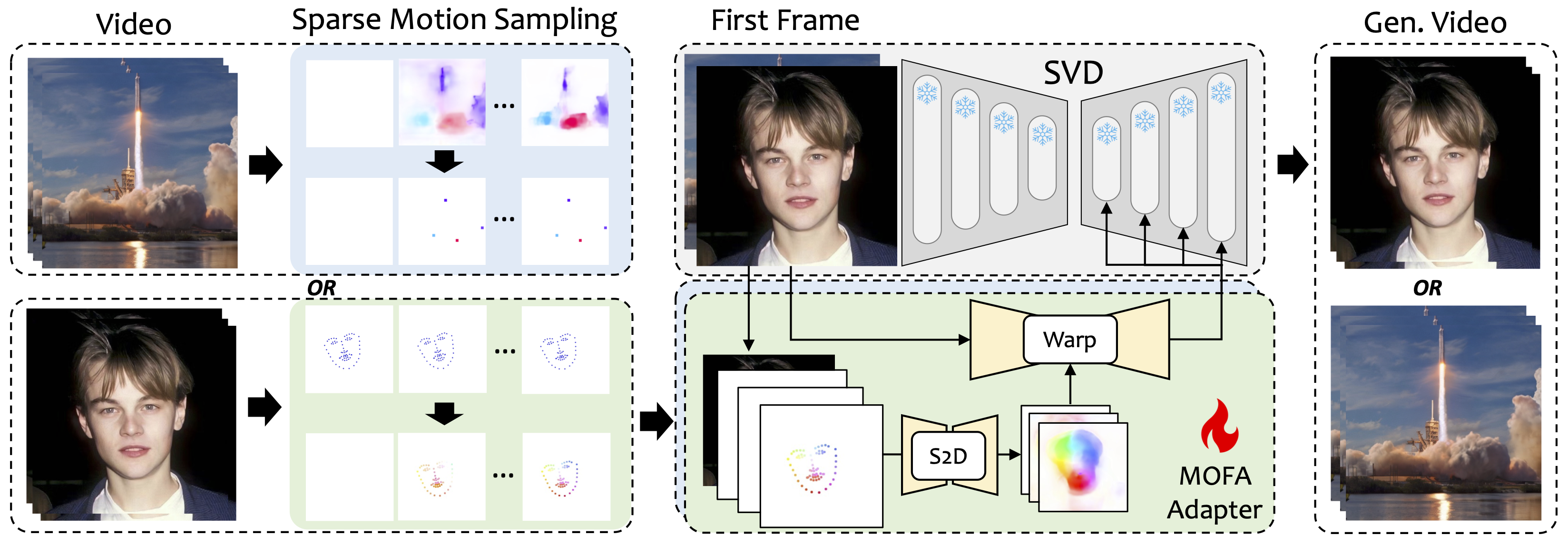

Mofa-Videoを紹介します。Mofa-Videoは、さまざまなドメインの動きを凍結ビデオ拡散モデルに適応させるために設計された方法です。まばらな(S2D)モーション生成とフローベースのモーション適応を使用することにより、MOFA-Videoは、軌道、キーポイントシーケンス、およびそれらの組み合わせなど、さまざまなタイプの制御信号を使用して単一の画像を効果的にアニメーション化できます。

トレーニング段階では、スパースモーションサンプリングを通じてスパースコントロール信号を生成し、さまざまなMOFAアダプターをトレーニングして、事前に訓練されたSVDを介してビデオを生成します。推論段階では、異なるMOFAアダプターを組み合わせて、凍結SVDを共同制御できます。

git clone https://github.com/MyNiuuu/MOFA-Video.git

cd ./MOFA-Video

デモは、11.7のCUDAバージョンでテストされています。

cd ./MOFA-Video-Hybrid

conda create -n mofa python==3.10

conda activate mofa

pip install -r requirements.txt

pip install opencv-python-headless

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

重要:requirements.txtの4.5.0のグレーディオバージョン4.5.0.txtは厳密に従う必要があります。

ここからCMPのチェックポイントをダウンロードして./MOFA-Video-Hybrid/models/cmp/experiments/semiauto_annot/resnet50_vip+mpii_liteflow/checkpoints mofa-video-hybrid/models/cmp/experiments/semiauto_annot/resnet50_vip+mpii_liteflow/checkpointsに入れます。

必要な前提条件のチェックポイントを含むHuggingface Repoからckptsフォルダーをダウンロードし、 ./MOFA-Video-Hybrid Mofa-Video-Hybridの下に置きます。 git lfsを使用して、 ckptsフォルダー全体をダウンロードできます。

git lfsをダウンロードします。これは、ハグFace上の大きなモデルチェックポイントを使用して、リポジトリのクローニングに一般的に使用されます。git clone https://huggingface.co/MyNiuuu/MOFA-Video-Hybridを実行して、現在ckptsフォルダーのみを含む完全なHuggingfaceリポジトリをダウンロードします。ckptsフォルダーをGitHubリポジトリにコピーまたは移動します。注:エラーgit: 'lfs' is not a git command 。私のケースに適したこのソリューションを試すことができます。

最後に、チェックポイントは./MOFA-Video-Hybrid/ckpt_tree.mdとしてorgnizする必要があります。

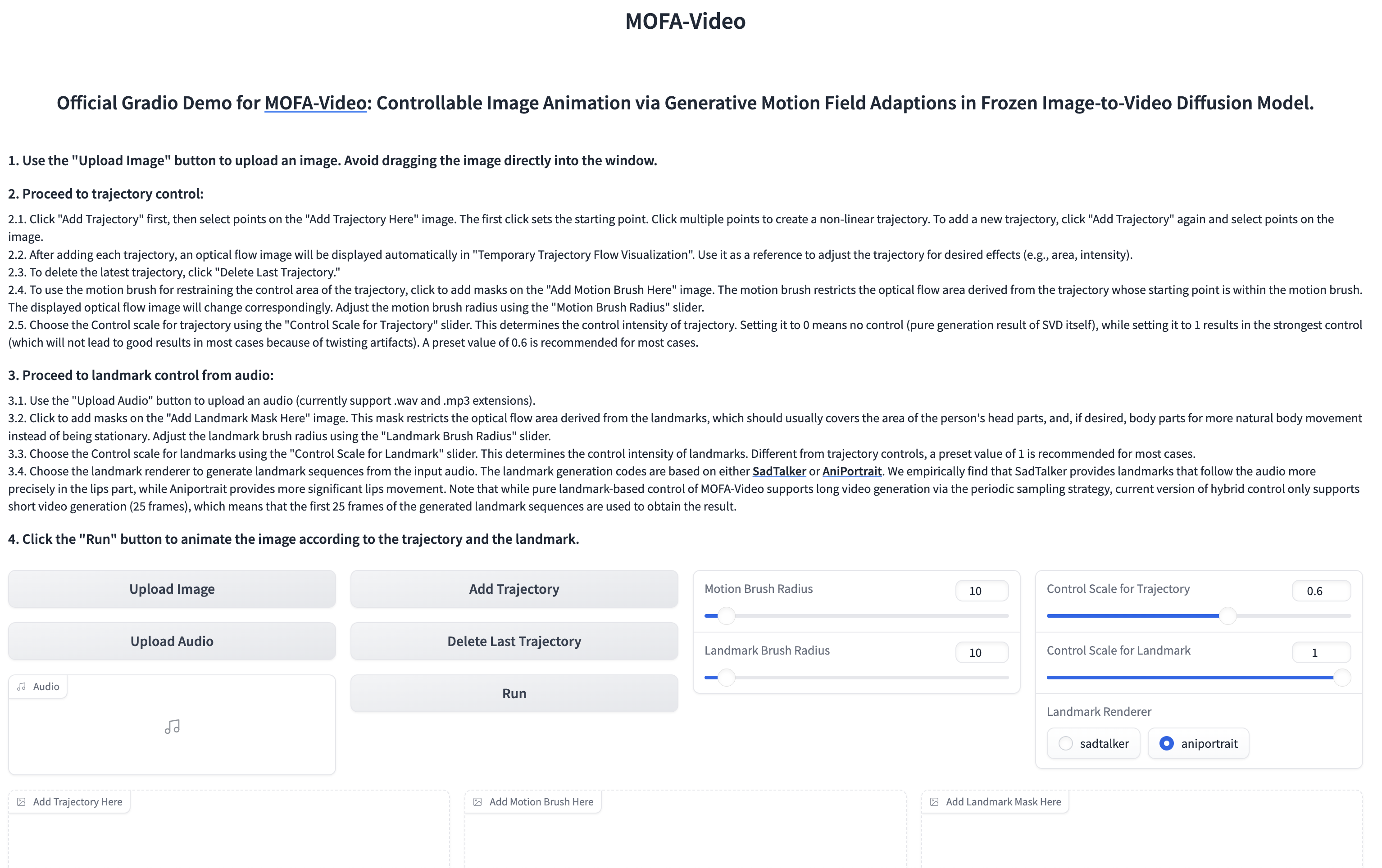

オーディオを使用して顔の部分をアニメーション化します

cd ./MOFA-Video-Hybrid

python run_gradio_audio_driven.py

???グレードインターフェイスは、以下のように表示されます。推論プロセス中のグラデーションインターフェイスの指示を参照してください!

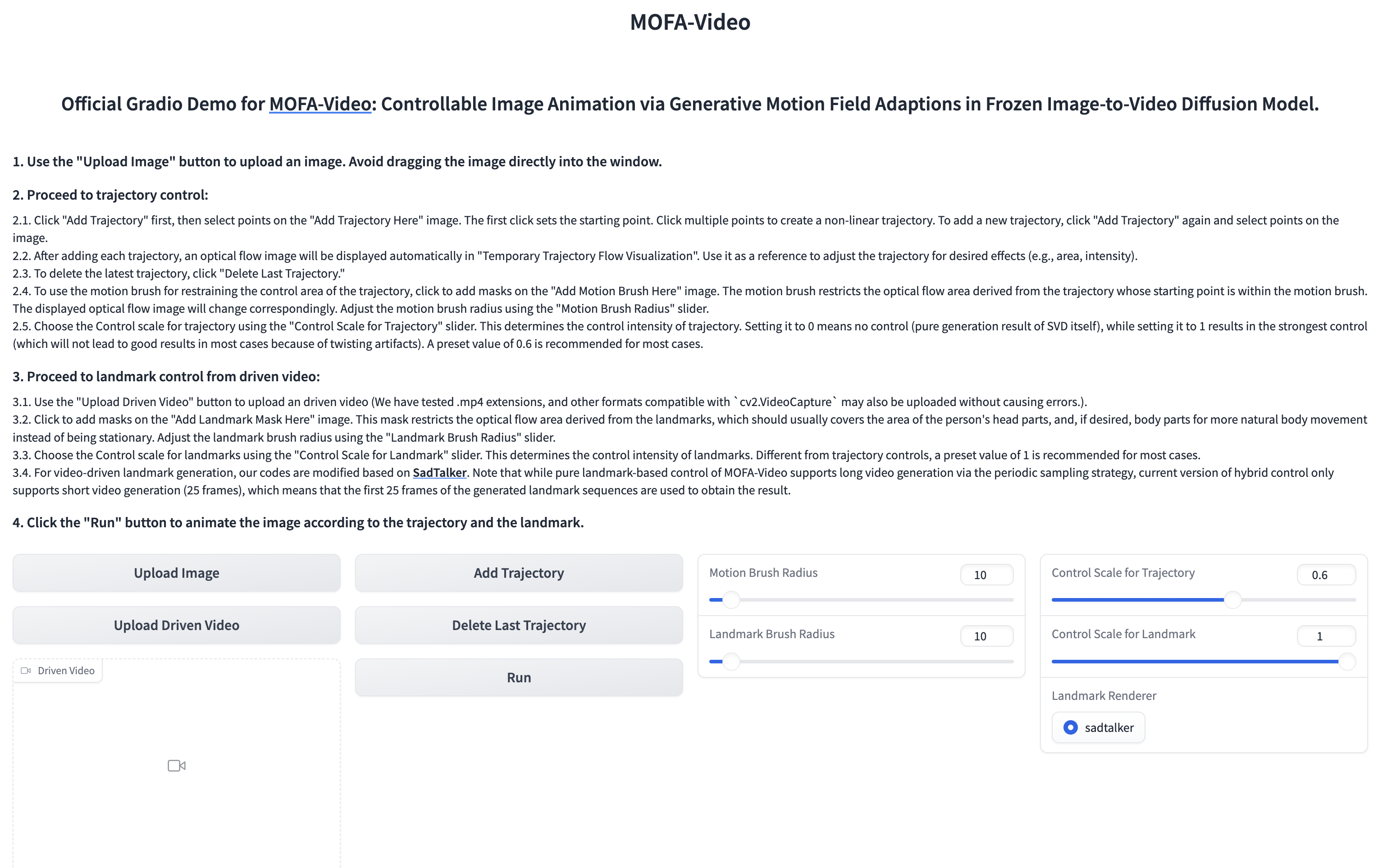

参照ビデオを使用して、顔の部分をアニメーション化します

cd ./MOFA-Video-Hybrid

python run_gradio_video_driven.py

???グレードインターフェイスは、以下のように表示されます。推論プロセス中のグラデーションインターフェイスの指示を参照してください!

指示については、こちらを参照してください。

詳細については、こちらを参照してください。

@article{niu2024mofa,

title={MOFA-Video: Controllable Image Animation via Generative Motion Field Adaptions in Frozen Image-to-Video Diffusion Model},

author={Niu, Muyao and Cun, Xiaodong and Wang, Xintao and Zhang, Yong and Shan, Ying and Zheng, Yinqiang},

journal={arXiv preprint arXiv:2405.20222},

year={2024}

}

Dragnuwa、Sadtalker、Aniportrait、Diffusers、SVD_XTEND、条件付きモーションプロパゲーション、Unimatchのコードリリースに心から感謝しています。