XAI - это библиотека машинного обучения, которая разработана с объясняемостью ИИ в своей основе. XAI содержит различные инструменты, которые обеспечивают анализ и оценку данных и моделей. Библиотека XAI поддерживается Институтом этического AI & ML, и она была разработана на основе 8 принципов ответственного машинного обучения.

Вы можете найти документацию по адресу https://ethicalml.github.io/xai/index.html. Вы также можете проверить наш разговор в Tensorflow London, где была впервые задумана идея - разговор также содержит понимание определений и принципов в этой библиотеке.

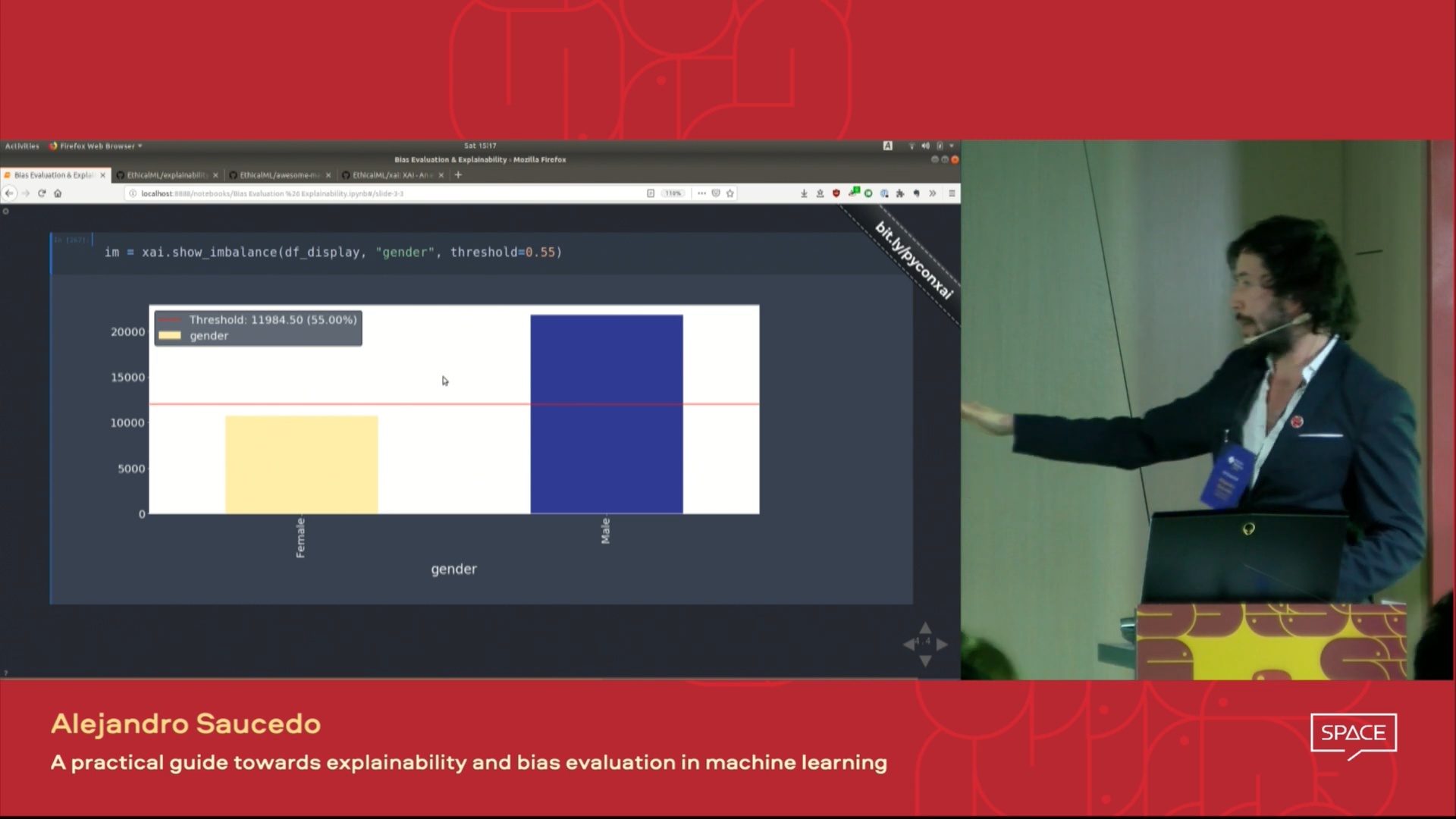

| Это видео о разговоре, представленном на конференции Pydata London 2019, которое представляет собой обзор мотивации для объяснения машинного обучения, а также методы для представления объяснения и смягчения нежелательных предубеждений с использованием библиотеки XAI. |  |

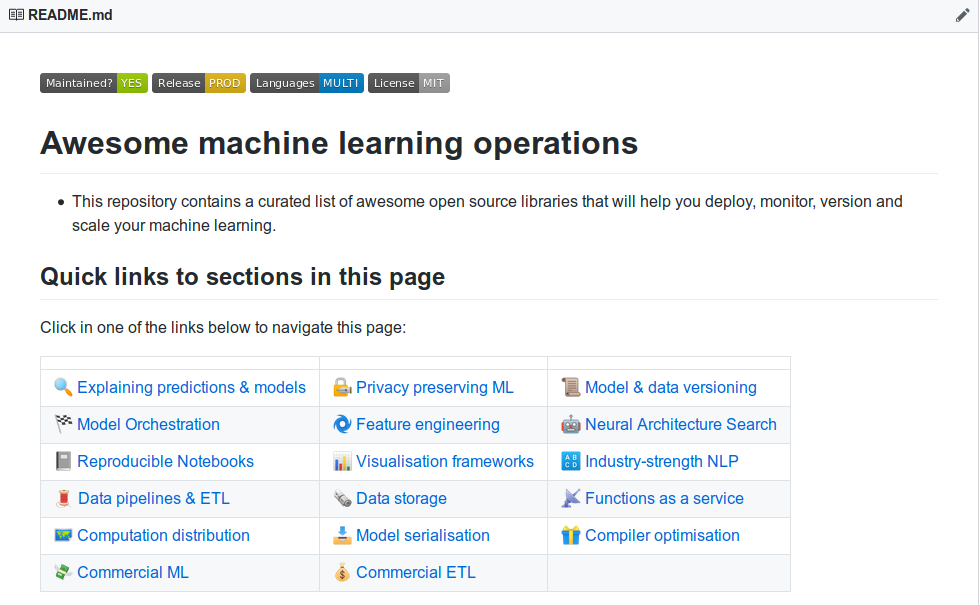

| Вы хотите узнать о более удивительных инструментах объяснения машинного обучения? Ознакомьтесь с нашим сообществом, построенным в сообществе «Awesome Machine Learning Production & Operations», который содержит обширный список инструментов для объяснения, конфиденциальности, оркестровки и за ее пределами. |  |

Если вы хотите увидеть полностью функциональную демонстрацию в действии, клонируйте это репо и запустите пример ноутбука Юпитера в папке «Примеры».

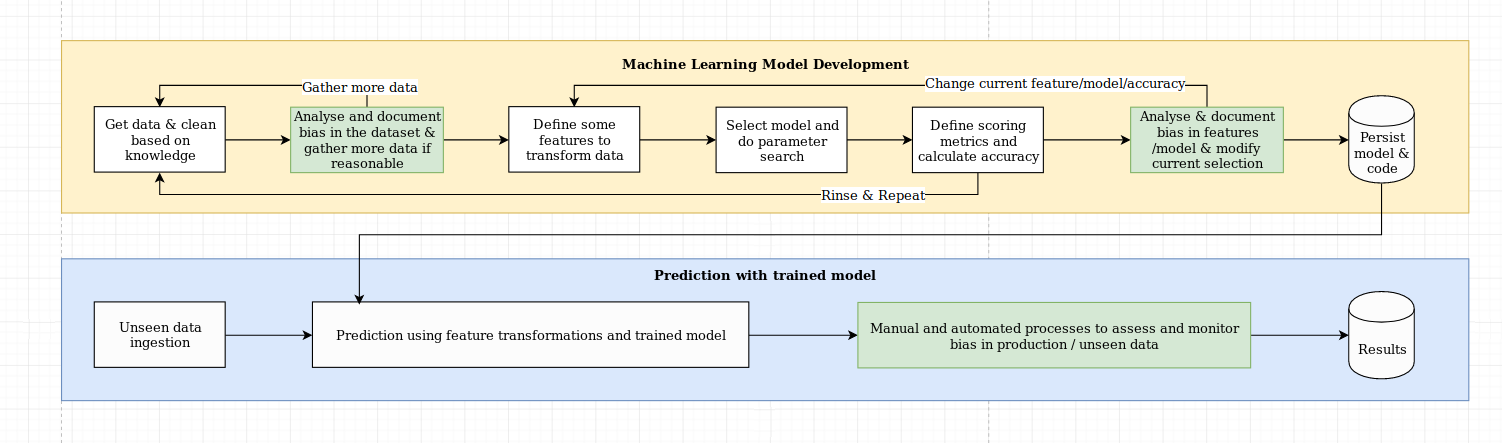

Мы рассматриваем проблему объяснения как нечто большее, чем просто алгоритмическая задача, которая требует комбинации лучших практик науки о данных со знанием специфичных для домена. Библиотека XAI предназначена для расширения возможностей инженеров машинного обучения и соответствующих экспертов по домену для анализа сквозного решения и определения расхождений, которые могут привести к неоптимальной производительности по сравнению с необходимыми целями. В более широком смысле, библиотека XAI разработана с использованием 3-ступенчатых объяснимого машинного обучения, которое включает в себя 1) анализ данных, 2) оценка модели и 3) мониторинг производства.

Мы предоставляем визуальный обзор этих трех шагов, упомянутых выше на этой диаграмме:

Пакет XAI находится на PYPI. Для установки вы можете запустить:

pip install xai

В качестве альтернативы вы можете установить из источника, клонируя репо и запустив:

python setup.py install

Вы можете найти пример использования в папке примеров.

С XAI вы можете определить дисбаланс в данных. Для этого мы загрузим набор данных переписи из библиотеки XAI.

import xai . data

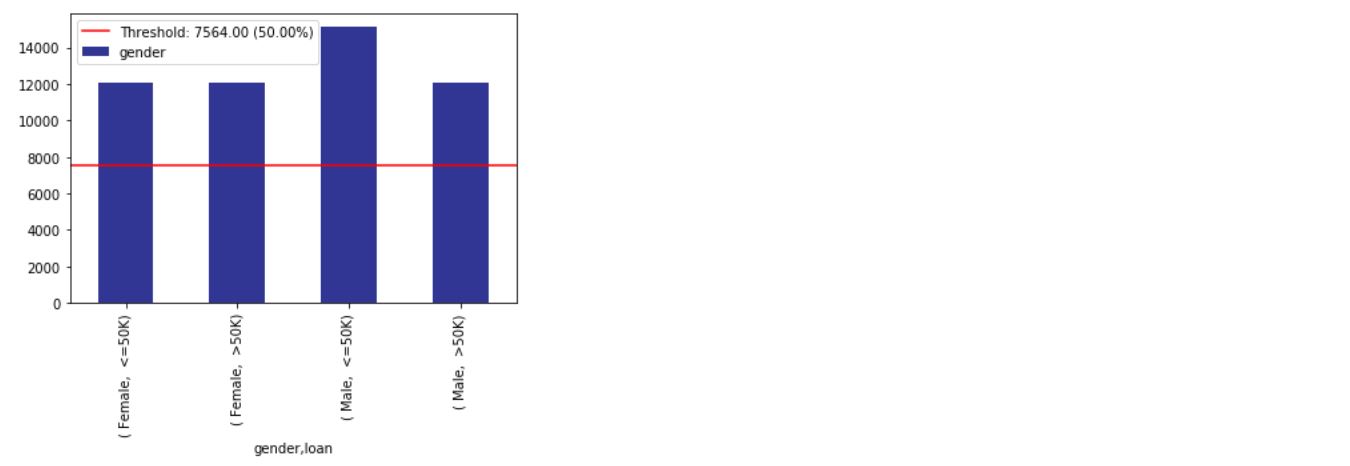

df = xai . data . load_census ()

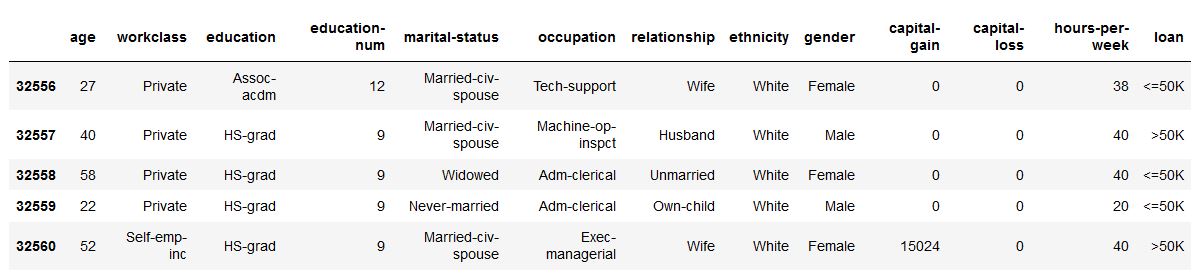

df . head ()

ims = xai . imbalance_plot ( df , "gender" )

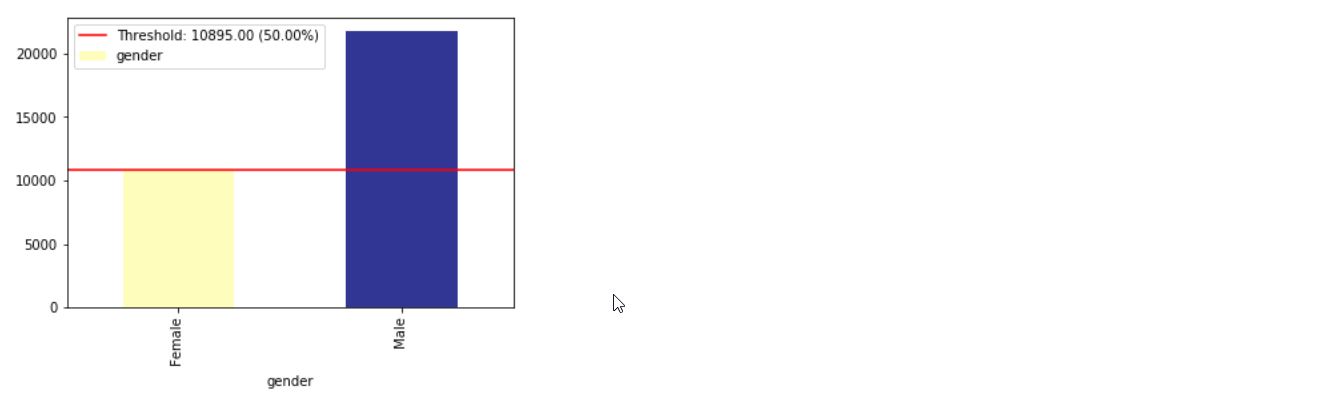

im = xai . imbalance_plot ( df , "gender" , "loan" )

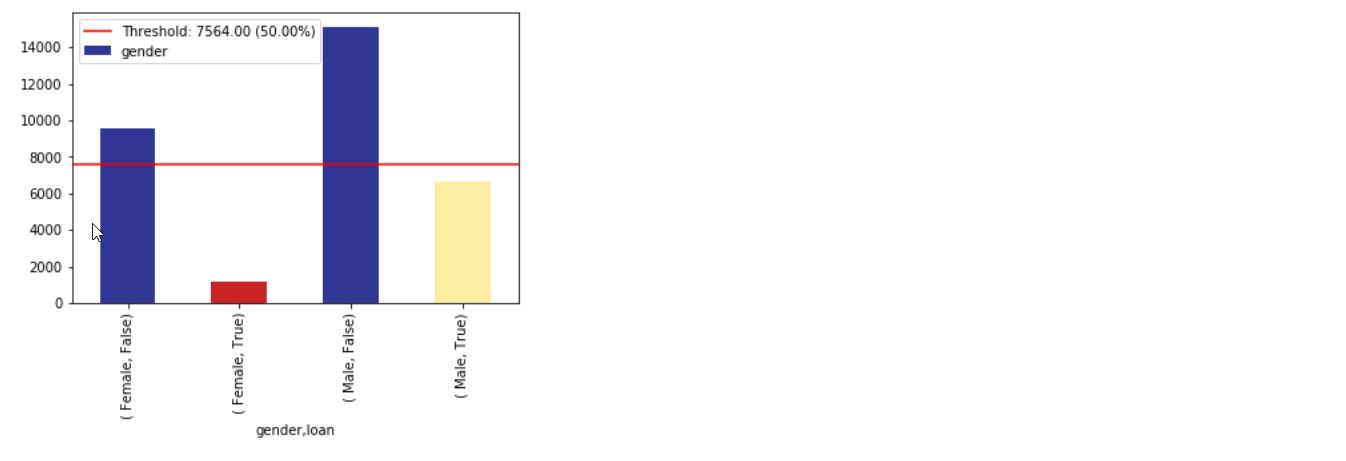

bal_df = xai . balance ( df , "gender" , "loan" , upsample = 0.8 )

groups = xai . group_by_columns ( df , [ "gender" , "loan" ])

for group , group_df in groups :

print ( group )

print ( group_df [ "loan" ]. head (), " n " )

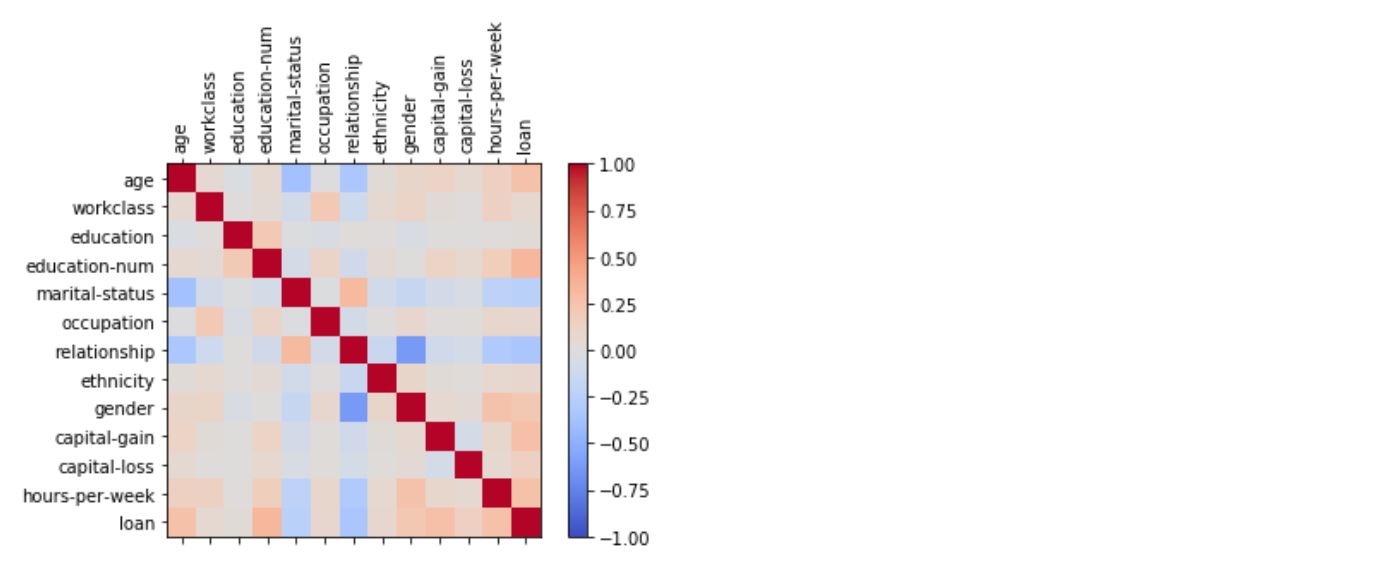

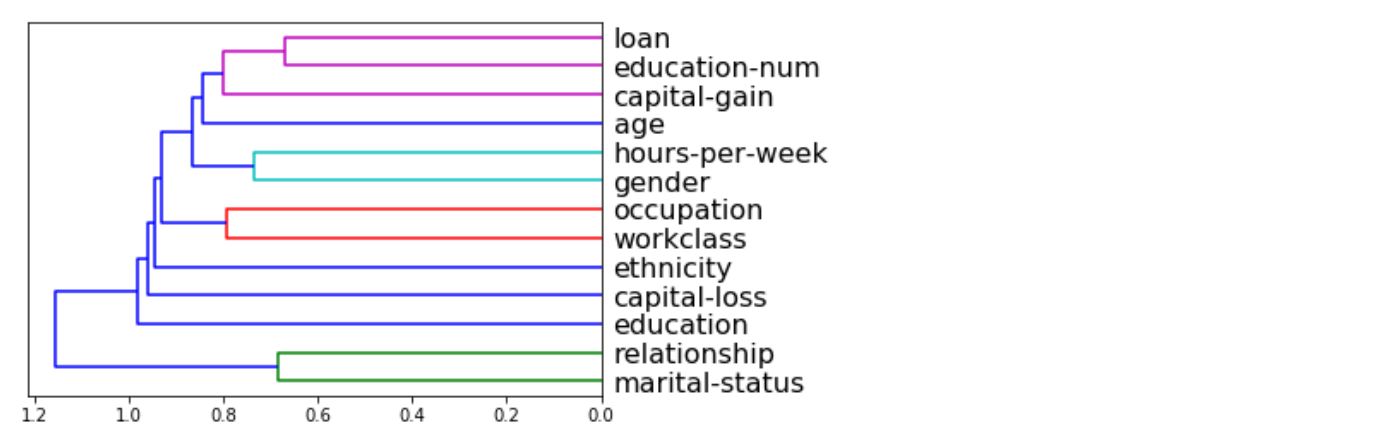

_ = xai . correlations ( df , include_categorical = True , plot_type = "matrix" )

_ = xai . correlations ( df , include_categorical = True )

# Balanced train-test split with minimum 300 examples of

# the cross of the target y and the column gender

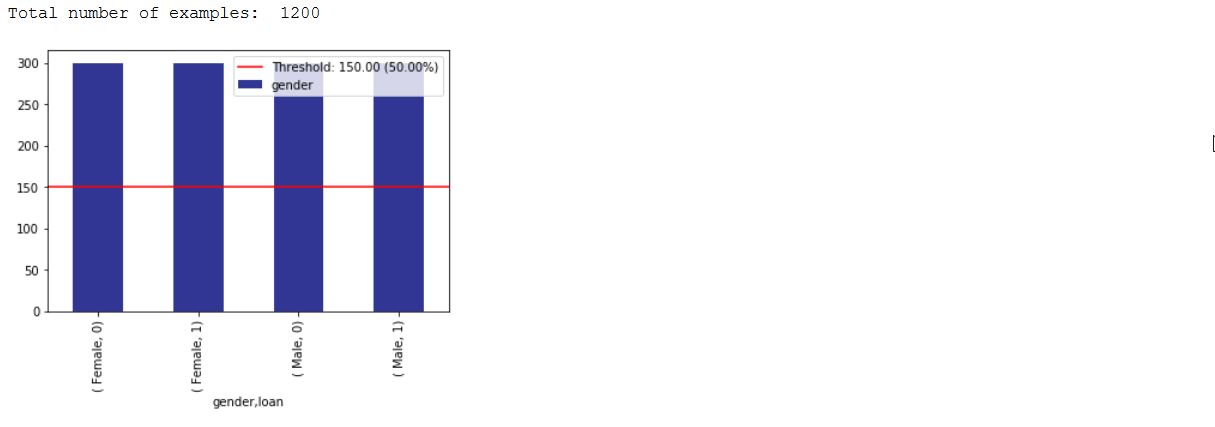

x_train , y_train , x_test , y_test , train_idx , test_idx =

xai . balanced_train_test_split (

x , y , "gender" ,

min_per_group = 300 ,

max_per_group = 300 ,

categorical_cols = categorical_cols )

x_train_display = bal_df [ train_idx ]

x_test_display = bal_df [ test_idx ]

print ( "Total number of examples: " , x_test . shape [ 0 ])

df_test = x_test_display . copy ()

df_test [ "loan" ] = y_test

_ = xai . imbalance_plot ( df_test , "gender" , "loan" , categorical_cols = categorical_cols )

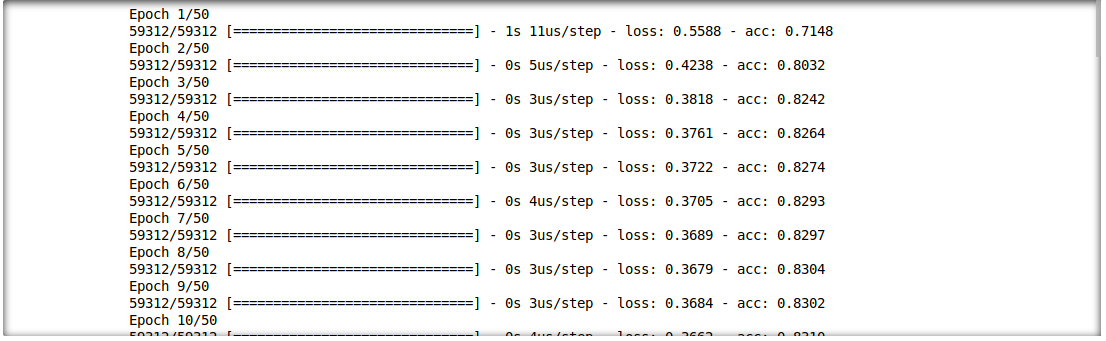

Мы также можем проанализировать взаимодействие между результатами вывода и входными функциями. Для этого мы будем обучать одну модель глубокого обучения.

model = build_model(proc_df.drop("loan", axis=1))

model.fit(f_in(x_train), y_train, epochs=50, batch_size=512)

probabilities = model.predict(f_in(x_test))

predictions = list((probabilities >= 0.5).astype(int).T[0])

def get_avg ( x , y ):

return model . evaluate ( f_in ( x ), y , verbose = 0 )[ 1 ]

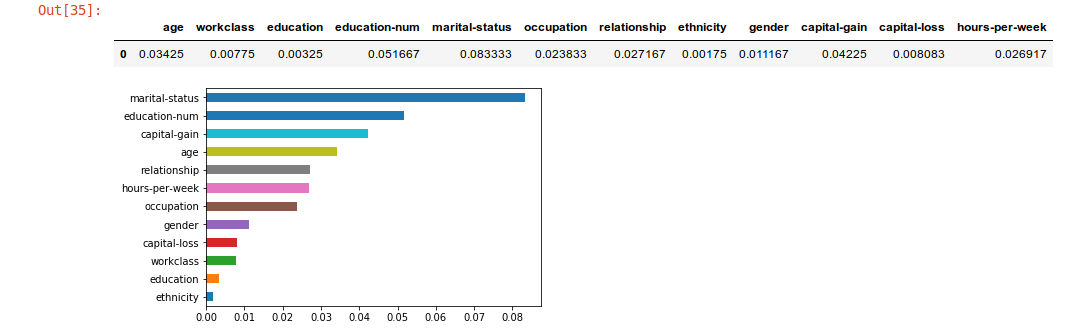

imp = xai . feature_importance ( x_test , y_test , get_avg )

imp . head ()

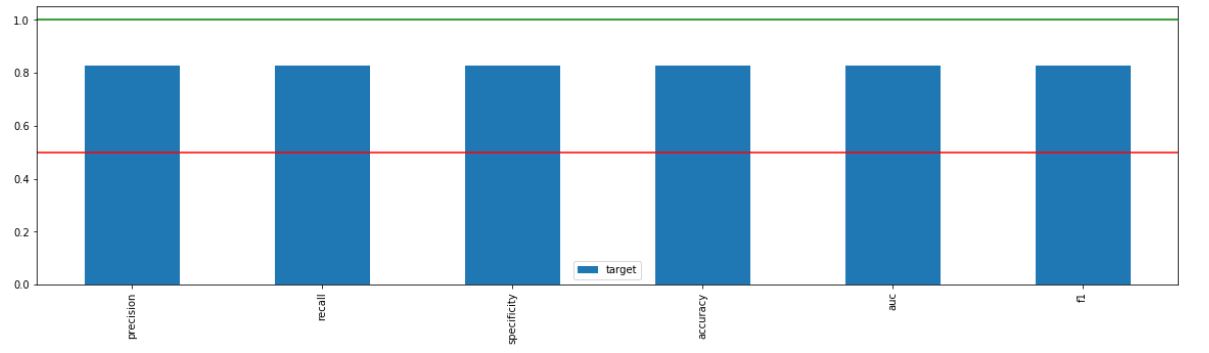

_ = xai . metrics_plot (

y_test ,

probabilities )

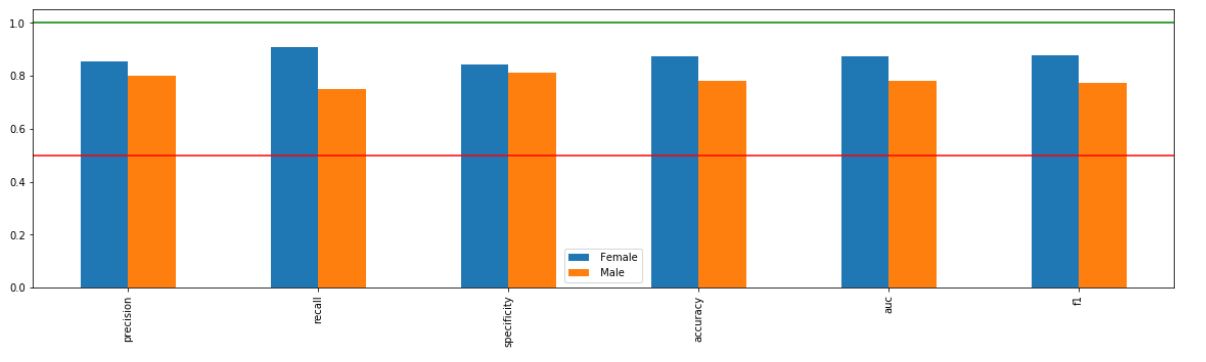

_ = xai . metrics_plot (

y_test ,

probabilities ,

df = x_test_display ,

cross_cols = [ "gender" ],

categorical_cols = categorical_cols )

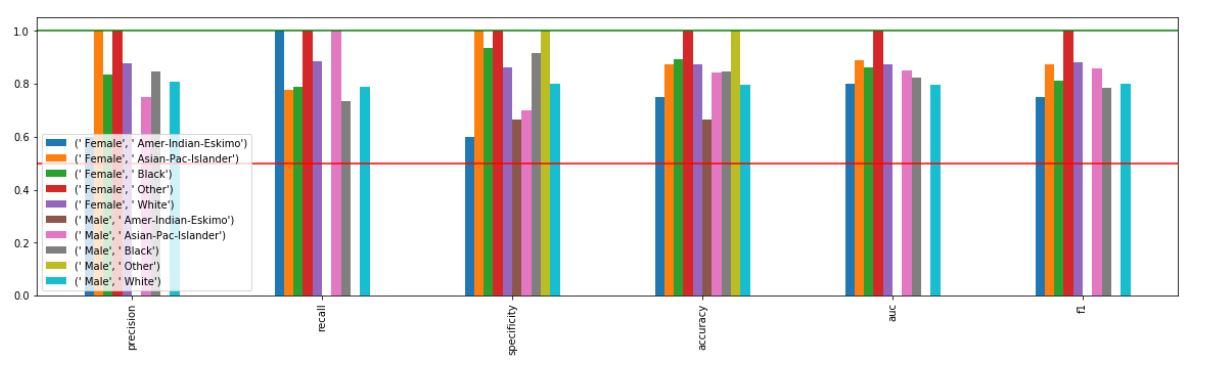

_ = xai . metrics_plot (

y_test ,

probabilities ,

df = x_test_display ,

cross_cols = [ "gender" , "ethnicity" ],

categorical_cols = categorical_cols )

xai . confusion_matrix_plot ( y_test , pred )

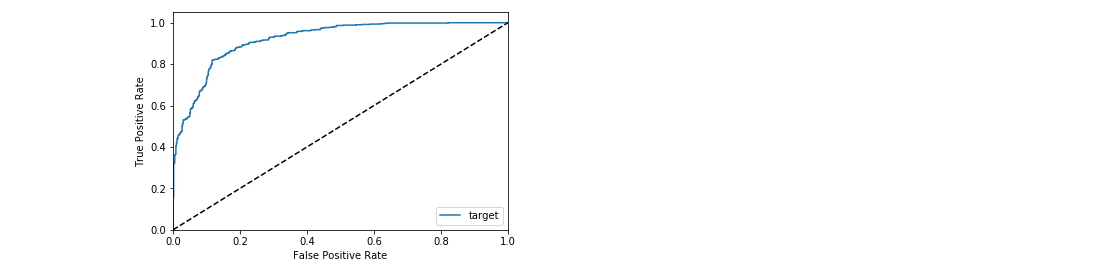

_ = xai . roc_plot ( y_test , probabilities )

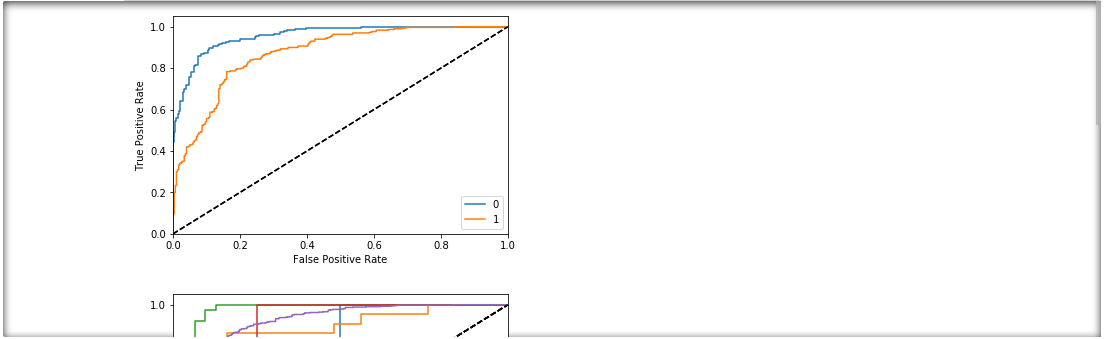

protected = [ "gender" , "ethnicity" , "age" ]

_ = [ xai . roc_plot (

y_test ,

probabilities ,

df = x_test_display ,

cross_cols = [ p ],

categorical_cols = categorical_cols ) for p in protected ]

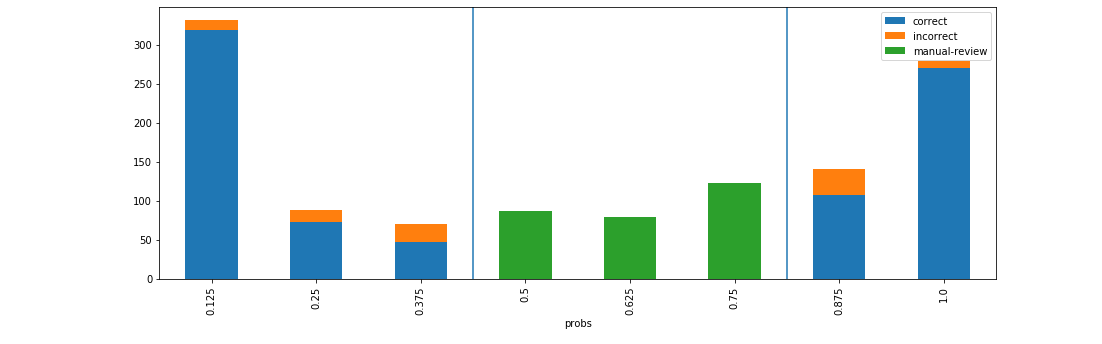

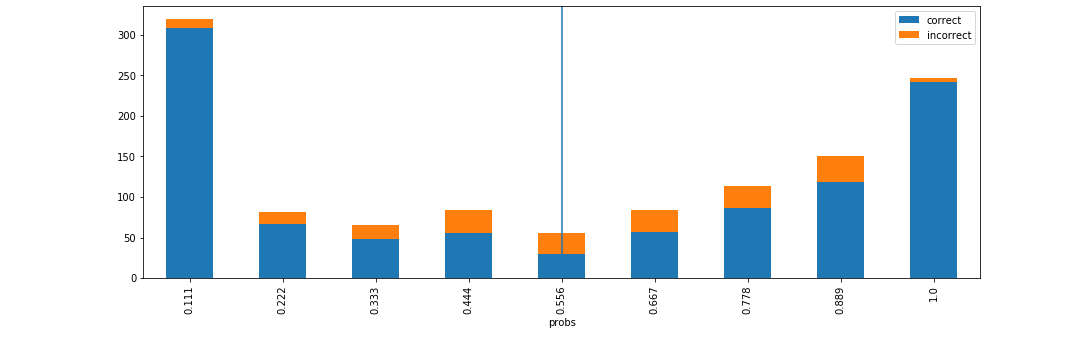

d = xai . smile_imbalance (

y_test ,

probabilities )

d = xai . smile_imbalance (

y_test ,

probabilities ,

display_breakdown = True )

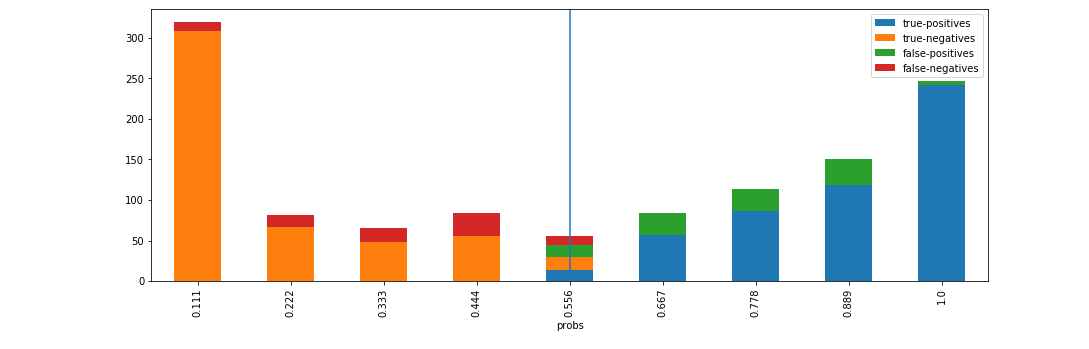

d = xai . smile_imbalance (

y_test ,

probabilities ,

bins = 9 ,

threshold = 0.75 ,

manual_review = 0.375 ,

display_breakdown = False )