Relatórios do editor de downcodes: A equipe DeepMind do Google fez recentemente um grande avanço e desenvolveu com sucesso uma tecnologia inovadora chamada SCoRe (Autocorreção por meio de Aprendizagem por Reforço), que pode resolver efetivamente o problema de autocorreção de grandes modelos de linguagem (LLM). Ao contrário dos métodos anteriores que dependiam de vários modelos ou verificação externa, o SCoRe pode identificar e corrigir erros por si só, trazendo uma nova esperança para a confiabilidade e precisão dos modelos de IA. O núcleo desta tecnologia está em seu método exclusivo de aprendizagem por reforço em dois estágios. O modelo melhora continuamente suas capacidades de correção de erros por meio de autoaprendizagem e melhoria.

A equipe de pesquisa DeepMind do Google recentemente fez um grande avanço e desenvolveu uma tecnologia inovadora chamada SCoRe (autocorreção por meio de aprendizado por reforço, autocorreção por meio de aprendizado por reforço). Esta tecnologia visa resolver o desafio de longa data de que grandes modelos de linguagem (LLMs) têm problemas para se autocorrigir, identificar e corrigir erros sem depender de vários modelos ou verificações externas.

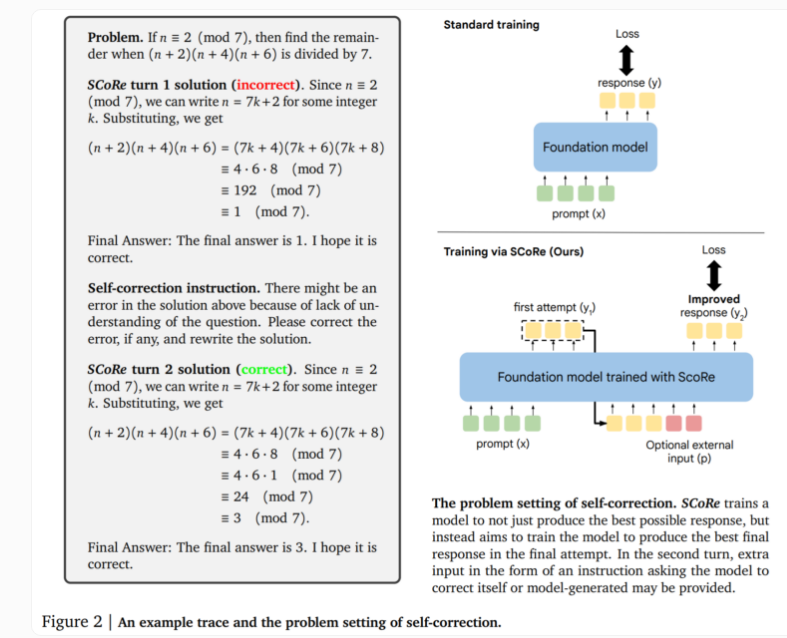

O núcleo da tecnologia SCoRe reside na sua abordagem em duas etapas. O primeiro estágio otimiza a inicialização do modelo para que ele possa gerar correções na segunda tentativa, mantendo a similaridade da resposta inicial com o modelo base. O segundo estágio usa aprendizado por reforço em vários estágios para ensinar ao modelo como melhorar a primeira e a segunda respostas. Esta abordagem é única porque utiliza apenas dados de treinamento autogerados, com o modelo criando seus próprios exemplos resolvendo o problema e tentando melhorar a solução.

Em testes reais, o SCoRe apresentou melhorias significativas de desempenho. Testes usando os modelos Gemini 1.0 Pro e 1.5 Flash do Google mostraram uma melhoria de 15,6 pontos percentuais na autocorreção na tarefa de raciocínio matemático do benchmark MATH. Na tarefa de geração de código da HumanEval, o desempenho melhorou 9,1 pontos percentuais. Estes resultados demonstram que o SCoRe fez progressos substanciais na melhoria das capacidades de autocorreção dos modelos de IA.

Os pesquisadores destacam que o SCoRe é o primeiro método para alcançar uma autocorreção intrínseca positiva significativa, permitindo ao modelo melhorar suas respostas sem feedback externo. No entanto, a versão atual do SCoRe realiza apenas uma rodada de treinamento de autocorreção, e pesquisas futuras poderão explorar a possibilidade de múltiplas etapas de correção.

Esta pesquisa da equipe DeepMind revela um insight importante: ensinar metaestratégias autocorretivas requer ir além dos métodos padrão de treinamento de modelos de linguagem. A aprendizagem por reforço em várias fases abre novas possibilidades no domínio da IA e espera-se que promova o desenvolvimento de sistemas de IA mais inteligentes e fiáveis.

Esta tecnologia inovadora não só demonstra o potencial de auto-aperfeiçoamento da IA, mas também fornece novas ideias para resolver os problemas de fiabilidade e precisão dos modelos de linguagem em grande escala, o que pode ter um impacto profundo no desenvolvimento de futuras aplicações de IA.

O surgimento da tecnologia SCoRe marca um marco no campo das capacidades de autocorreção no campo da IA, estabelecendo uma base sólida para a construção de sistemas de IA mais confiáveis e inteligentes. O editor do Downcodes espera a aplicação da tecnologia SCoRe em mais campos no futuro, injetando nova vitalidade no desenvolvimento da inteligência artificial.