Rapports de l'éditeur de downcodes : l'équipe DeepMind de Google a récemment réalisé une percée majeure et développé avec succès une technologie innovante appelée SCoRe (Self-Correction through Reinforcement Learning), qui peut résoudre efficacement le problème d'autocorrection des grands modèles de langage (LLM). Contrairement aux méthodes précédentes qui reposaient sur plusieurs modèles ou une vérification externe, SCoRe peut identifier et corriger les erreurs par elle-même, apportant ainsi un nouvel espoir quant à la fiabilité et à la précision des modèles d'IA. Le cœur de cette technologie réside dans sa méthode unique d'apprentissage par renforcement en deux étapes. Le modèle améliore continuellement ses capacités de correction d'erreurs grâce à l'auto-apprentissage et à l'amélioration.

L'équipe de recherche DeepMind de Google a récemment réalisé une percée majeure et développé une technologie innovante appelée SCoRe (Self-Correction through Reinforcement Learning, autocorrection grâce à l'apprentissage par renforcement). Cette technologie vise à résoudre le problème de longue date selon lequel les grands modèles de langage (LLM) ont du mal à s'auto-corriger, à identifier et à corriger les erreurs sans s'appuyer sur plusieurs modèles ou contrôles externes.

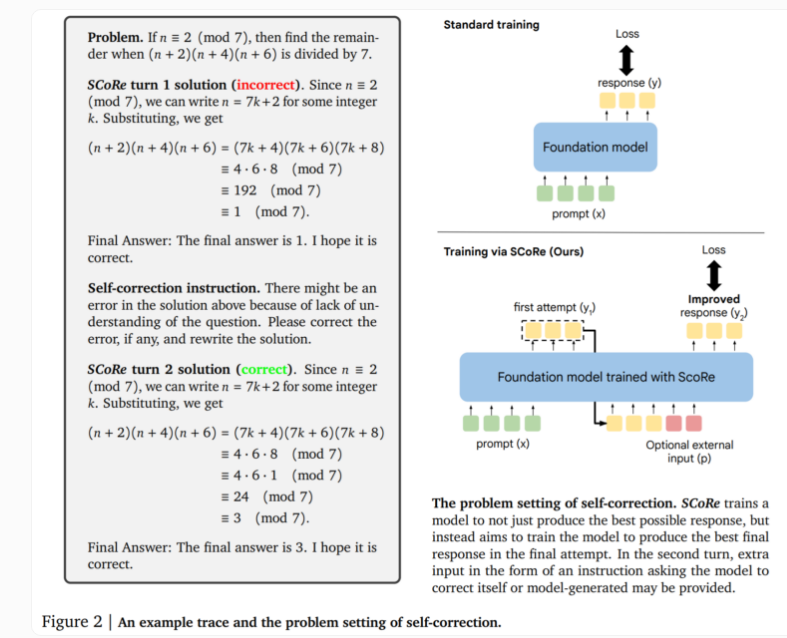

Le cœur de la technologie SCoRe réside dans son approche en deux étapes. La première étape optimise l'initialisation du modèle afin qu'il puisse générer des corrections au deuxième essai tout en conservant la similarité de la réponse initiale avec le modèle de base. La deuxième étape utilise un apprentissage par renforcement en plusieurs étapes pour apprendre au modèle comment améliorer les première et deuxième réponses. Cette approche est unique dans la mesure où elle utilise uniquement des données de formation auto-générées, le modèle créant ses propres exemples en résolvant le problème et en essayant d'améliorer la solution.

Lors de tests réels, SCoRe a montré des améliorations significatives des performances. Les tests utilisant les modèles Gemini 1.0 Pro et 1.5 Flash de Google ont montré une amélioration de 15,6 points de pourcentage de l'autocorrection sur la tâche de raisonnement mathématique du benchmark MATH. Dans la tâche de génération de code de HumanEval, les performances se sont améliorées de 9,1 points de pourcentage. Ces résultats démontrent que SCoRe a réalisé des progrès substantiels dans l’amélioration des capacités d’autocorrection des modèles d’IA.

Les chercheurs soulignent que SCoRe est la première méthode permettant d’obtenir une autocorrection intrinsèque positive significative, permettant au modèle d’améliorer ses réponses sans retour externe. Cependant, la version actuelle de SCoRe n’effectue qu’un seul cycle de formation à l’autocorrection, et des recherches futures pourraient explorer la possibilité de plusieurs étapes de correction.

Cette recherche de l’équipe DeepMind révèle un aperçu important : l’enseignement de méta-stratégies autocorrectrices nécessite d’aller au-delà des méthodes standard de formation des modèles de langage. L’apprentissage par renforcement en plusieurs étapes ouvre de nouvelles possibilités dans le domaine de l’IA et devrait promouvoir le développement de systèmes d’IA plus intelligents et plus fiables.

Cette technologie révolutionnaire démontre non seulement le potentiel d’auto-amélioration de l’IA, mais fournit également de nouvelles idées pour résoudre les problèmes de fiabilité et de précision des modèles de langage à grande échelle, ce qui pourrait avoir un impact profond sur le développement des futures applications de l’IA.

L'émergence de la technologie SCoRe marque une étape importante dans le domaine des capacités d'autocorrection dans le domaine de l'IA, établissant une base solide pour la construction de systèmes d'IA plus fiables et plus intelligents. L'éditeur de Downcodes attend avec impatience l'application de la technologie SCoRe dans davantage de domaines à l'avenir, injectant une nouvelle vitalité dans le développement de l'intelligence artificielle.