Equipes de pesquisa da Universidade de Pequim e do Alibaba lançaram em conjunto um novo benchmark de avaliação de habilidades matemáticas Omni-MATH, que é usado para avaliar as capacidades de raciocínio de grandes modelos de linguagem no nível da Competição Matemática das Olimpíadas. O benchmark contém 4.428 questões de nível de competição cobrindo mais de 33 subcampos da matemática, com níveis de dificuldade que vão desde o nível preparatório olímpico até o nível de competição superior, e é verificado manualmente para garantir alta confiabilidade das respostas. O lançamento do Omni-MATH fornece novos padrões e formas de explorar o potencial da IA no campo da matemática avançada e também fornece uma ferramenta mais abrangente para avaliar as capacidades de raciocínio matemático de grandes modelos de linguagem. O editor de Downcodes explicará em detalhes o design exclusivo, o sistema de avaliação e os métodos de avaliação inovadores do Omni-MATH.

Como o GPT-4 da OpenAI alcançou repetidamente excelentes resultados em avaliações matemáticas tradicionais, as equipes de pesquisa da Universidade de Pequim e do Alibaba lançaram conjuntamente um novo benchmark de avaliação - Omni-MATH, projetado para avaliar o desempenho de grandes modelos de linguagem no nível da Competição Matemática das Olimpíadas. Habilidades de raciocínio. Esta iniciativa não só fornece um novo padrão para a avaliação das capacidades matemáticas da IA, mas também abre uma nova forma de explorar o potencial da IA no campo da matemática avançada.

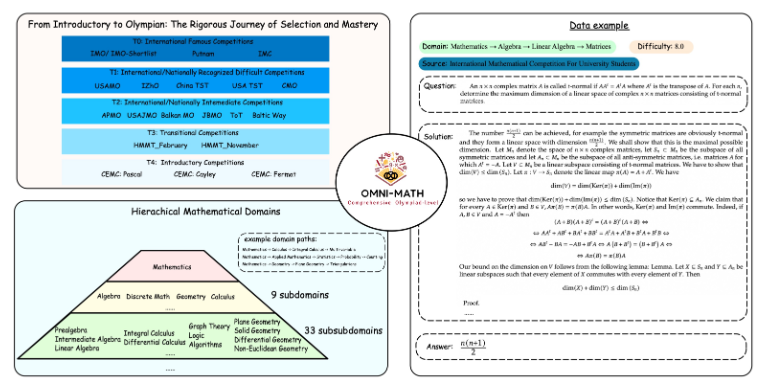

Design exclusivo do Omni-MATH

A biblioteca de avaliação Omni-MATH contém 4.428 questões matemáticas de nível competitivo, cobrindo mais de 33 subcampos da matemática, com 10 níveis diferentes de dificuldade. Os recursos incluem:

Alta confiabilidade: Todas as perguntas vêm de várias competições e fóruns de matemática, e as respostas são verificadas manualmente.

Ampla cobertura: desde o nível preparatório para Olimpíadas (T4) até as principais competições de matemática para Olimpíadas (T0), como IMO, IMC e Putnam, etc.

Consideração da diversidade: A questão da diversidade de respostas é otimizada através de métodos de avaliação baseados em GPT-4 e outros modelos de avaliação.

Nas últimas classificações, além da versão full-blood GPT-4, os melhores desempenhos incluem:

GPT-4-mini: a pontuação média é cerca de 8% maior que a visualização do GPT-4

Qwen2-MATH-72b: Excedeu os resultados do GPT-4-turbo

Esses resultados mostram que mesmo modelos pequenos podem ter um bom desempenho em recursos específicos.

A profundidade e amplitude do sistema de avaliação

O design do Omni-MATH leva em consideração o processo de seleção e o nível de dificuldade das competições internacionais de matemática:

Consulte os sistemas de seleção das Olimpíadas de Matemática em países como o Reino Unido e os Estados Unidos.

Abrange muitas áreas da matemática, da teoria dos números à álgebra e à geometria

As fontes de dados incluem várias questões de competição, análises e conteúdo de fóruns em sites famosos de matemática.

Métodos de avaliação inovadores

A equipe de pesquisa desenvolveu o verificador de respostas de código aberto Omni-Judge, que usa o modelo Llama3-Instruct ajustado para determinar rapidamente a consistência entre a saída do modelo e a resposta padrão. Este método não só garante uma taxa de consistência de 95%, mas também fornece uma solução conveniente para a avaliação de problemas matemáticos complexos.

O lançamento do Omni-MATH não é apenas um novo desafio para as capacidades matemáticas da IA, mas também fornece uma importante ferramenta de avaliação para a futura aplicação e desenvolvimento da IA no campo da matemática avançada. Com o avanço contínuo da tecnologia de IA, poderemos testemunhar o incrível desempenho da IA na competição das Olimpíadas de Matemática em um futuro próximo.

Endereço do projeto: https://github.com/KbsdJames/Omni-MATH/

Em suma, o surgimento do Omni-MATH marca um novo patamar na avaliação da capacidade matemática da IA. Ele fornece aos pesquisadores e desenvolvedores ferramentas e dados valiosos e promove o desenvolvimento contínuo da IA no campo da matemática. No futuro, à medida que o Omni-MATH continuar a ser melhorado e atualizado, acredito que desempenhará um papel mais importante no campo da matemática da IA.