Les équipes de recherche de l'Université de Pékin et d'Alibaba ont publié conjointement une nouvelle référence d'évaluation des capacités mathématiques, Omni-MATH, qui est utilisée pour évaluer les capacités de raisonnement de grands modèles de langage au niveau du concours mathématique de l'Olympiade. Le benchmark contient 4 428 questions de niveau compétition couvrant plus de 33 sous-domaines des mathématiques, avec des niveaux de difficulté allant du niveau préparatoire olympique au niveau de compétition de haut niveau, et est vérifié manuellement pour garantir une grande fiabilité des réponses. Le lancement d'Omni-MATH fournit de nouvelles normes et moyens d'explorer le potentiel de l'IA dans le domaine des mathématiques avancées, et fournit également un outil plus complet pour évaluer les capacités de raisonnement mathématique des grands modèles de langage. L'éditeur de Downcodes expliquera en détail la conception unique, le système d'évaluation et les méthodes d'évaluation innovantes d'Omni-MATH.

Alors que GPT-4 d'OpenAI a obtenu à plusieurs reprises d'excellents résultats dans les évaluations mathématiques traditionnelles, les équipes de recherche de l'Université de Pékin et d'Alibaba ont lancé conjointement un nouveau référentiel d'évaluation - Omni-MATH, conçu pour évaluer les performances de grands modèles de langage au niveau du concours mathématique de l'Olympiade. Capacités de raisonnement. Cette initiative fournit non seulement une nouvelle norme pour l’évaluation des capacités mathématiques de l’IA, mais ouvre également une nouvelle voie pour explorer le potentiel de l’IA dans le domaine des mathématiques avancées.

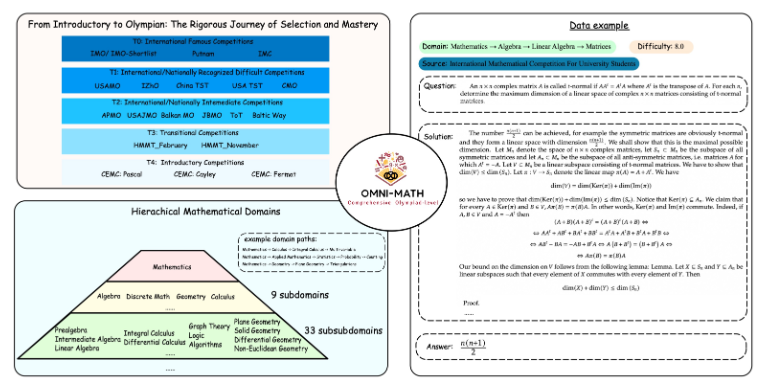

La conception unique d'Omni-MATH

La bibliothèque d'évaluation Omni-MATH contient 4 428 questions mathématiques de niveau concours, couvrant plus de 33 sous-domaines mathématiques, avec 10 niveaux de difficulté différents. Les fonctionnalités incluent :

Haute fiabilité : toutes les questions proviennent de divers concours et forums de mathématiques, et les réponses sont vérifiées manuellement.

Large couverture : du niveau préparatoire aux Olympiades (T4) aux meilleures compétitions de mathématiques des Olympiades (T0) telles que l'OMI, l'IMC et Putnam, etc.

Considération de la diversité : la question de la diversité des réponses est optimisée grâce à des méthodes d'évaluation basées sur GPT-4 et d'autres modèles d'évaluation.

Dans le dernier classement, en plus de la version pure GPT-4, les artistes exceptionnels incluent :

GPT-4-mini : le score moyen est environ 8 % plus élevé que celui de GPT-4-preview

Qwen2-MATH-72b : a dépassé les résultats de GPT-4-turbo

Ces résultats montrent que même les petits modèles peuvent fonctionner correctement avec des capacités spécifiques.

La profondeur et l’étendue du système d’évaluation

La conception d'Omni-MATH prend pleinement en compte le processus de sélection et le niveau de difficulté des concours internationaux de mathématiques :

Reportez-vous aux systèmes de sélection des Olympiades mathématiques dans des pays comme le Royaume-Uni et les États-Unis.

Couvre de nombreux domaines des mathématiques, de la théorie des nombres à l'algèbre en passant par la géométrie.

Les sources de données comprennent diverses questions de concours, analyses et contenus de forums sur des sites Web mathématiques célèbres.

Des méthodes d'évaluation innovantes

L'équipe de recherche a développé le vérificateur de réponses open source Omni-Judge, qui utilise le modèle Llama3-Instruct affiné pour déterminer rapidement la cohérence entre la sortie du modèle et la réponse standard. Cette méthode garantit non seulement un taux de cohérence de 95 %, mais constitue également une solution pratique pour l’évaluation de problèmes mathématiques complexes.

Le lancement d'Omni-MATH constitue non seulement un nouveau défi pour les capacités mathématiques de l'IA, mais fournit également un outil d'évaluation important pour les applications et le développement futurs de l'IA dans le domaine des mathématiques avancées. Grâce aux progrès continus de la technologie de l’IA, nous pourrons peut-être assister dans un avenir proche aux performances étonnantes de l’IA lors de la compétition des Olympiades mathématiques.

Adresse du projet : https://github.com/KbsdJames/Omni-MATH/

Dans l’ensemble, l’émergence d’Omni-MATH marque une nouvelle étape dans l’évaluation des capacités mathématiques de l’IA. Elle fournit aux chercheurs et aux développeurs des outils et des données précieux et favorise le développement continu de l’IA dans le domaine des mathématiques. À l’avenir, à mesure qu’Omni-MATH continuera d’être amélioré et mis à jour, je pense qu’il jouera un rôle plus important dans le domaine des mathématiques de l’IA.