Forschungsteams der Peking-Universität und Alibaba haben gemeinsam einen neuen Benchmark zur Bewertung mathematischer Fähigkeiten, Omni-MATH, veröffentlicht, der zur Bewertung der Argumentationsfähigkeiten großer Sprachmodelle auf der Ebene des Olympiade-Mathematikwettbewerbs verwendet wird. Der Benchmark enthält 4.428 Fragen auf Wettbewerbsebene, die mehr als 33 Teilgebiete der Mathematik abdecken, mit Schwierigkeitsgraden vom olympischen Vorbereitungsniveau bis zum höchsten Wettbewerbsniveau, und wird manuell überprüft, um eine hohe Zuverlässigkeit der Antworten sicherzustellen. Die Einführung von Omni-MATH bietet neue Standards und Möglichkeiten zur Erforschung des Potenzials von KI im Bereich der fortgeschrittenen Mathematik und stellt außerdem ein umfassenderes Tool zur Bewertung der mathematischen Argumentationsfähigkeiten großer Sprachmodelle bereit. Der Herausgeber von Downcodes wird das einzigartige Design, das Bewertungssystem und die innovativen Bewertungsmethoden von Omni-MATH ausführlich erläutern.

Da GPT-4 von OpenAI bei traditionellen Mathematikbewertungen wiederholt hervorragende Ergebnisse erzielt hat, haben Forschungsteams der Peking-Universität und Alibaba gemeinsam einen neuen Bewertungsbenchmark eingeführt – Omni-MATH, der darauf ausgelegt ist, die Leistung großer Sprachmodelle auf der Ebene des Olympiade-Mathematikwettbewerbs zu bewerten. Argumentationsfähigkeiten. Diese Initiative bietet nicht nur einen neuen Standard für die Bewertung der mathematischen Fähigkeiten der KI, sondern eröffnet auch eine neue Möglichkeit, das Potenzial der KI im Bereich der fortgeschrittenen Mathematik zu erkunden.

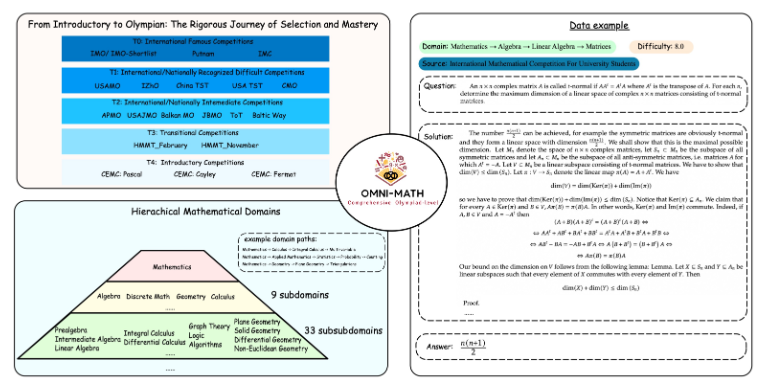

Das einzigartige Design von Omni-MATH

Die Omni-MATH-Bewertungsbibliothek enthält 4.428 Mathematikfragen auf Wettbewerbsebene, die mehr als 33 Teilbereiche der Mathematik mit 10 verschiedenen Schwierigkeitsgraden abdecken. Zu den Funktionen gehören:

Hohe Zuverlässigkeit: Alle Fragen stammen aus verschiedenen Mathematikwettbewerben und Foren und die Antworten werden manuell überprüft.

Breite Abdeckung: von der Olympia-Vorbereitungsstufe (T4) bis hin zu den wichtigsten Olympia-Mathematikwettbewerben (T0) wie IMO, IMC und Putnam usw.

Diversitätsberücksichtigung: Die Frage nach der Antwortvielfalt wird durch Bewertungsmethoden auf Basis von GPT-4 und anderen Bewertungsmodellen optimiert.

Zu den herausragenden Leistungsträgern der aktuellen Rangliste gehören neben der GPT-4-Vollblutversion auch:

GPT-4-mini: Die durchschnittliche Punktzahl ist etwa 8 % höher als bei GPT-4-Preview

Qwen2-MATH-72b: Die Ergebnisse von GPT-4-Turbo wurden übertroffen

Diese Ergebnisse zeigen, dass selbst kleine Modelle bei bestimmten Funktionen eine gute Leistung erbringen können.

Die Tiefe und Breite des Bewertungssystems

Das Design von Omni-MATH berücksichtigt vollständig den Auswahlprozess und den Schwierigkeitsgrad internationaler Mathematikwettbewerbe:

Beachten Sie die Auswahlsysteme für die Mathematikolympiade in Ländern wie dem Vereinigten Königreich und den Vereinigten Staaten.

Deckt viele Bereiche der Mathematik ab, von der Zahlentheorie über die Algebra bis zur Geometrie

Zu den Datenquellen gehören verschiedene Wettbewerbsfragen, Analysen und Foreninhalte auf bekannten Mathematik-Websites

Innovative Bewertungsmethoden

Das Forschungsteam entwickelte den Open-Source-Antwortverifizierer Omni-Judge, der das fein abgestimmte Llama3-Instruct-Modell verwendet, um schnell die Konsistenz zwischen der Modellausgabe und der Standardantwort zu bestimmen. Diese Methode gewährleistet nicht nur eine Konsistenzrate von 95 %, sondern bietet auch eine praktische Lösung für die Bewertung komplexer mathematischer Probleme.

Die Einführung von Omni-MATH stellt nicht nur eine neue Herausforderung für die mathematischen Fähigkeiten der KI dar, sondern bietet auch ein wichtiges Bewertungsinstrument für die zukünftige Anwendung und Entwicklung von KI im Bereich der fortgeschrittenen Mathematik. Mit der kontinuierlichen Weiterentwicklung der KI-Technologie können wir möglicherweise in naher Zukunft die erstaunliche Leistung der KI im Wettbewerb der Mathematikolympiade miterleben.

Projektadresse: https://github.com/KbsdJames/Omni-MATH/

Alles in allem markiert das Aufkommen von Omni-MATH einen neuen Höhepunkt bei der Bewertung der mathematischen Fähigkeiten der KI. Es stellt Forschern und Entwicklern wertvolle Werkzeuge und Daten zur Verfügung und fördert die kontinuierliche Entwicklung der KI im Bereich der Mathematik. Da Omni-MATH in Zukunft weiter verbessert und aktualisiert wird, glaube ich, dass es im Bereich der KI-Mathematik eine größere Rolle spielen wird.