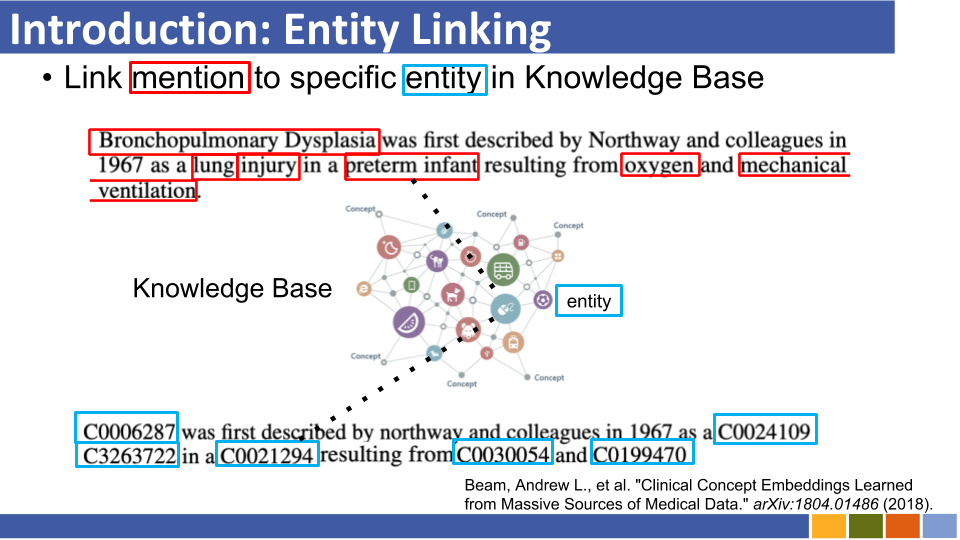

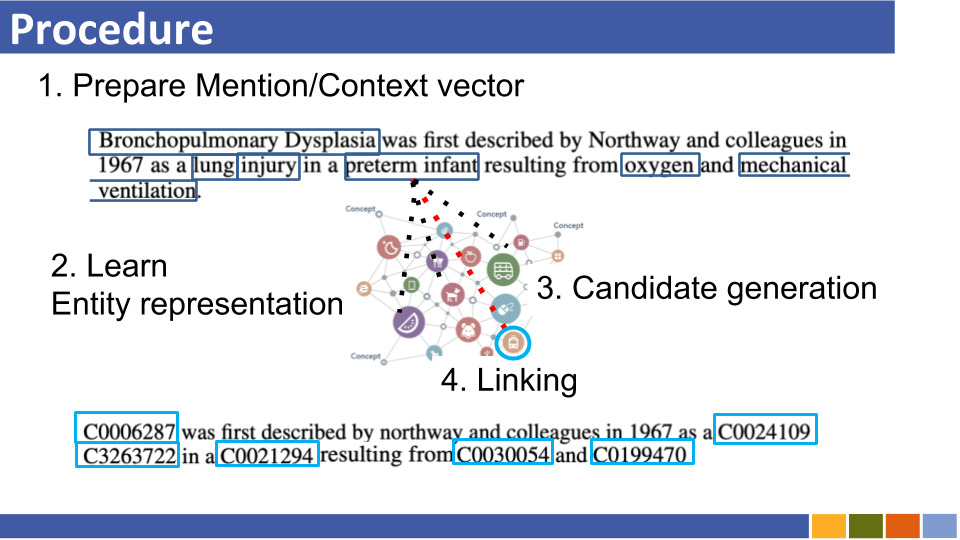

Este repositório tem como objetivo rastrear o progresso na entidade vinculando. Estudos sobre como preparar representações de entidades também são listados, pois as representações de entidades são obrigatórias com a ligação da entidade.

Recuperação de entidade autoregressiva

Os sistemas de vinculação de entidades tradicionais sofrem de consumo de memória devido à codificação prévia de entidades na base de conhecimento, custo de recurso computacional devido à comparação de todas as entidades na base de conhecimento e problemas de partida a frio.

Em vez da arquitetura anterior, eles exploram uma sequência a sequência para gerar nomes de entidades de uma maneira autoregressiva condicionada ao contexto. Eles usaram a pesquisa de feixe restrito, forçando apenas para decodificar o identificador de entidade válido.

Vinculando entidades a bases de conhecimento invisíveis com esquemas arbitrários

Os sistemas de vinculação de entidades tradicionais assumem que o esquema da base de conhecimento que une as entidades previstas é conhecido. Eles propuseram um novo método para converter o esquema de entidades desconhecidas para a incorporação de Bert usando atributos e tokens auxiliares.

Ao mesmo tempo, eles também propuseram um método de treinamento para lidar com atributos desconhecidos.

Em mídia res: um corpus para avaliar a entidade nomeada vinculando com obras criativas [Paper] [códigos]

Lucas: Representações de entidades contextualizadas profundas com auto-atimento com reconhecimento de entidade [link] [códigos]

Eles propuseram uma nova tarefa de pré-treinamento com base em Bert, na qual as palavras e entidades mascaradas aleatoriamente são previstas em corpus indicados pela entidade da Wikipedia.

Também na tarefa de pré-treinamento, eles propuseram uma versão estendida do transformador, que considera uma auto-distribuição consciente da entidade e os tipos de tokens (palavras ou entidades) ao calcular as pontuações de atenção.

Entidade zero escalável que liga com uma densa recuperação de entidades

Entidade vinculando em 100 idiomas [papel]

COMETA: Um corpus para entidade médica que liga as mídias sociais [artigo]

Entidade zero-tiro ligando com modelagem de sequência de longo alcance eficiente [papel]

De zero a herói: entidade humano no loop ligando em domínios baixos de recursos [link]

Melhorando a entidade vinculando através de incorporações de entidade reforçada semântica

Enciclopédia pré-treinada: Modelo de Idioma pré-adquirido com conhecimento fracamente supervisionado (ICLR'20) [Paper]

K-Adapter: Infusando o conhecimento em modelos pré-treinados com adaptadores [papel]

Melhorando a entidade vinculando modelando o papel do tipo de entidade latente (AAAI'20)

Entidade zero-tiro que liga com densa recuperação de entidades (10º, novembro)

Semelhante a [Logeswaran, et al., ACL'19] e [Gillick, et al., Conll'19]

Slides (não oficial)

Entidade vinculando através de codificadores duplos e cruzados [arxiv]

Avaliação de granulação fina para vinculação de entidades (EMNLP'19)

Aumentação de contexto dinâmico de aprendizado para a entidade global Linking (EMNLP'19)

Entidade de grão fino digitando a entidade independente de domínio

Investigando o conhecimento da entidade em Bert com a entidade de ponta a ponta neural simples (Conll '19) [Paper]

Aprendendo representações densas para recuperação de entidades (conll '19)

papel, repo

Eles não propuseram uso da tabela de alias (que foi baseada nas estatísticas da Wikipedia ou preparada) e pesquisando todas as entidades por forca bruta/busca mais próxima aproximada por vincular entidade por menção.

Enteval: um benchmark de avaliação holística para representações de entidades (EMNLP '19)

Representações de entidade de aprendizagem para a reconstrução de poucas categorias da Wikipedia (ICLR '19)

Representações contextuais de palavras contextuais aprimoradas do conhecimento (EMNLP '19) [Paper]

As tendências de alavancar todas as informações (por exemplo, tipo e definição e documentos em que a menção existe, etc ...) parece estar desaparecendo.

Embora o domínio da Wikipedia possa usar seu hiperlink (= pares de mencionação-entidade, cerca de 7.500.000) para o modelo de vinculação de treinamento, em algumas situações específicas de domínio, não há muitos pares de mencionação.

Portanto, alguns documentos agora estão desafiando o aprendizado distante e o aprendizado zero da entidade vinculando.

Aprendizado distante

Aprendizagem distante para a entidade vinculando com detecção automática de ruído

Slides (não oficial)

Eles propuseram o enquadramento do EL como um problema de aprendizado distante, no qual não há dados de treinamento rotulados e modelo de desmontagem para esta tarefa.

Aumentar a entidade que vincula o desempenho alavancando documentos não marcados

Vinculando com tiro zero

Entidade zero shot vinculando as descrições da entidade lendo

Slides (não oficial)

Eles propuseram o Zero Shot EL, sob o qual nenhum teste pode ser visto durante o treinamento. Para combater o Zero Shot EL, eles propuseram a estratégia adaptativa de domínio para o modelo de idioma pré-treinamento. Além disso, eles mostraram que a descrição da descrição da mencionação é crucial para o EL.

A aprendizagem de representação de entidades baseada em Bert também surgiu.

(Comentado em 19 de novembro de 19 ') Naqueles dias, pesquisas para melhorar a entidade que vinculam o próprio modelo estavam florescendo.

O estilo em negrito indica sua pontuação SOTA de um conjunto de dados específico.

| Modelos de linha de base | Ano | Conjunto de dados | código | Correr? | Endereço do código |

|---|---|---|---|---|---|

| Entidade vinculando por meio de codificação conjunta de tipos, descrições e contexto | EMNLP2017 | Conll-yago (82,9, ACC), ACE2004, ACE2005, Wiki ( 89,0 , F1) | Tensorflow | Somente o modelo de trem é carregado | aqui |

| ┗ (muito semelhante ao acima) Supervisão multilíngue conjunta para a entidade transversal da entidade | EMNLP2018 | TH-TEST, MCN-TEST, TAC2015 | Pytorch | Verificando | aqui |

| Entidade coletiva neural Linking (NCEL) | CL2018 | Conll-yago, ACE2004, Aquaint, TAC2010 ( 91.0 , MIC-P), WW | Pytorch | Erro | aqui |

| Melhorando a entidade vinculando modelando as relações latentes entre menções | ACL2018 | Conll-yago ( 93,07 , mic-acc), Aquaint, ACE2004, CWeb, Wiki (84,05, F1) | Pytorch | Avaliação realizada | aqui |

| Elden | NAACL2018 | CONLL-PPD (93,0, P-MIC), TAC2010 (89,6, MIC-P) | Lua, Torch (Lua) | Erro | aqui |

| Entidade conjunta profunda Desambiguação com atenção neural local | EMNLP2017 | Conll-yago (92.22, mic-acc), CWeb, WW, ACE2004, Aquaint, MSNBC | Lua, Torch (Lua) | Trem Running (2019/01/15) | aqui |

| Perdas hierárquicas e novos recursos para digitar e vincular entidades de graniz fino | ACL2018 | Medimentos, typeNet | Pytorch | Erro | aqui |

| Aprendizagem conjunta da incorporação de palavras e entidades para a entidade nomeada Desambiguação (Yamada, Shindo) | CONLL2016 | Conll-yago (91,5, mic-acc), conll-ppd (93,1, p-mic), tac2010 (85,5, mic-acc) | pytorch/tensorflow (original), | verificando | Base original |

| Aprendizagem distribuída Representações de textos e entidades da Base de Conhecimento (Yamada, Shindo) | ACL2017 | CONLL-PPD ( 94,7 , P-MIC), TAC2010 (87,7, Mic-ACC) | Pytorch/Keras (original) | verificando | Tocha, tocha, original |

NOTA: Os principais conjuntos de dados para benchmarking Esta tarefa estão listados no repositório Blink.

Conjunto de dados mewsli-9

Biomédico

Medimentos ([Mohan e Li, Akbc '19])

As medições foram criadas como um conjunto de dados de referência para o reconhecimento de entidade nomeado e a entidade vinculando o domínio biomédico.

Como contém muitos conceitos que são amplos demais para serem de uso prático, o ST21PV foi construído filtrando esses conceitos amplos a partir de medições.

BC5CDR ([Li et al., '15']))

O BC5CDR é um conjunto de dados criado para a tarefa de reconhecimento biocratorial de mencionação química e de doenças.

Compreende 1.500 artigos, contendo 15.935 menções químicas e 12.852 da doença.

A base de conhecimento de referência é a malha e quase todas as menções têm uma entidade de ouro na base de conhecimento de referência.

Wikimed e PubMedds ([Shikhar et al., '20])

O Wikimed inclui mais de 650.000 menções normalizadas para conceitos no UMLS. (Citado)

Além disso, eles criaram corpus anotado PubMedds com mais de 5 milhões de menções normalizadas. Observe que esse conjunto de dados foi criado por supervisão distante, o que leva a causar algumas anotações barulhentas.

Zero-shot

DataSets da Wikia ([Logeswaran et al., '19])

A partir de hiperlinks da Wikia e seus temas relacionados, eles criaram o conjunto de dados para avaliar a generalização do domínio da tarefa de vinculação de entidades.

Eles criaram 16 conjuntos de dados do mundo , que foram divididos em 8/4/4 para trem / dev / teste e completamente independentes um para o outro.

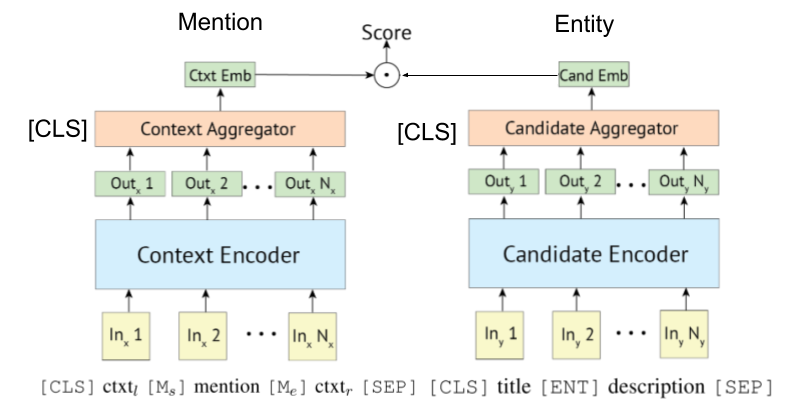

Como [Gillick et al., Conll'19] propuseram primeiro os sistemas de recuperação do codificador bi- (ou, duplo) para vinculação de entidades, alguns trabalhos também aproveitam Bert para eles. A idéia original para o sistema de recuperação baseada em biencoder também é proposta por [Gillick et al., '18]

O codificador de poli-poli também pode ser aplicado à ligação da entidade, como mostrou Wu et al., 2020.

O codificador baseado em transformador é frequentemente adotado para codificação de menção e entidade.

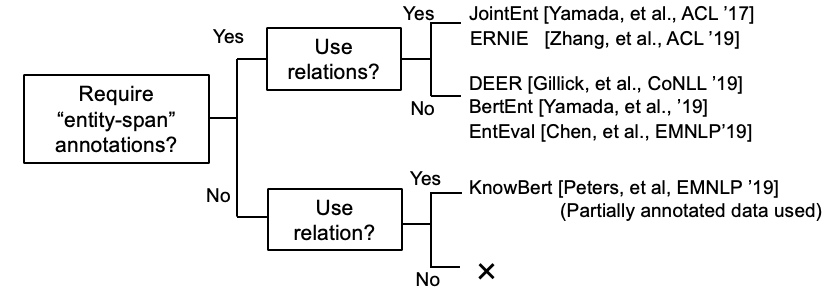

Algumas pesquisas agora estão tentando incorporar informações de KB com Bert.

Kepler: Um modelo unificado para incorporação de conhecimento e representação de idiomas pré-treinada (trabalho em andamento @ novembro, 19)

Integração do gráfico Contexto contextualizado em modelos de idiomas pré-treinados (trabalho em andamento @ DEC, 19)

K-Bert: Habilitando a representação de linguagem com o Gráfico de Conhecimento

[Petroni, et al., 1919] verificou se Bert tem conhecimento factual.

Tutorial de vinculação de entidades baseadas em bi-codificador e sua implementação. [link]

Apareceu o documento de pesquisa abrangente da entidade.

(Comentado @ março de 2020) Atualmente, este repositório inclui trabalhos para vincular entidade e entidade LM. O primeiro requer a representação da entidade codificadora para desambiguação, enquanto o último significa injetar conhecimento da entidade no LM durante o treinamento. Portanto, eles são completamente diferentes, embora algum trabalho de entidade LM tenha avaliado seu modelo com a desambiguação da entidade. Vamos separá -los neste repositório, em um futuro próximo.

Documentos de El Lingual.

Citado de Gupta et al. (EMNLP '18)

A entidade transversal da entidade (XEL) pretende mencionar a entidade fundamentada escrita em qualquer idioma a uma base de conhecimento em inglês (KB), como a Wikipedia.

Supervisão multilíngue conjunta para a entidade transversal Linking (EMNLP '18)

Em direção à entidade transversal com resistência zero (Shuyan et al., Workshop EMNLP '19)

Entidade ligando para textos barulhentos/curtos

Combinação semântica agregada para a entidade de texto curto Linking (ACL'18) [Paper]

Uso eficaz do contexto na entidade barulhenta Linking (EMNLP'18) [Paper]

Entidade multimodal ligando

Alguns outros papéis

Entidade somente de lista de listagem

Aprendizagem conjunta do reconhecimento de entidade nomeado e do papel de vinculação de entidades