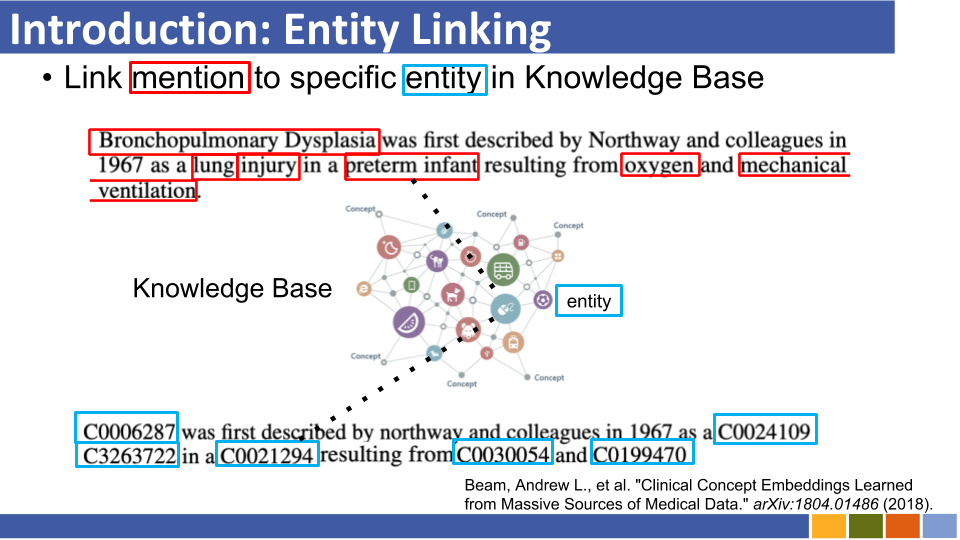

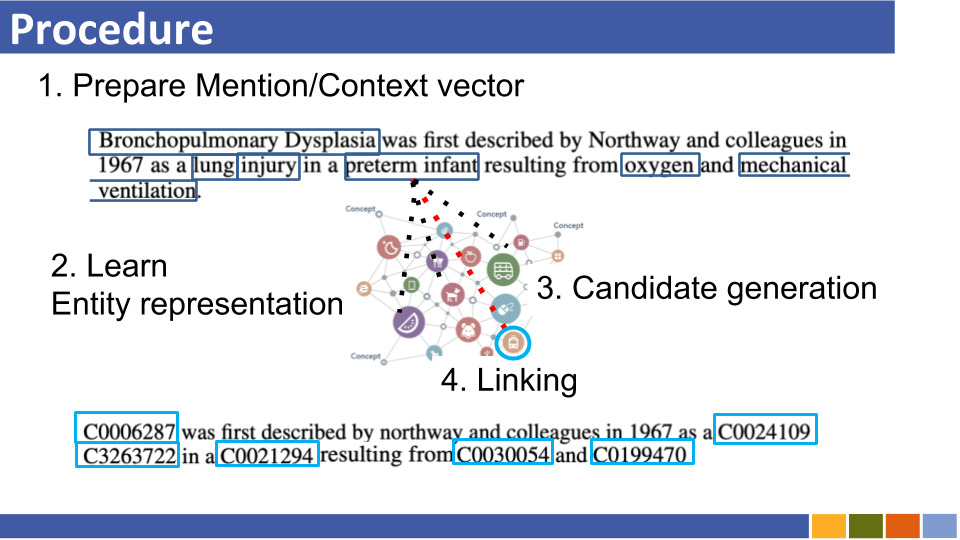

Este repositorio tiene como objetivo rastrear el progreso en la vinculación de la entidad. También se enumeran los estudios sobre cómo preparar representaciones de entidades, ya que las representaciones de la entidad son obligatorias con la vinculación de la entidad.

Recuperación de entidad autorregresiva

Los sistemas de vinculación de entidades tradicionales sufren consumo de memoria debido a la codificación previa de entidades en la base de conocimiento, el costo de los recursos computacionales debido a la comparación de todas las entidades en la base de conocimiento y problemas de inicio en frío.

En lugar de una arquitectura anterior, explota una secuencia a la secuencia para generar nombres de entidades de manera autorregresiva condicionada en el contexto. Utilizaron una búsqueda de haz restringida, obligando solo a decodificar el identificador de entidad válido.

Vinculación de entidades con bases de conocimiento invisibles con esquemas arbitrarios

Los sistemas de vinculación de la entidad tradicional suponen que se conoce el esquema de la base de conocimiento que une las entidades predichas. Propusieron un nuevo método para convertir el esquema de entidades desconocidas a Bert incrustando utilizando atributos y tokens auxiliares.

Al mismo tiempo, también propusieron un método de capacitación para lidiar con atributos desconocidos.

En Media Res: un corpus para evaluar la entidad nombrada vinculación con trabajos creativos [papel] [códigos]

Lucas: representaciones de entidad contextualizadas profundas con la autoatención consciente de la entidad [enlace] [Códigos]

Propusieron una nueva tarea previa a la altura basada en Bert, en la que se predicen palabras y entidades enmascaradas al azar en el corpus anotado por la entidad de Wikipedia.

También en la tarea previa a la altura, propusieron una versión extendida del transformador, que considera una autoatación consciente de la entidad y los tipos de tokens (palabras o entidades) al calcular los puntajes de atención.

Entidad escalable de disparo cero vinculado con una densa recuperación de entidad

Entidad que vincula en 100 idiomas [papel]

Cometa: un corpus para entidad médica que se vincula en las redes sociales [documento]

Entidad de disparo cero vinculado con modelado de secuencia de largo rango eficiente [papel]

De cero a héroe: entidad humana en el bucle vinculada en dominios de bajos recursos [enlace]

Mejorar la vinculación de la entidad a través de integridades de entidades reforzadas semánticas

Enciclopedia previa a la aparición: modelo de lenguaje de pretrada de conocimiento débilmente supervisado (ICLR'20) [documento]

K-Adapter: Infundir el conocimiento en modelos previamente capacitados con adaptadores [papel]

Mejora de la vinculación de la entidad mediante el modelado de la información del tipo de entidad latente (AAAI'20) Documento

Entidad de disparo cero vinculado con un documento de recuperación de entidad densa (10, noviembre)

Similar a [Logeswaran, et al., ACL'19] y [Gillick, et al., Conll'19]

Diapositivas (no oficial)

Entidad que vincula a través de codificadores duales y de atención cruzada [ARXIV]

Evaluación de grano fino para la vinculación de la entidad (EMNLP'19)

Aprender el aumento de contexto dinámico para la vinculación de la entidad global (EMNLP'19)

Entidad de grano fino para la vinculación de entidad independiente del dominio

Investigando el conocimiento de la entidad en Bert con una simple entidad neural de extremo a extremo (Conll '19) [documento]

Aprender representaciones densas para la recuperación de entidades (Conll '19)

papel, repo

No propusieron ningún uso de la tabla de alias (que se basó en estadísticas de Wikipedia o preparó una) y buscar en todas las entidades mediante la fuerza bruta/búsqueda aproximada de la entidad de vinculación por mención.

Enteval: un punto de referencia de evaluación holística para representaciones de entidades (EMNLP '19)

Representaciones de entidades de aprendizaje para la reconstrucción de pocos disparos de las categorías de Wikipedia (ICLR '19)

Representaciones de palabras contextuales mejoradas del conocimiento (EMNLP '19) [Documento]

Las tendencias de aprovechar toda la información (por ejemplo, el tipo y la definición y los documentos de mención de mención en los que existe, etc.) parece ser el desaparecido.

Aunque el dominio de Wikipedia puede usar su hipervínculo (= pares de mención-entidad, aproximadamente 7,500,000) para el modelo de enlace de entrenamiento, bajo algunas situaciones específicas de dominio, no hay tantas pares de mención-entidad de mención.

Por lo tanto, algunos documentos ahora desafían el aprendizaje distante y el aprendizaje de cero disparos de la vinculación de la entidad.

Aprendizaje distante

Aprendizaje distante para la vinculación de la entidad con detección automática de ruido

Diapositivas (no oficial)

Propusieron enmarcar EL como un problema de aprendizaje distante, en el que no hay datos de capacitación etiquetados disponibles, y el modelo de desactivación para esta tarea.

Aumento de la entidad que vincula el rendimiento aprovechando documentos no etiquetados

Enlace de disparo cero

Entidad de disparo cero por descripciones de entidad de lectura

Diapositivas (no oficial)

Propusieron cero disparo El, bajo el cual no se pueden ver menciones de prueba durante el entrenamiento. Para abordar el EL de disparo cero, propusieron una estrategia adaptativa de dominio para el modelo de lenguaje previo a la capacitación. Además, mostraron que la descripción de la entidad de mención es crucial para El.

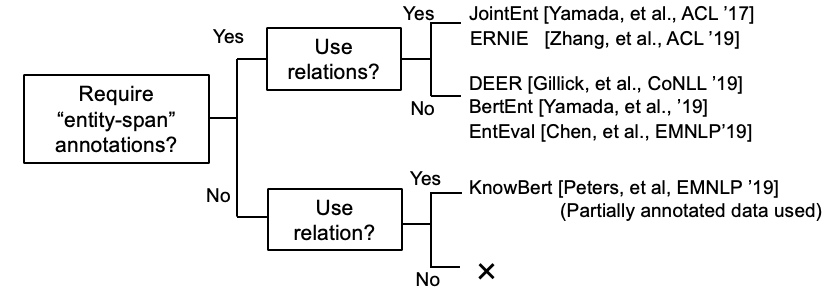

El aprendizaje de representación de entidades con sede en Bert también surgió.

(Comentado @ noviembre, 19 ') En aquellos días, las investigaciones para mejorar el modelo de vinculación de entidad en sí mismo florecían.

Bold Style indica su puntaje SOTA de un conjunto de datos específico.

| Modelos de referencia | Año | Conjunto de datos | código | ¿Correr? | Dirección de código |

|---|---|---|---|---|---|

| Entidad vinculando a través de la codificación conjunta de tipos, descripciones y contexto | EMNLP2017 | Conll-Yago (82.9, ACC), ACE2004, ACE2005, Wiki ( 89.0 , F1) | Flujo tensor | Solo se carga el modelo Traind | aquí |

| ┗ (muy similar a lo anterior) Supervisión multilingüe de la unión multilingüe para la vinculación de entidad interlingüística | EMNLP2018 | TH-Test, MCN-Test, TAC2015 | Pytorch | De cheques | aquí |

| Enlace de entidad colectiva neural (NCEL) | CL2018 | Conll-Yago, ACE2004, Aquaint, TAC2010 ( 91.0 , MIC-P), WW | pytorch | Bicho | aquí |

| Mejora de la vinculación de la entidad modelando relaciones latentes entre menciones | ACL2018 | Conll-Yago ( 93.07 , MIC-ACC), Aquaint, ACE2004, CWEB, Wiki (84.05, F1) | pytorch | Evaluación realizada | aquí |

| Elden | NAACL2018 | Conll-PPD (93.0, P-Mic), TAC2010 (89.6, MIC-P) | lua, antorcha (lua) | Bicho | aquí |

| Desambiguación de entidad conjunta profunda con atención neuronal local | EMNLP2017 | Conll-Yago (92.22, Mic-ACC), CWEB, WW, ACE2004, Aquaint, MSNBC | lua, antorcha (lua) | Train Running (2019/01/15) | aquí |

| Pérdidas jerárquicas y nuevos recursos para la escritura y vinculación de la entidad de grano fino | ACL2018 | Medmentions, typenet | pytorch | Bicho | aquí |

| Aprendizaje conjunto de la incrustación de palabras y entidades para la desambiguación de entidad nombrada (Yamada, Shindo) | Conll2016 | Conll-Yago (91.5, MIC-ACC), Conll-PPD (93.1, P-Mic), TAC2010 (85.5, MIC-ACC) | pytorch/tensorflow (original), | de cheques | Original de línea de base |

| Aprender representaciones distribuidas de textos y entidades de la base de conocimiento (Yamada, Shindo) | ACL2017 | Conll-PPD ( 94.7 , P-Mic), TAC2010 (87.7, MIC-ACC) | Pytorch/keras (original) | de cheques | Antorcha, antorcha, original |

Nota: Los conjuntos de datos principales para la evaluación comparativa de esta tarea se enumeran en el repositorio de Blink.

Conjunto de datos MEWSLI-9

Biomédico

Medmentos ([Mohan y Li, AKBC '19])

Medmentions fue creado como un conjunto de datos de referencia para el reconocimiento de entidades nombrado y la vinculación de la entidad en el dominio biomédico.

Como contiene muchos conceptos que son demasiado amplios para ser de uso práctico, el ST21PV se construyó filtrando esos conceptos amplios de medentes.

BC5CDR ([Li et al., '15'])

BC5CDR es un conjunto de datos creado para la tarea de reconocimiento de mención química y de enfermedad de BioCreative V.

Comprende 1,500 artículos, que contienen 15,935 químicos y 12,852 menciones de enfermedad.

La base de conocimiento de referencia es la malla, y casi todas las menciones tienen una entidad de oro en la base de conocimiento de referencia.

Wikimed y PubMedds ([Shikhar et al., '20])

Wikimed incluye más de 650,000 menciones normalizadas a conceptos en UMLS. (Citado)

Además, crearon el cuerpo anotado PubMedds con más de 5 millones de menciones normalizadas. Tenga en cuenta que este conjunto de datos fue creado por supervisión distante, lo que lleva a causar algunas anotaciones ruidosas.

Cero

Conjuntos de datos de Wikia ([Logeswaran et al., '19])

Desde los hipervínculos de Wikia y sus temas relacionados, crearon un conjunto de datos para evaluar la generalización del dominio de la tarea de enlace de entidad.

Crearon 16 conjuntos de datos Worlds , que se dividieron a 8/4/4 para trenes / dev / test y completamente independientes para el otro.

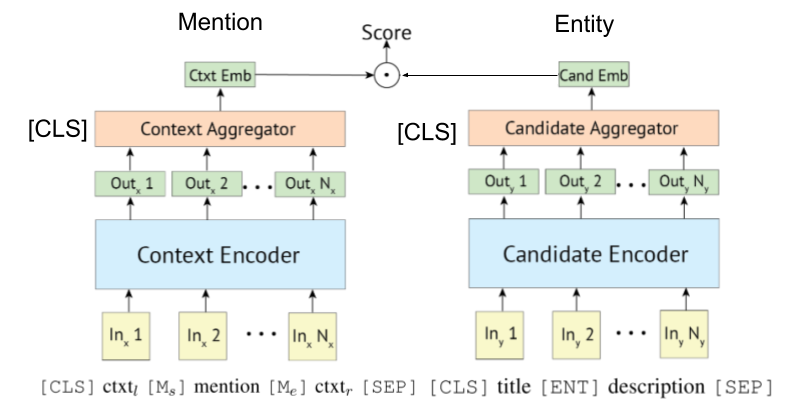

Dado que [Gillick et al., Conll'19] Primero propuso los sistemas de recuperación de codificadores de bi- (o dual) para la vinculación de la entidad, algunos documentos también aprovechan Bert para ellos. La idea original para el sistema de recuperación basado en biencoder también es propuesta por [Gillick et al., '18]

Poly-Engoder también se puede aplicar a la vinculación de la entidad, como lo mostraron Wu et al., 2020.

El codificador basado en transformadores a menudo se adopta para la mención y la codificación de entidades.

Algunas investigaciones ahora están tratando de incorporar información de KB con Bert.

Kepler: Un modelo unificado para la incrustación del conocimiento y la representación del lenguaje previamente capacitado (trabajo en progreso @ nov, '19)

Integrando el conocimiento contextualizado gráfico en modelos de lenguaje previamente capacitados (trabajo en progreso @ DEC, '19)

K-Bert: habilitando la representación del lenguaje con el gráfico de conocimiento

[Petroni, et al., '19] verificó si Bert tiene conocimiento objetivo.

Entidad basada en bi-codificador que vincula el tutorial y su implementación. [enlace]

Ha aparecido un documento de encuesta integral de la vinculación de la entidad.

(Comentó @ marzo de 2020) Actualmente, este repositorio incluye documentos para la vinculación de entidad y la entidad LM. El primero requiere codificar la representación de la entidad para la desambiguación, mientras que el segundo significa inyectar el conocimiento de la entidad en LM durante la capacitación. Por lo tanto, son completamente diferentes, aunque algún trabajo de entidad LM evaluó su modelo con la desambiguación de la entidad. Los separaremos en este repositorio, en el futuro cercano.

Documentos de El Crosslingeal.

Citado de Gupta et al. (EMNLP '18)

La vinculación de la entidad interlingual (XEL) tiene como objetivo mencionar las menciones de entidad escritas en cualquier idioma a una base de conocimiento en inglés (KB), como Wikipedia.

Supervisión multilingüe conjunta para enlaces de entidad interlingüe (EMNLP '18)

Hacia la vinculación de entidad interlingual de recursos cero (Shuyan et al., Taller EMNLP '19)

Entrada de entidad para textos ruidosos/cortos

Matriovación semántica agregada para una entidad de texto corto (ACL'18) [Papel]

Uso efectivo del contexto en la vinculación de la entidad ruidosa (EMNLP'18) [Documento]

Enlace de entidad multimodal

Algunos otros documentos

Entidad de solo lista de enlaces

Aprendizaje conjunto del reconocimiento de entidad nombrado y el papel de enlace de entidad