大規模言語モデル (LLM) の評価は、自然言語処理の分野において常に重要な課題でした。従来の手動評価方法は時間と労力がかかり、LLM の急速な発展に対応できません。この目的を達成するために、Salesforce AI 研究チームは、より高速で効率的な自動評価ソリューションを提供するように設計された、異なるサイズの 3 つの LLM で構成される評価ファミリーである SFR-Judge を開発しました。 Downcodes のエディターは、SFR-Judge の革新性と、それが LLM 評価の問題をどのように解決するかを深く理解することができます。

自然言語処理の分野では、大規模言語モデル (LLM) が急速に開発され、多くの分野で大きな進歩を遂げています。ただし、モデルが複雑になるにつれて、その出力を正確に評価することが重要になります。従来、人間による評価に依存してきましたが、このアプローチは時間がかかり、モデル開発の急速なペースに合わせて拡張することが困難です。

この状況を変えるために、Salesforce AI 研究チームは、3 つの大きな言語モデルで構成される評価ファミリーである SFR-Judge を立ち上げました。これらのモデルにはそれぞれ 80 億、120 億、700 億のパラメーターがあり、Meta Llama3 と Mistral NeMO に基づいて構築されています。 SFR-Judge は、ペアごとの比較、単一スコアリング、バイナリ分類評価などのさまざまな評価タスクを実行でき、研究チームが新しいモデルのパフォーマンスを迅速かつ効率的に評価できるように設計されています。

従来の LLM 評価モデルには、位置バイアスや長さバイアスなど、判断に影響を与えるバイアスの問題が存在することがよくあります。これらの問題を克服するために、SFR-Judge は Direct Preference Optimization (DPO) トレーニング手法を採用しています。これにより、モデルが肯定的な例と否定的な例から学習できるようになり、評価タスクを理解する能力が向上し、バイアスが軽減され、一貫性が確保されます。判断の。

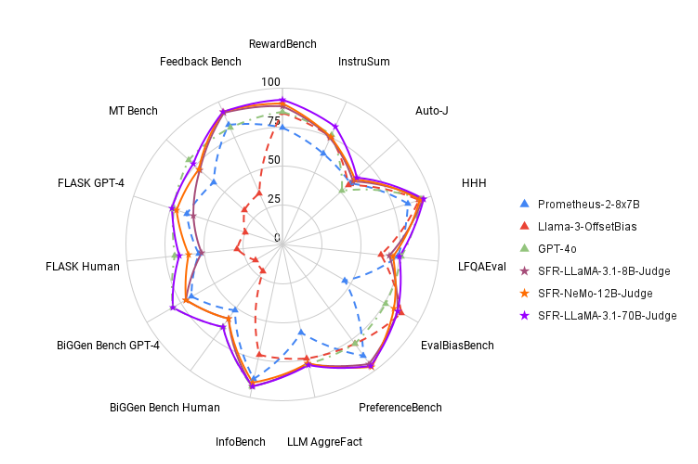

テストでは、SFR-Judge は 13 のベンチマークで良好なパフォーマンスを示し、一部のプライベート モデルを含む多くの既存の評価モデルを上回りました。特に RewardBench ランキングでは、SFR-Judge の精度が 92.7% に達し、生成評価モデルが 90% の閾値を超えたのはこれが初めてであり、評価モデルにおける優れたパフォーマンスを示しています。

SFR-Judge のトレーニング方法は 3 つの異なるデータ形式をカバーします。 1 つ目は「思考連鎖批判」で、モデルが評価反応の構造化された分析を生成するのに役立ちます。 2つ目は、評価プロセスを簡素化し、回答が基準を満たしているかどうかを直接フィードバックする「標準評価」です。最後に、「応答導出」は、モデルが高品質な応答の特徴を理解し、判断能力を強化するのに役立ちます。これら 3 つのデータ形式を組み合わせることで、SFR-Judge の評価機能が大幅に向上します。

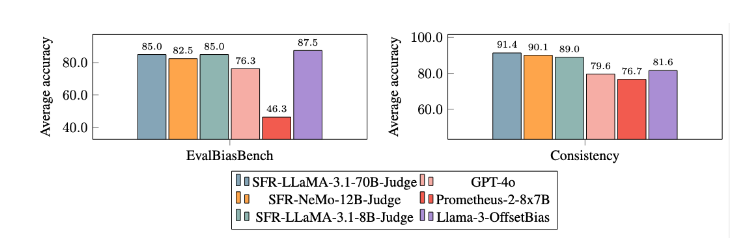

広範な実験の結果、SFR-Judge モデルはバイアスの低減において他のモデルよりも大幅に優れたパフォーマンスを示しました。 EvalBiasBench ベンチマークでは、高度なペアごとの順序の一貫性が実証されました。これは、応答順序が変化してもモデルの判断が安定していることを示しています。これにより、SFR-Judge は信頼性の高い自動評価ソリューションとなり、手動アノテーションへの依存を減らし、モデル評価のためのよりスケーラブルなオプションを提供します。

論文の入り口: https://arxiv.org/abs/2409.14664

ハイライト:

? 高精度: SFR-Judge は 13 のベンチマーク テストで 10 の最高の結果を達成し、特に RewardBench では 92.7% という高い精度を達成しました。

バイアスの軽減: このモデルは、特に長さと位置のバイアスに関して、他の評価モデルよりも低いバイアスを示しています。

多機能アプリケーション: SFR-Judge は、一対の比較、単一スコアリング、および 2 カテゴリーの評価をサポートしており、さまざまな評価シナリオに適応できます。

SFR-Judge の登場は、大規模な言語モデルの評価に新たな希望をもたらします。その高精度、低バイアス、多用途性により、SFR-Judge は強力な自動評価ツールとなります。この研究は、LLM 分野の発展に重要な技術的サポートを提供するとともに、将来的には LLM 評価がより効率的で信頼性の高いものになることを示しています。 Downcodes の編集者は、将来的に同様のイノベーションがさらに増えることを楽しみにしています。