Count Sketch Optimizers

1.0.0

カウントスケッチを介してグラデーションオプティマイザーを圧縮します

ライアン・スプリングによるICML 2019ペーパー、アナスタシオス・キリリディス、ヴィジャイ・モハン、アンシュマリ・シュリヴァスタバ

NVIDIA V100 DGX-1サーバーでのアクティベーションチェックポイントと混合精密トレーニング(FP16)でトレーニング

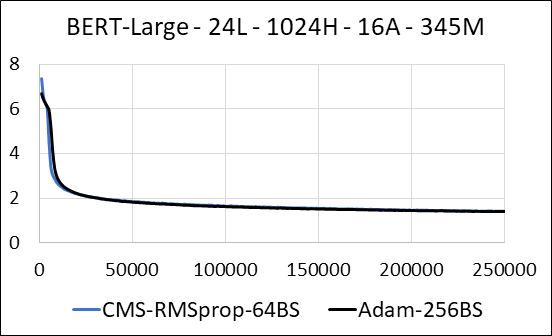

| バート・ラージ | アダム | カウントマンスケッチ(CMS)-RMSPROP |

|---|---|---|

| 時間(日) | 5.32 | 5.52 |

| サイズ(MB) | 7,097 | 5,133 |

| 困惑をテストします | 4.04 | 4.18 |

私たちは、最新のスパースなしにニューラルネットワークの密な層を圧縮することをサポートします。トレーニング中に、補助変数を更新し、単一の融合Cudaカーネルの各パラメーターの勾配更新を実行します。濃いカーネルは、スパースカーネルと同等です。主な違いは、グローバルメモリ内の密な層の補助変数の生成を明示的に避けることです。代わりに、GPUストリーミングマルチプロセッサの共有メモリ内にアクセスします。この重要な機能がなければ、私たちのアプローチは密な層のGPUメモリを保存しません。スパースの場合、ゼロ以外の勾配の更新は補助変数よりも大幅に小さいと想定しています。 (詳細については、dense_exp_cms.pyを参照してください)