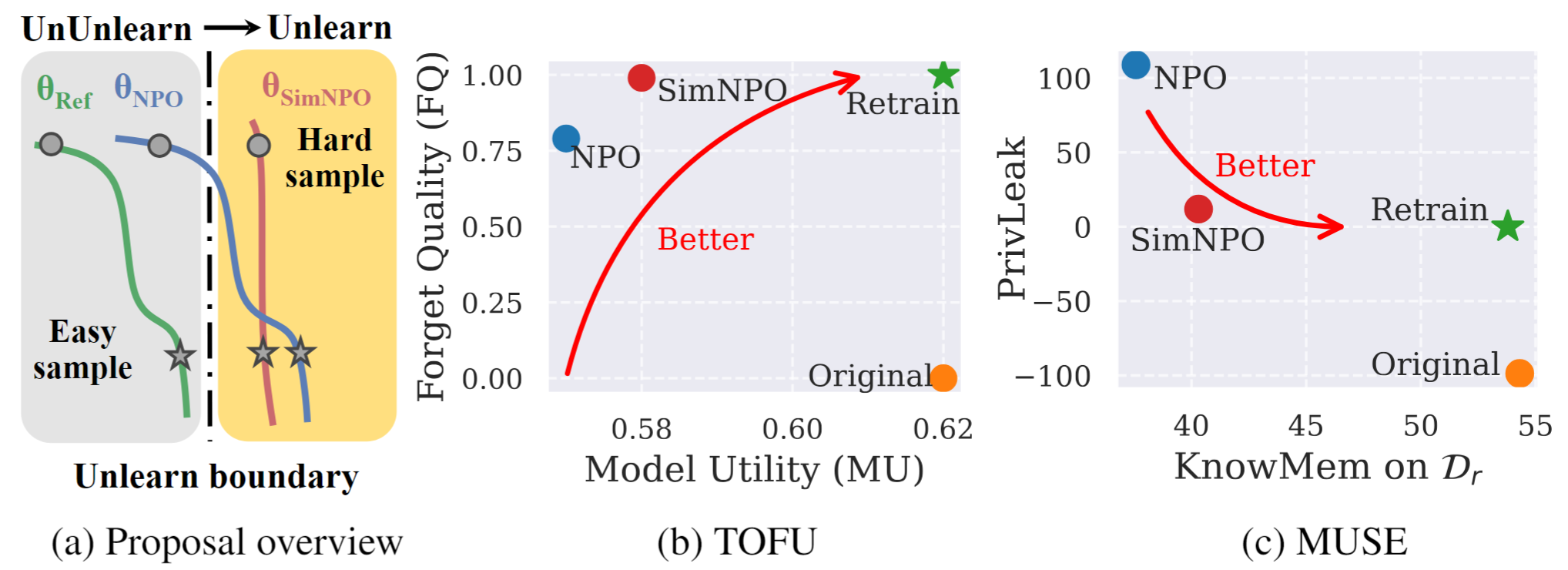

Figure 1: Présentation systématique et saillants de l'expérience de SIMNPO. |

Il s'agit du référentiel de code officiel pour la simplicité du papier prévaut: repenser l'optimisation des préférences négatives pour le désapprentissage de LLM.

Dans ce travail, nous abordons le problème du modèle de grande langue (LLM), visant à supprimer les influences de données indésirables et les capacités du modèle associées ( par exemple , les données protégées par le droit d'auteur ou la génération de contenu nocive) tout en préservant les utilitaires de modèle essentiel, sans avoir besoin de recycler à partir de zéro. Malgré le besoin croissant de llm désapprentissage, un cadre d'optimisation de principe reste défectueux. À cette fin, nous revisitons l'approche de pointe, l'optimisation des préférences négatives (NPO), et identifions la question du biais du modèle de référence, ce qui pourrait saper l'efficacité de NPO, en particulier lors de l'absence de données d'oublier les données de difficulté variable. Étant donné que nous proposons un cadre d'optimisation simple mais efficace, appelé SIMNPO , montrant que la «simplicité» en supprimant la dépendance à un modèle de référence (à travers l'objectif de l'optimisation des préférences simples) avantage désapprentissage. Nous fournissons également des informations plus approfondies sur les avantages de Simnpo, soutenues par l'analyse à l'aide de mélanges de chaînes de Markov. En outre, nous présentons des expériences approfondies validant la supériorité de Simnpo sur les lignes de base non apprises existantes dans des références comme le tofu et la muse, et la robustesse contre le réapparition des attaques.

Pour utiliser directement notre modèle non apprise, veuillez vous référer à notre collection HuggingFace:

@article{fan2024simplicity,

title={Simplicity Prevails: Rethinking Negative Preference Optimization for LLM Unlearning},

author={Fan, Chongyu and Liu, Jiancheng and Lin, Licong and Jia, Jinghan and Zhang, Ruiqi and Mei, Song and Liu, Sijia},

journal={arXiv preprint arXiv:2410.07163},

year={2024}

}