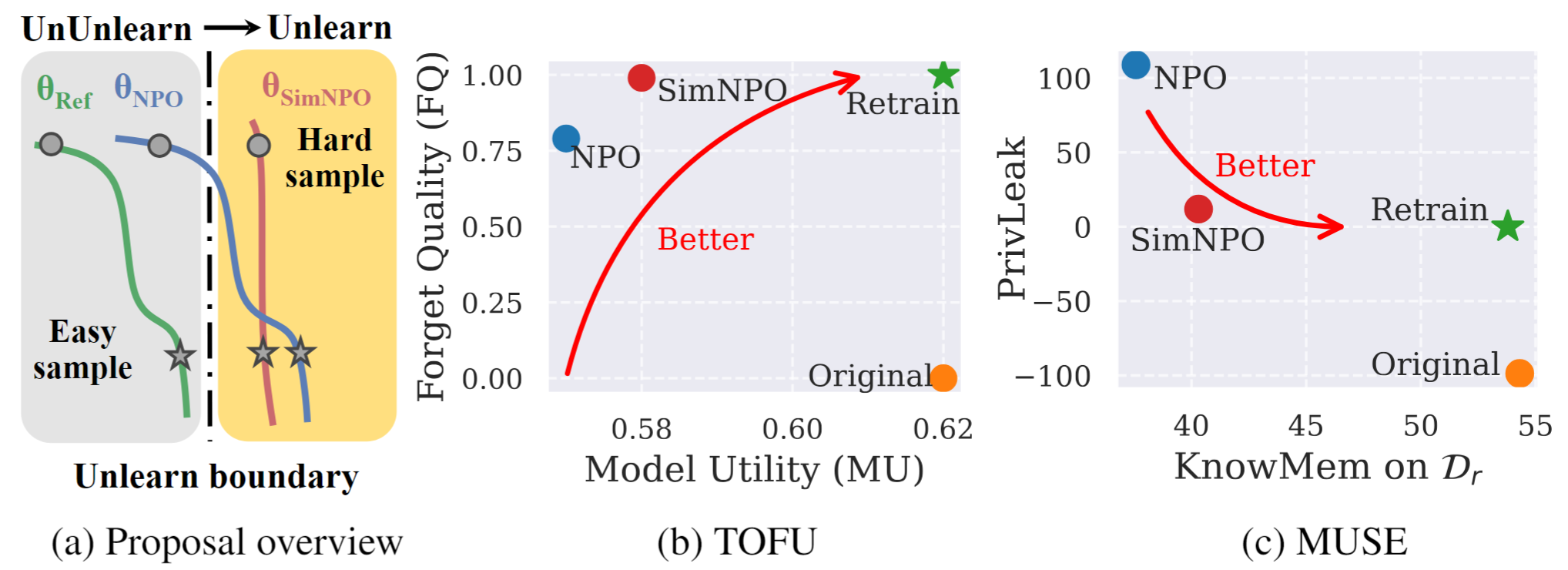

Abbildung 1: Systematische Übersicht und Experiment -Highlights von Simnpo. |

Dies ist das offizielle Code -Repository für die Einfachheit der Papier, die die negative Präferenzoptimierung für LLM -Ablarning überdenken.

In dieser Arbeit befassen wir uns mit dem Problem des LLM (LLM -Modells des Großsprachenmodells) und dem Ziel, unerwünschte Dateneinflüsse und zugehörige Modellfunktionen ( z . B. urheberrechtlich geschützte Daten oder schädliche Inhaltsgenerierung) zu entfernen und gleichzeitig die Dienstprogramme für wesentliche Modells zu erhalten, ohne dass die Rücknahme von Grund auf neu zurückgezogen werden muss. Trotz des wachsenden Bedarfs an LLM -Verurnungen fehlt ein prinzipielles Optimierungsrahmen. Zu diesem Zweck überprüfen wir den hochmodernen Ansatz, die negative Präferenzoptimierung (NPO) und identifizieren das Problem der Referenzmodellverzerrung, die die Wirksamkeit des NPO untergraben könnte, insbesondere wenn sie das Verlernen von Daten unterschiedlicher Schwierigkeiten vergessen. Angesichts der Tatsache schlagen wir ein einfaches und dennoch effektives, unzulässiges Optimierungsrahmen vor, das als SIMNPO bezeichnet wird und zeigt, dass „Einfachheit“ bei der Beseitigung der Abhängigkeit von einem Referenzmodell (durch die Linse der einfachen Präferenzoptimierung) die Verlorung von Vorteil ist. Wir bieten auch tiefere Einblicke in die Vorteile von SIMNPO, die durch Analyse unter Verwendung von Gemischungen von Markov -Ketten unterstützt werden. Darüber hinaus präsentieren wir umfangreiche Experimente, die die Überlegenheit von SIMNPO gegenüber vorhandenen Verunrennungsgrundlagen in Benchmarks wie Tofu und Muse sowie Robustheit gegen Relarting -Angriffe validieren.

Um unser unglaubliches Modell direkt zu verwenden, finden Sie in unserer Kollektion von Huggingface:

@article{fan2024simplicity,

title={Simplicity Prevails: Rethinking Negative Preference Optimization for LLM Unlearning},

author={Fan, Chongyu and Liu, Jiancheng and Lin, Licong and Jia, Jinghan and Zhang, Ruiqi and Mei, Song and Liu, Sijia},

journal={arXiv preprint arXiv:2410.07163},

year={2024}

}