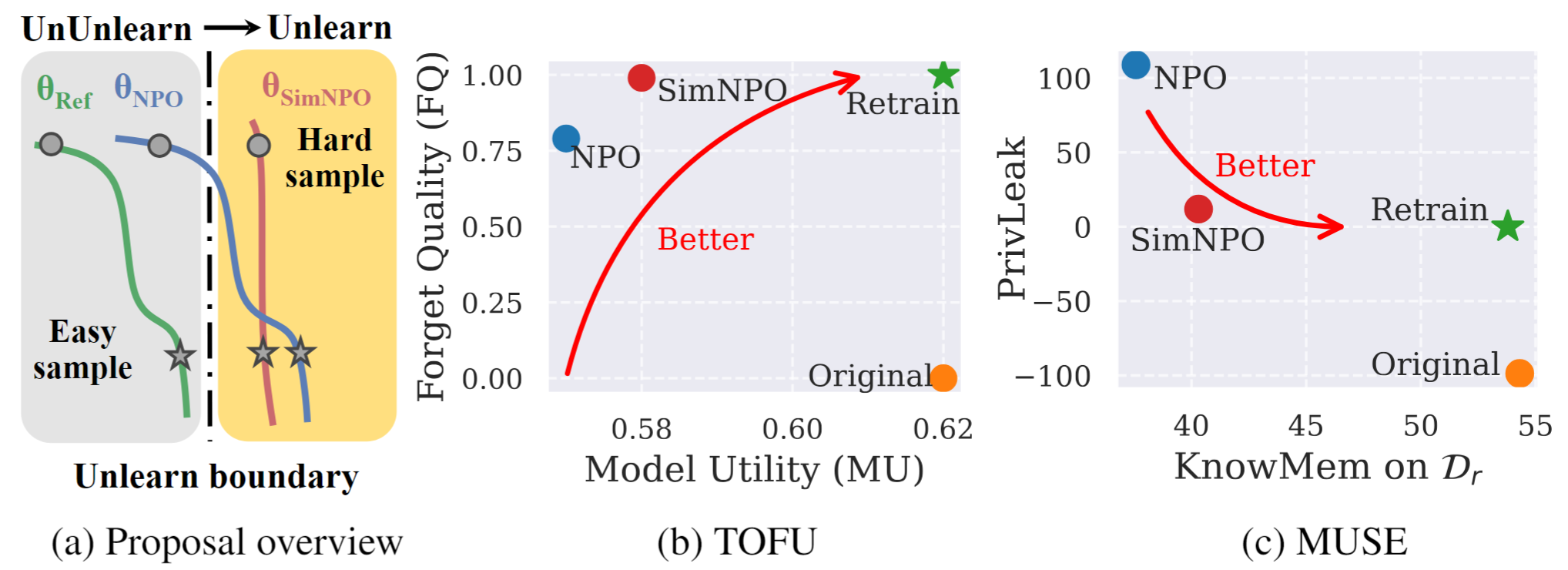

Figura 1: Descripción general sistemática y resaltados de experimentos de SIMNPO. |

Este es el repositorio de código oficial de la simplicidad en el documento: Repensar la optimización de preferencias negativas para el desaprendizaje de LLM.

En este trabajo, abordamos el problema del desaprendizaje del modelo de lenguaje grande (LLM), con el objetivo de eliminar las influencias de los datos no deseados y las capacidades del modelo asociado (p. Ej ., Datos con derechos de autor o generación de contenido dañino) al tiempo que preservan las utilidades del modelo esencial, sin la necesidad de volver a conectarse desde cero. A pesar de la creciente necesidad de desaprender LLM, sigue faltando un marco de optimización de principios. Con este fin, revisamos el enfoque de vanguardia, la optimización de preferencias negativas (NPO) e identificamos el problema del sesgo del modelo de referencia, que podría socavar la efectividad de NPO, particularmente cuando el desaprendedor olvida los datos de diferentes dificultades. Dado que proponemos un marco de optimización de desaprendizaje simple pero efectivo, llamado Simnpo , que muestra que la "simplicidad" en la eliminación de la dependencia de un modelo de referencia (a través de la lente de optimización de preferencia simple) los beneficios de los beneficios de los beneficios. También proporcionamos información más profunda sobre las ventajas de Simnpo, respaldadas por el análisis utilizando mezclas de cadenas de Markov. Además, presentamos experimentos extensos que validan la superioridad de Simnpo sobre las líneas de base del desaprendizaje existentes en puntos de referencia como Tofu y Muse, y robustez contra los ataques de remitimiento.

Para usar directamente nuestro modelo no aprendido, consulte nuestra colección Huggingface:

@article{fan2024simplicity,

title={Simplicity Prevails: Rethinking Negative Preference Optimization for LLM Unlearning},

author={Fan, Chongyu and Liu, Jiancheng and Lin, Licong and Jia, Jinghan and Zhang, Ruiqi and Mei, Song and Liu, Sijia},

journal={arXiv preprint arXiv:2410.07163},

year={2024}

}