Langchains Studiennotizen. verlassen:

openai == 0.27 . 8

langchian == 0.0 . 225Einige Werkzeuge ähnlich wie Langchain:

Hinweis: Aufgrund der Aktualisierung von Langchain oder Langchain-Chatglm können einige Quellcodes und Erklärungen unterschiedlich sein.

Einige Artikel setzen direkt Links und werden aus dem Internet gesammelt.

Derzeit gibt es zwei chinesische Projekte, die auf Langchain basieren:

Wir können viel daraus lernen.

Ein optimiertes EPPT ist für die Ergebnisse von entscheidender Bedeutung.

Yzfly/Langgpt: Langgpt: Ermächtigung aller, ein schneller Experte zu werden! (Github.com): Erstellen strukturierter hochwertiger EPPT

Obwohl Langchain uns einige Bequemlichkeit bietet, gibt es auch einige Probleme:

Das Problem der grundlegenden Technologie großer Modelle kann nicht gelöst werden, hauptsächlich das Problem der Wiederverwendung von ProT : Erstens sind viele Probleme in großen Modellen Defekte der Grundtechnologie großer Modelle und können nicht etwas, das Langchain lösen kann. Das Kernproblem besteht darin, dass die Hauptarbeit der groß angelegten Modellentwicklung die ProPT-Engineering ist. Und das ist sehr wiederverwendbar. Diese Funktionen erfordern jedoch alle eine sehr maßgeschneiderte handgeschriebene ProT . Jeder Schritt in der Kette erfordert handgeschriebene Propt. Die Eingabedaten müssen auf eine sehr spezifische Weise formatiert werden, um eine gute Ausgabe für diese Funktions-/Kettenschritt zu generieren. Die Einrichtung der DAG -Orchestrierung zum Ausführen dieser Ketten macht nur 5% der Arbeiten aus, und 95% der Arbeiten sind nur auf Anpassungen und Datenserialisierungsformaten erforderlich. Diese Dinge sind nicht wiederverwendbar .

Langchains schlechte Abstraktion und versteckter Müll . Darüber hinaus sind viele der eingebauten Requisiten von Langchain schlecht, daher sind sie nicht so gut wie sie selbst zu konstruieren, aber sie verbergen diese Standardrequisiten.

Langchain -Frameworks sind schwer zu debuggen : Obwohl viele Methoden von Langchain Parameter für das Drucken detaillierter Informationen liefern, haben sie tatsächlich nicht viele wertvolle Informationen . Zum Beispiel ist es sehr schwierig, wenn Sie tatsächliche ProPT- oder LLM -Abfragen sehen möchten. Der Grund ist der gleiche wie zuvor. Wenn Sie also Langchain verwenden, um sich schlecht zu entwickeln und den Code zu debuggen, um festzustellen, welche Eingabeaufforderungen Probleme haben, wird dies schwierig sein.

Langchain ermutigt das Tool -Sperren : Langchain ermutigt die Benutzer, auf ihrer Plattform zu entwickeln und zu arbeiten. Wenn Benutzer jedoch einige Workflows durchführen müssen, die in der Langchain -Dokumentation nicht behandelt werden, ist es schwierig, selbst mit einem benutzerdefinierten Proxy zu ändern. Dies bedeutet, dass Benutzer, sobald sie Langchain verwenden, möglicherweise auf bestimmte Tools und Merkmale von Langchain beschränkt sind und nicht einfach auf andere Tools oder Plattformen wechseln können, die möglicherweise besser für ihre Anforderungen geeignet sind.

Der obige Inhalt kommt von:

Manchmal können wir relevante Prozesse für einige einfache Aufgaben selbst implementieren, damit jeder Teil von uns selbst kontrolliert wird und leichter zu ändern ist.

Die Feinabstimmung von LLM unter Verwendung von Domänendaten wird durch die Größe der Rechenressourcen und Modellparameter begrenzt, und das Modell wird gemunkelt. Dies beinhaltet eine Reihe von Themen:

Grundlegende Ideen:

1. Benutzerfrage: Bitte vergleichen Sie die Produkte Estee Laudert Soft Repairing Skin Care Essence und SK-II Hautpflege-Essenz?

2. Routerchain -Problem -Routing, dh wie man die Frage beantworten: (Rufen Sie einmal LLM an)

3. Verwenden Sie den Planer, um Schritt zu generieren: (Rufen Sie einmal LLM auf)

4. Executor Executer führt die oben genannten Schritte aus: (Anrufschritte LLM, n ist der Hyperparameter, der die maximale Anzahl von Aufrufen angibt).

5. Zusammenfassung aller Ergebnisse. (Rufen Sie einmal LLM an)

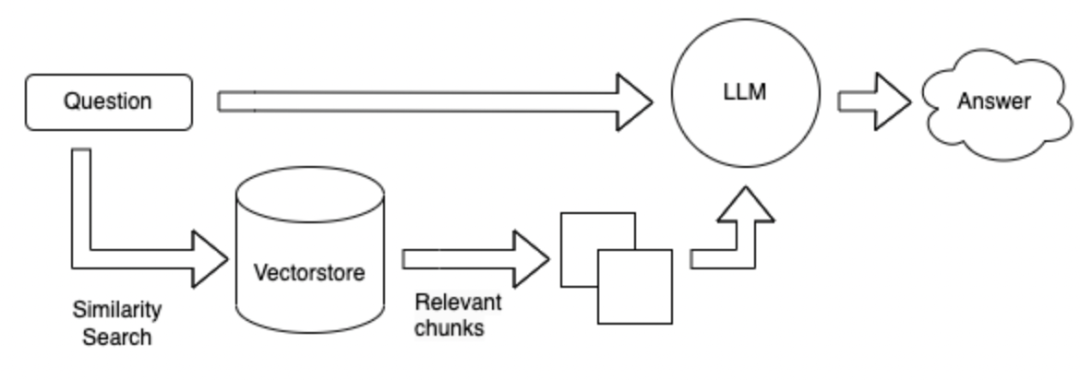

Im Vergleich zu Schema 1 wird die Datenbank ohne Tools basierend auf der Frage direkt durchsucht, und dann werden die abgerufenen Ergebnisse beantwortet.

Die Suchmethode kann auf den Schlüsselwörtern einer bestimmten Frage basieren und verwenden das ES -Tool, um Topk -Absätze mit möglichen Antworten aus einer massiven Datenbank abzurufen. Senden Sie diese Topk -Absätze zusammen mit der Frage an LLM, um sie zu beantworten.

Die Suchmethode wird zuerst in ein Vektorformular geändert.

Vor- und Nachteile der obigen Methode:

Feldfeineinstellungs-LLM : Es erfordert eine Menge Arbeitskräfte, Daten und Fragen und Antworten vor Ort zu sammeln und viel Rechenleistung für die Feinabstimmung zu erfordern.

Langchain + LLM + Tools : Es ist ein Dienst, der LLM als Unterbedienung nimmt. Die LLM -Generation ist unzuverlässig, wenn Sie Tools basierend auf Problemen und Tools aufrufen. Ich kann Werkzeuge nicht gut nutzen. Es ist möglicherweise nicht möglich, entsprechende Tools gemäß den Anweisungen aufzurufen, und der Plan kann schlecht und schwer zu kontrollieren sein. Vorteile sind: verwendet, um komplexe Probleme zu lösen.

Langchain + LLM + -Suche : Der Vorteil ist die Mainstream-Frage-und-Antwort-Struktur im aktuellen Feld, und der Nachteil besteht darin, dass die Suche nach Absätzen, die Antworten enthalten können, bei der Suche nach Antworten basierend auf der Frage ungenau sein können. Nicht geeignet für komplexe Fragen und Antworten

Zusammenfassung: Das größte Problem ist LLM selbst:

LLM ist die Basis des gesamten Systems, und es sind immer noch viele Optionen verfügbar.

Die obige Referenz: https://mp.weixin.qq.com/s/fvrchit0c0xhysco_d-sda

Lassen Sie einige Fragen nachdenken: Es kann mit Langchain oder großen Modellen zusammenhängen

** Wie kann man ein chinesisches Großmodell basieren, das auf Daten in vertikalen Feldern basiert? ** 1 ist es im Handel erhältlich? 2. Laut der Rangliste jeder Bewertung. 3.. Bewerten Sie Ihre eigenen Felddaten. 4. Zeichnen Sie aus vorhandenen vertikalen Feldmodellen wie Finanzmodellen, Rechtsmodellen, medizinischen Modellen usw.

** Eine Antwort auf die Daten besteht aus einer Reihe verbundener Sätze. **Zum Beispiel:

怎么能够解决失眠?

1 、保持良好的心情;

2 、进行适当的训练。

3 、可适当使用药物。1. Versuchen Sie, die Länge des geteilten Textes so einzustellen, dass sie größer sind. 2. Um zu vermeiden, dass die Antwort geteilt wird, können Sie einen bestimmten Text zwischen verschiedenen Absätzen festlegen. 3. Die ersten Top_k -Dokumente können während der Suche zurückgegeben werden. 4. Fusion Mehrere Texte gefunden und fassen Sie sie mit LLM zusammen.

Wie baue ich Einbettung in vertikale Felder?

Wie lagere ich die erhaltene Einbettung?

Wie leitete ich LLM, um besser nachzudenken? Sie können: Kette von Gedanken, selbst fragen, reagieren .

Einführung |

API -Referenz -? Langchain 0.0.229

https://mp.weixin.qq.com/s/fvrchit0c0xhysco_d-sda

https://python.langchain.com.cn/docs/modules/agents/how_to/custom_llm_chat_agent