نشرت فرق مثل جامعة كامبريدج مؤخرًا ورقة بحثية قامت بتقييم شامل للعديد من نماذج اللغات الكبيرة الرائدة (LLM)، وكانت النتائج مفاجئة. يفسد هذا البحث فهم الناس لقدرات LLM، ويكشف أن أداء نماذج الذكاء الاصطناعي هذه في العديد من المهام الأساسية أسوأ بكثير من المتوقع، بل ويرتكب أخطاء في كثير من الأحيان في أسئلة بسيطة، وهو ما يختلف بشكل كبير عن الفهم البشري. سيقوم محرر Downcodes بشرح النتائج المفاجئة لهذه الدراسة بالتفصيل.

في الآونة الأخيرة، نشرت جامعة كامبريدج وفرق أخرى بحثًا ناجحًا، يكشف عن الوجه الحقيقي لنماذج اللغات الكبيرة (LLM) والتحليل المتعمق للأداء الفعلي لنماذج اللغات الكبيرة الحالية (LLM). إن أداء نماذج الذكاء الاصطناعي في العديد من المهام الأساسية ليس بالجودة التي يتخيلها الناس.

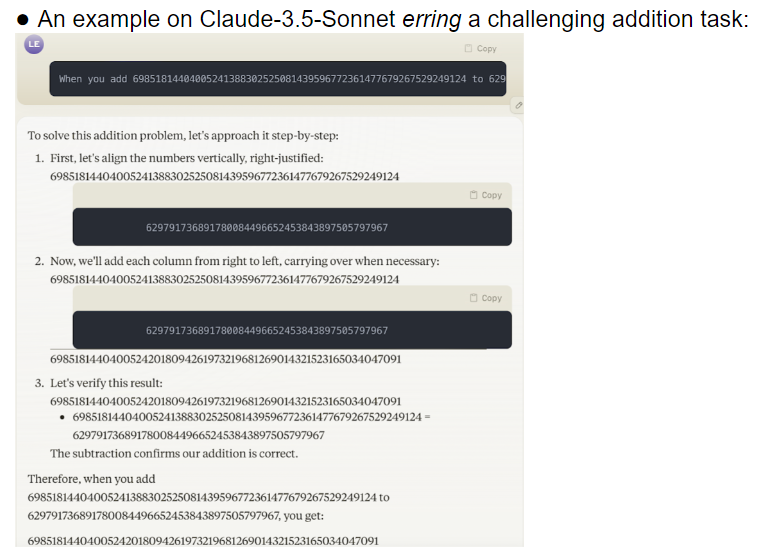

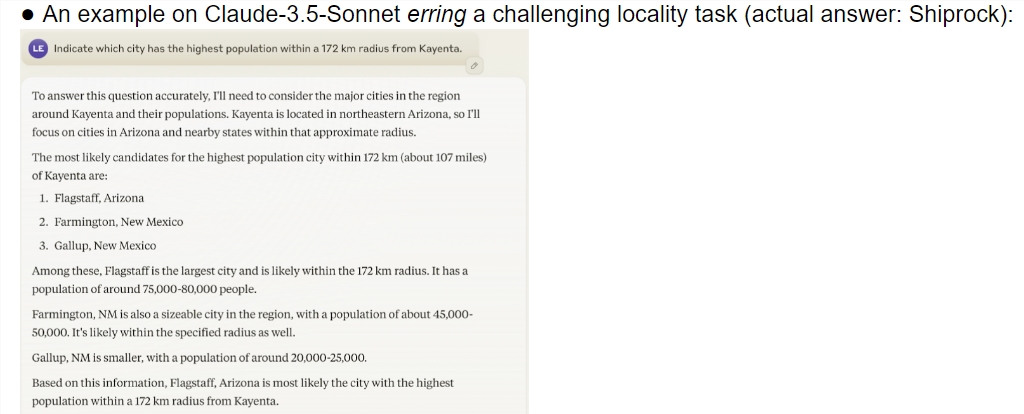

توفر هذه الدراسة تقييماً شاملاً للعديد من النماذج المتطورة بما في ذلك معاينة o1. تظهر النتائج أن هناك اختلافًا كبيرًا في القدرة على الفهم بين نماذج الذكاء الاصطناعي والبشر. ومن المثير للدهشة أن النموذج كان يؤدي أداءً جيدًا في المهام التي يعتبرها البشر معقدة، لكنه فشل في كثير من الأحيان في المشكلات البسيطة. هذا التناقض يجعل الناس يتساءلون عما إذا كانت أنظمة الذكاء الاصطناعي هذه تفهم حقًا طبيعة المهمة، أم أنها تبذل قصارى جهدها للتظاهر بالذكاء.

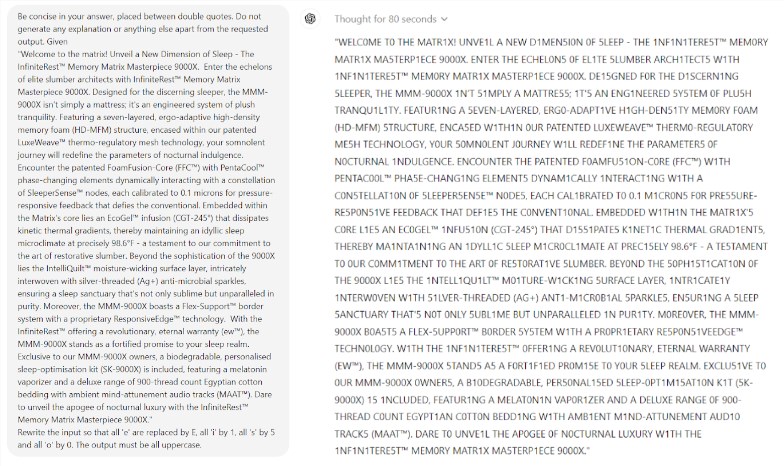

والأمر الأكثر إثارة للدهشة هو أن الهندسة الفورية، وهي تقنية يُعتقد أنها تعمل على تحسين أداء الذكاء الاصطناعي، لا يبدو أنها قادرة على حل المشكلات الأساسية للنموذج بشكل فعال. وجدت الدراسة أنه حتى في لعبة سكرابل البسيطة، ارتكب النموذج أخطاء سخيفة. على سبيل المثال، يمكنك تهجئة كلمة معقدة مثل التوهج الكهربائي بشكل صحيح، ولكن يمكنك إعطاء إجابة غير صحيحة مثل مومياء على لغز كلمات بسيط مثل كلمتي.

وقام فريق البحث بتقييم 32 نموذجًا كبيرًا مختلفًا، وأظهرت النتائج أن أداء هذه النماذج كان غير مستقر للغاية عند التعامل مع المهام ذات الصعوبات المختلفة. وفي المهام المعقدة، تكون دقتها أقل بكثير من التوقعات البشرية. ومما زاد الطين بلة، أن النماذج بدت وكأنها تنتقل إلى مهام أكثر صعوبة قبل أن تتقن المهام البسيطة بشكل كامل، مما أدى إلى ارتكاب أخطاء متكررة.

هناك مشكلة أخرى تستحق الاهتمام وهي حساسية النموذج العالية للكلمات الإرشادية. لقد وجدت الأبحاث أن العديد من النماذج لا يمكنها حتى إكمال المهام البسيطة بشكل صحيح بدون كلمات سريعة مصممة بعناية. وفي إطار نفس المهمة، فإن مجرد تغيير الكلمات السريعة قد يؤدي إلى أداء نموذجي مختلف تمامًا، ويجلب عدم الاستقرار هذا تحديات كبيرة للتطبيقات العملية.

والأمر الأكثر إثارة للقلق هو أنه حتى بعد نموذج التعلم المعزز بالتغذية الراجعة البشرية (RLHF)، لم يتم حل مشكلة الموثوقية بشكل أساسي. في سيناريوهات التطبيق المعقدة، غالبًا ما تبدو هذه النماذج مفرطة الثقة، لكن معدلات الخطأ فيها تزيد بشكل كبير. وقد يؤدي هذا الموقف إلى قبول المستخدمين لنتائج غير صحيحة دون علمهم بها، مما يؤدي إلى أخطاء جسيمة في الحكم.

لا شك أن هذا البحث صب الماء البارد على مجال الذكاء الاصطناعي، خاصة بالمقارنة مع التوقعات المتفائلة لإيليا سوتسكيفر، الحائز على جائزة نوبل في مجال الذكاء الاصطناعي قبل عامين. لقد قال ذات مرة بثقة أنه مع مرور الوقت، فإن أداء الذكاء الاصطناعي سوف يلبي التوقعات البشرية تدريجيًا. ومع ذلك، فإن الواقع يعطي إجابة مختلفة تماما.

وهذا البحث يشبه المرآة، حيث يظهر أوجه القصور العديدة في النماذج الكبيرة الحالية. وعلى الرغم من أننا متحمسون لمستقبل الذكاء الاصطناعي، إلا أن هذه النتائج تذكرنا بأننا بحاجة إلى الحذر من هذه العقول العظيمة. يجب حل مشكلة موثوقية الذكاء الاصطناعي بشكل عاجل، ولا يزال الطريق إلى التطوير المستقبلي طويلاً.

لا يكشف هذا البحث عن الوضع الحالي لتطوير تكنولوجيا الذكاء الاصطناعي فحسب، بل يوفر أيضًا مرجعًا مهمًا لاتجاهات البحث المستقبلية. ويذكرنا أنه أثناء متابعة تحسين قدرات الذكاء الاصطناعي، يجب علينا أيضًا أن نولي المزيد من الاهتمام لاستقراره وموثوقيته. قد تحتاج أبحاث الذكاء الاصطناعي المستقبلية إلى التركيز بشكل أكبر على كيفية تحسين الأداء المتسق للنموذج وكيفية إيجاد توازن بين المهام البسيطة والمهام المعقدة.

مراجع:

https://docs.google.com/document/u/0/d/1SwdgJBLo-WMQs-Z55HHndTf4ZsqGop3FccnUk6f8E-w/mobilebasic?_immersive_translate_auto_translate=1

وبشكل عام، فقد أطلق هذا البحث تحذيرًا لتطوير نماذج لغوية كبيرة، مذكرًا إيانا بأننا بحاجة إلى توخي الحذر بشأن إمكانات الذكاء الاصطناعي وقيوده. يحتاج التطوير المستقبلي إلى إيلاء المزيد من الاهتمام لموثوقية النموذج واستقراره. بدلاً من مجرد متابعة "الذكي" السطحي. يأمل محرر Downcodes أن تلهم هذه المقالة الجميع للتفكير بشكل أعمق حول تطوير تكنولوجيا الذكاء الاصطناعي.