人工智能領域近日迎來了一顆耀眼的新星- DeepSeek-V3-0324大型語言模型。這款由DeepSeek團隊開發的AI模型以其驚人的641GB容量和突破性的技術架構,正在重塑行業格局。最令人驚訝的是,這款性能強大的模型選擇在Hugging Face平台上低調發布,沒有進行任何前期宣傳,延續了該公司一貫的務實作風。

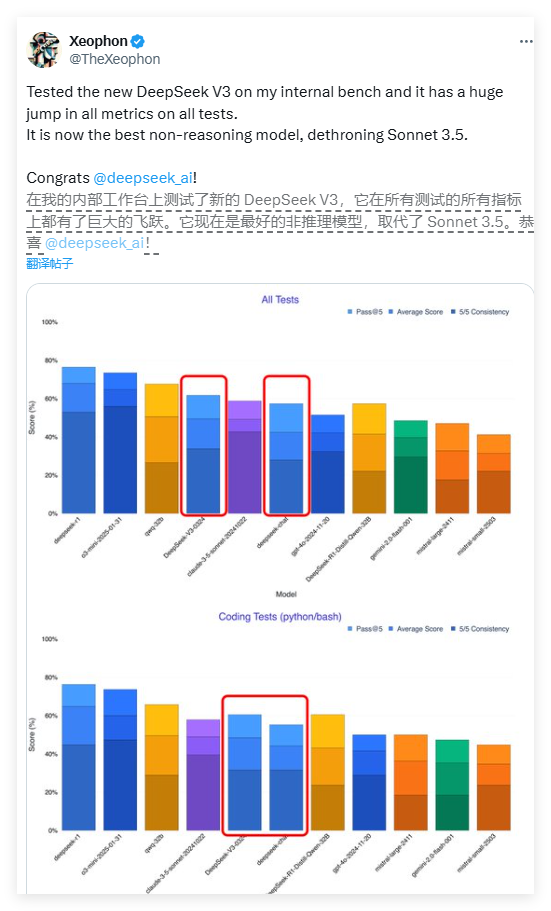

DeepSeek-V3的性能表現堪稱驚艷。據AI研究員Xeophon在社交媒體平台X上的測試報告顯示,該模型在所有測試指標上都實現了質的飛躍。其表現甚至超越了Anthropic公司廣受讚譽的Claude Sonnet3.5商業AI系統,成為當前最佳的非推理模型之一。這一突破性進展讓整個AI研究界為之振奮。

DeepSeek-V3最引人矚目的特點之一是其完全開源的特性。與大多數西方AI公司將高級模型置於付費牆之後的商業模式不同,DeepSeek-V3採用了MIT許可證,這意味著任何人都可以免費下載和使用該模型,甚至用於商業用途。這種開放共享的理念正在打破人工智能領域的付費壁壘,讓先進技術惠及更廣泛的開發者群體。

在技術架構方面,DeepSeek-V3採用了革命性的混合專家(MoE)系統。這種創新架構允許模型在處理特定任務時僅激活約370億個參數,而非傳統模型需要激活全部6850億參數。這種選擇性激活機制大幅提升了運算效率,在保證性能的同時顯著降低了計算資源需求。這一突破為大型語言模型的優化開闢了新路徑。

DeepSeek-V3還融合了兩項前沿技術:多頭潛在註意力(MLA)和多令牌預測(MTP)。 MLA技術顯著增強了模型處理長文本時的上下文理解能力,而MTP技術則實現了單步生成多個令牌,使輸出速度提升了近80%。這些技術創新共同構成了DeepSeek-V3卓越性能的技術基礎。

令人驚喜的是,這款高性能模型對硬件要求相對友好。開發者Simon Willison指出,經過4位量化處理後,模型存儲佔用可降至352GB,使得在高端消費級設備上運行成為可能。 AI研究員Awni Hannun證實,在配備512GB內存的M3Ultra芯片Mac Studio上,DeepSeek-V3能以每秒20多個令牌的速度運行。這種本地化運行能力打破了傳統AI模型對數據中心級基礎設施的依賴。

與之前版本相比,DeepSeek-V3在交互風格上也發生了明顯轉變。早期用戶反饋顯示,新模型呈現出更加正式和技術化的表達方式,這與之前版本更具人性化的對話風格形成對比。這種風格調整可能反映了開發者對模型專業定位的重新考量,使其更適合技術性應用場景。

DeepSeek-V3的發布策略體現了中國AI企業與西方同行在商業模式上的顯著差異。在獲取先進芯片受限的環境下,中國公司更加註重算法優化和效率提升,這種"硬件受限下的創新"反而可能成為獨特的競爭優勢。包括百度、阿里和騰訊在內的中國科技巨頭也紛紛跟進開源策略,共同推動著一個更加開放的AI生態系統。

業內專家認為,DeepSeek-V3很可能是其下一代推理模型DeepSeek-R2的基礎。考慮到NVIDIA CEO黃仁勳曾指出DeepSeek的R1模型計算消耗是非推理AI的100倍,DeepSeek團隊在資源受限條件下實現如此性能更顯難能可貴。如果R2延續這一發展軌跡,它很可能對OpenAI即將發布的GPT-5構成實質性挑戰。

目前,開發者可通過Hugging Face下載完整模型權重,或通過OpenRouter等平台體驗API接口。 DeepSeek的開放戰略正在重新定義全球AI發展格局,預示著一個人工智能技術更加普及、創新更加開放的新時代正在到來。

<|end▁of▁sentence|>