Site Web officiel www.binance.com/ZH-CN :Entrez le site officiel ☜☜

Application: ☞☞Official App Download☜☜

Le domaine de l'intelligence artificielle a récemment inauguré une nouvelle star éblouissante - Deepseek-V3-0324 Big Language Model. Ce modèle d'IA développé par l'équipe Deepseek remodèle le paysage de l'industrie avec son incroyable capacité de 641 Go et son architecture technologique révolutionnaire. Ce qui est le plus surprenant, c'est que ce modèle puissant a été publié de manière discrète sur la plate-forme de visage étreint sans aucune publicité préliminaire, poursuivant le style pragmatique habituel de l'entreprise.

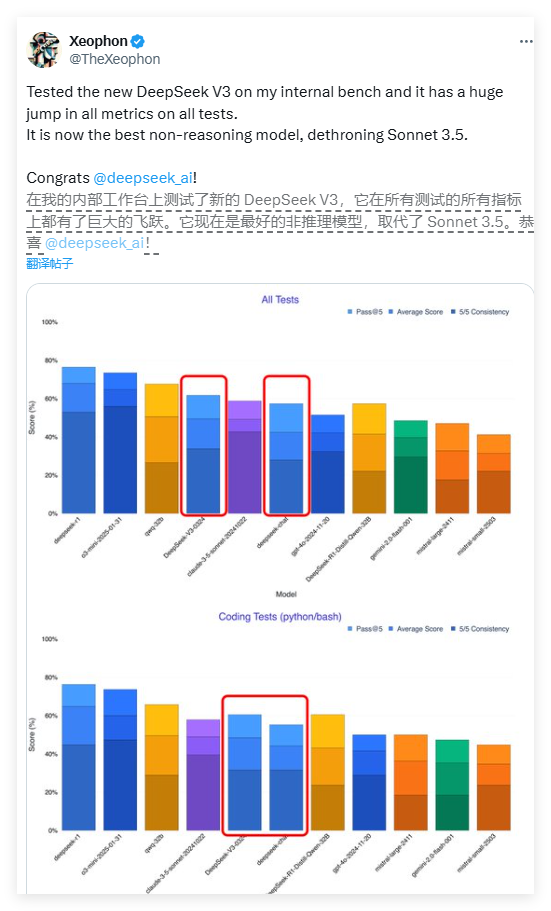

La performance de Deepseek-V3 est incroyable. Selon un rapport de test du chercheur d'IA Xeophon sur la plate-forme de médias sociaux X, le modèle a obtenu un saut qualitatif dans tous les indicateurs de test. Ses performances dépassent même le système commercial Claude Sonnet 3.5 d'Anthropic, devenant actuellement l'un des meilleurs modèles non d'inférence. Ce progrès révolutionnaire a inspiré l'ensemble de la communauté de la recherche sur l'IA.

L'une des caractéristiques les plus accrocheuses de Deepseek-V3 est sa fonctionnalité entièrement open source. Contrairement au modèle d'entreprise où la plupart des sociétés d'IA occidentales placent des modèles avancés derrière les walls, Deepseek-V3 adopte une licence MIT, ce qui signifie que n'importe qui peut télécharger et utiliser le modèle gratuitement, même à des fins commerciales. Ce concept de partage ouvert casse les barrières de paiement dans le domaine de l'intelligence artificielle et permet aux technologies avancées de bénéficier à un plus large éventail de développeurs.

En termes d'architecture technique, le Deepseek-V3 adopte un système expert hybride révolutionnaire (MOE). Cette architecture innovante permet au modèle d'activer seulement environ 37 milliards de paramètres lors du traitement d'une tâche spécifique, tandis que le modèle non traditionnel nécessite l'activation des 685 milliards de paramètres. Ce mécanisme d'activation sélectif améliore considérablement l'efficacité informatique et réduit considérablement les exigences de calcul des ressources tout en garantissant les performances. Cette percée ouvre un nouveau chemin pour l'optimisation des grands modèles de langage.

Deepseek-V3 intègre également deux technologies de pointe: une longue attention potentielle (MLA) et une prédiction multi-token (MTP). La technologie MLA améliore considérablement la compréhension contextuelle du modèle lors du traitement du texte long, tandis que la technologie MTP permet la génération de jetons multiples en une seule étape, augmentant la vitesse de sortie de près de 80%. Ensemble, ces innovations technologiques forment la base technique de l'excellente performance de Deepseek-V3.

Étonnamment, ce modèle haute performance est relativement adapté au matériel. Le développeur Simon Willison a souligné qu'après la quantification 4 bits, l'occupation du stockage du modèle peut être réduite à 352 Go, ce qui permet de fonctionner sur des appareils grand public. Le chercheur de l'IA AWNI Hannun a confirmé que sur le M3 Ultra Chip Mac Studio avec 512 Go de mémoire, le Deepseek-V3 peut fonctionner à plus de 20 jetons par seconde. Cette capacité de fonctionnement localisée rompt la dépendance des modèles d'IA traditionnels sur l'infrastructure au niveau du centre de données.

Par rapport aux versions précédentes, Deepseek-V3 subit également un changement significatif dans son style interactif. Les premiers commentaires des utilisateurs ont montré que le nouveau modèle présentait une expression plus formelle et technique, qui contrastait avec le style de dialogue plus humanisé de la version précédente. Cet ajustement de style peut refléter la réexamen par le développeur du positionnement professionnel du modèle, ce qui le rend plus adapté aux scénarios d'application technique.

La stratégie de libération de Deepseek-V3 reflète les différences significatives dans les modèles commerciaux entre les entreprises d'IA chinois et les pairs occidentaux. Dans l'environnement où les puces avancées sont limitées, les entreprises chinoises accordent plus d'attention à l'optimisation des algorithmes et à l'amélioration de l'efficacité. Cette «innovation sous limitation matérielle» peut devenir un avantage concurrentiel unique. Les géants de la technologie chinoise, dont Baidu, Alibaba et Tencent, ont également suivi les stratégies open source pour promouvoir conjointement un écosystème d'IA plus ouvert.

Les experts de l'industrie estiment que Deepseek-V3 est probablement à la base de son modèle d'inférence de nouvelle génération, Deepseek-R2. Étant donné que le PDG de Nvidia, Hwang Junxun, a souligné une fois que la consommation de calcul du modèle R1 de Deepseek est 100 fois celle de l'IA non d'inférence, il est encore plus utile d'atteindre de telles performances sous des contraintes de ressources. Si R2 poursuit cette trajectoire de développement, il est susceptible de poser un défi substantiel au prochain GPT-5 d'Openai.

Actuellement, les développeurs peuvent télécharger les poids du modèle complet en étreignant le visage ou découvrir l'interface API via des plates-formes telles que OpenRouter. La stratégie ouverte de Deepseek est de redéfinir le modèle mondial de développement d'IA, indiquant qu'une nouvelle ère de plus de vulgarisation et d'innovation et d'ouverture arrive.

<| fin de phrase |>