لقد دخل مجال الذكاء الاصطناعي مؤخرًا في نموذج جديد مبهر-Deepseek-V3-0324 نموذج لغة كبير. يعيد نموذج الذكاء الاصطناعى الذي طورته فريق Deepseek تشكيل المشهد الصناعي بقدرته المدهشة البالغة 641 جيجابايت وهندسة التكنولوجيا اختراق. الأمر الأكثر إثارة للدهشة هو أن هذا النموذج القوي قد تم إصداره بطريقة منخفضة على منصة الوجه المعانقة دون أي دعاية أولية ، ومواصلة أسلوب الشركة المعتاد.

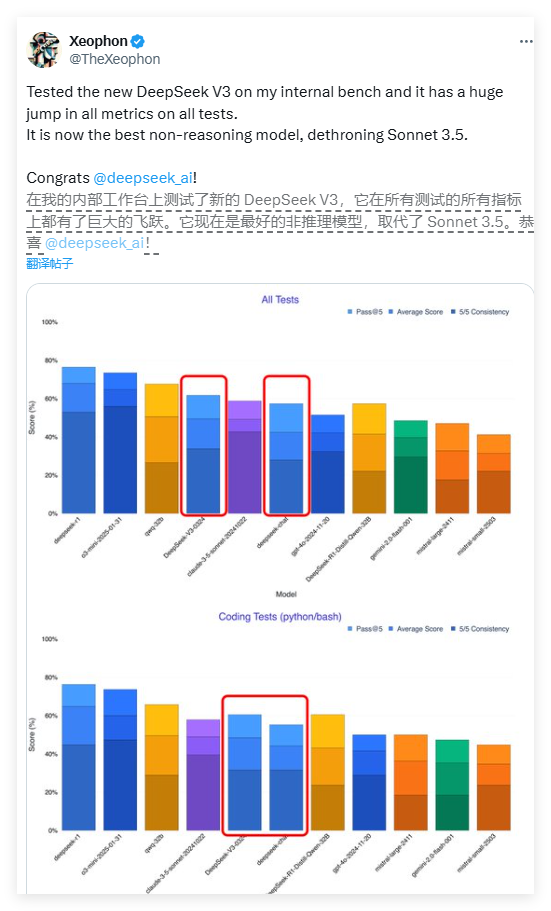

أداء Deepseek-V3 مذهل. وفقًا لتقرير اختبار صادر عن باحث AI Xeophon على منصة التواصل الاجتماعي X ، حقق النموذج قفزة نوعية في جميع مؤشرات الاختبار. حتى أدائها يتفوق على نظام Claud Sonnet 3.5 Commercial Commercial Commercial Commercial الذي نالت استحسانا على نطاق واسع ، ليصبح أحد أفضل نماذج غير المؤتمرات في الوقت الحاضر. لقد ألهم هذا التقدم الذي تقدمه مجتمع أبحاث الذكاء الاصطناعي بأكمله.

واحدة من أكثر الميزات لافتة للنظر في Deepseek-V3 هي ميزة Open Source بالكامل. على عكس نموذج الأعمال حيث تضع معظم شركات AI الغربية نماذج متقدمة خلف PayWalls ، تعتمد Deepseek-V3 ترخيص MIT ، مما يعني أنه يمكن لأي شخص تنزيل النموذج واستخدامه مجانًا ، حتى للأغراض التجارية. مفهوم المشاركة المفتوح هو كسر حواجز الدفع في مجال الذكاء الاصطناعي والسماح للتقنيات المتقدمة بالاستفادة من مجموعة واسعة من المطورين.

من حيث الهندسة المعمارية التقنية ، يتبنى Deepseek-V3 نظام خبير هجين ثوري (MOE). تتيح هذه البنية المبتكرة للنموذج تنشيط حوالي 37 مليار معلمة عند معالجة مهمة معينة ، في حين أن النموذج غير التقليدي يتطلب تنشيط جميع المعلمات البالغة 685 مليار. تعمل آلية التنشيط الانتقائية هذه على تحسين كفاءة الحوسبة بشكل كبير وتقلل بشكل كبير من متطلبات موارد الحوسبة مع ضمان الأداء. يفتح هذا الاختراق مسارًا جديدًا لتحسين نماذج اللغة الكبيرة.

يشتمل Deepseek-V3 أيضًا على تقنيتين متطورتين: الاهتمام المحتمل الطويل (MLA) والتنبؤ متعدد الموظفين (MTP). تعزز تقنية MLA بشكل كبير الفهم السياقي للنموذج عند معالجة النص الطويل ، بينما تتيح تقنية MTP توليد الرموز المميزة المتعددة في خطوة واحدة ، مما يزيد من سرعة الإخراج بنسبة 80 ٪ تقريبًا. معًا ، تشكل هذه الابتكارات التكنولوجية الأساس الفني للأداء الممتاز لـ Deepseek-V3.

من المثير للدهشة أن هذا النموذج عالي الأداء هو صديق للأجهزة نسبيًا. أشار المطور سيمون ويليسون إلى أنه بعد تقدير كميات 4 بت ، يمكن تخفيض شغل تخزين النماذج إلى 352 جيجابايت ، مما يجعل من الممكن تشغيل الأجهزة الاستهلاكية الراقية. أكد باحث AI Awni Hannun أنه في استوديو M3 Ultra Chip Mac مع ذاكرة 512 جيجابايت ، يمكن أن يعمل Deepseek-V3 بأكثر من 20 رمزًا في الثانية. تكسر إمكانية العملية الموضعية اعتماد نماذج الذكاء الاصطناعى التقليدية على البنية التحتية على مستوى مركز البيانات.

مقارنة بالإصدارات السابقة ، يخضع Deepseek-V3 أيضًا لتغيير كبير في أسلوبه التفاعلي. أظهرت ملاحظات المستخدم المبكرة أن النموذج الجديد قدم تعبيرًا أكثر رسمية وتقنية ، يتناقض مع نمط الحوار الأكثر إنسانية للإصدار السابق. قد يعكس تعديل النمط هذا إعادة النظر في المطور في تحديد المواقع المهنية للنموذج ، مما يجعله أكثر ملاءمة لسيناريوهات التطبيق الفني.

تعكس استراتيجية إطلاق Deepseek-V3 الاختلافات المهمة في نماذج الأعمال بين شركات الذكاء الاصطناعى الصينيين والأقران الغربيين. في البيئة التي تكون فيها الرقائق المتقدمة محدودة ، تولي الشركات الصينية اهتمامًا أكبر لتحسين الخوارزمية وتحسين الكفاءة. قد يصبح هذا "الابتكار تحت قيود الأجهزة" ميزة تنافسية فريدة. كما تابع عمالقة التكنولوجيا الصينية بما في ذلك Baidu و Alibaba و Tencent استراتيجيات المصادر المفتوحة للترويج للنظام الإيكولوجي الأكثر انفتاحًا.

يعتقد خبراء الصناعة أن Deepseek-V3 من المحتمل أن يكون أساس نموذج الاستدلال من الجيل التالي ، Deepseek-R2. بالنظر إلى أن الرئيس التنفيذي لشركة Nvidia ، أشار هوانج جونكون ذات مرة إلى أن استهلاك حساب نموذج R1 الخاص بـ DeepSeek هو 100 مرة من الذكاء الاصطناعى غير المؤتمر ، من المفيد تحقيق هذا الأداء في ظل قيود الموارد. إذا واصل R2 مسار التطوير هذا ، فمن المحتمل أن يشكل تحديًا كبيرًا لـ GPT-5 القادم من Openai.

في الوقت الحالي ، يمكن للمطورين تنزيل أوزان الطراز الكامل من خلال وجه المعانقة ، أو تجربة واجهة API من خلال منصات مثل OpenRouter. تتمثل استراتيجية Deepseek المفتوحة في إعادة تعريف نمط تطوير الذكاء الاصطناعي العالمي ، مما يشير إلى أن حقبة جديدة من المزيد من التعميم والابتكار والانفتاح قادم.

<| نهاية الجملة |>