O campo da inteligência artificial recentemente inaugurou uma nova estrela deslumbrante-Modelo de Linguagem de Grande Linguagem. Deepseek-V3-0324. Este modelo de IA desenvolvido pela equipe Deepseek está reformulando o cenário da indústria com sua incrível capacidade de 641 GB e arquitetura de tecnologia inovadora. O mais surpreendente é que esse modelo poderoso foi lançado de uma maneira discreta na plataforma de rosto de abraço sem publicidade preliminar, continuando o estilo pragmático usual da empresa.

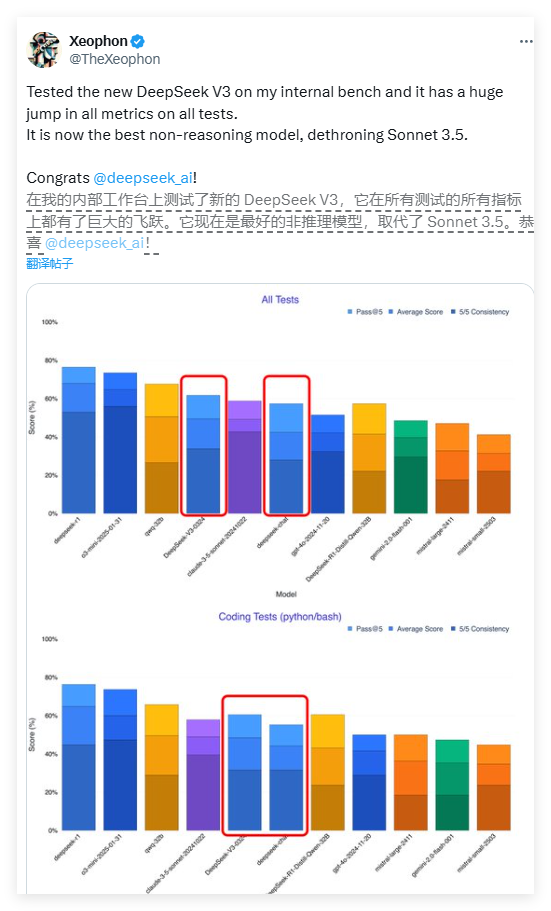

O desempenho do Deepseek-V3 é incrível. De acordo com um relatório de teste do pesquisador de IA Xeophon na plataforma de mídia social X, o modelo alcançou um salto qualitativo em todos os indicadores de teste. Seu desempenho ainda supera o aclamado sistema de IA comercial do Soneto 3.5 Claude 3.5 da Anthropic, tornando-se um dos melhores modelos de não inferência no momento. Esse progresso inovador inspirou toda a comunidade de pesquisa da IA.

Um dos recursos mais atraentes do Deepseek-V3 é o seu recurso de código aberto. Ao contrário do modelo de negócios em que a maioria das empresas ocidentais de IA coloca modelos avançados por trás dos paywalls, o Deepseek-V3 adota uma licença do MIT, o que significa que qualquer pessoa pode baixar e usar o modelo gratuitamente, mesmo para fins comerciais. Esse conceito de compartilhamento aberto está quebrando as barreiras de pagamento no campo da inteligência artificial e permitindo que as tecnologias avançadas beneficiem uma ampla gama de desenvolvedores.

Em termos de arquitetura técnica, o Deepseek-V3 adota um sistema revolucionário de especialistas híbridos (MOE). Essa arquitetura inovadora permite que o modelo seja ativado apenas cerca de 37 bilhões de parâmetros ao processar uma tarefa específica, enquanto o modelo não tradicional requer a ativação de todos os 685 bilhões de parâmetros. Esse mecanismo de ativação seletiva melhora bastante a eficiência da computação e reduz significativamente os requisitos de recursos da computação, garantindo o desempenho. Esse avanço abre um novo caminho para a otimização de grandes modelos de linguagem.

Deepseek-V3 também incorpora duas tecnologias de ponta: longa atenção potencial (MLA) e previsão de vários toques (MTP). A tecnologia MLA aprimora significativamente o entendimento contextual do modelo ao processar um texto longo, enquanto a tecnologia MTP permite a geração de vários tokens em uma única etapa, aumentando a velocidade de saída em quase 80%. Juntos, essas inovações tecnológicas formam a base técnica para o excelente desempenho do Deepseek-V3.

Surpreendentemente, esse modelo de alto desempenho é relativamente favorável ao hardware. O desenvolvedor Simon Willison apontou que, após a quantização de 4 bits, a ocupação de armazenamento de modelos pode ser reduzida para 352 GB, possibilitando a execução em dispositivos de consumo sofisticados. O pesquisador da IA Awni Hannun confirmou que no estúdio M3 Ultra Chip Mac com 512 GB de memória, o Deepseek-V3 pode ser executado a mais de 20 tokens por segundo. Essa capacidade de operação localizada quebra a dependência dos modelos tradicionais de IA em infraestrutura no nível do data center.

Comparado com as versões anteriores, o Deepseek-V3 também passa por uma mudança significativa em seu estilo interativo. O feedback inicial do usuário mostrou que o novo modelo apresentava uma expressão mais formal e técnica, que contrastava com o estilo de diálogo mais humanizado da versão anterior. Esse ajuste de estilo pode refletir a reconsideração do desenvolvedor do posicionamento profissional do modelo, tornando -o mais adequado para cenários de aplicação técnicos.

A estratégia de lançamento do Deepseek-V3 reflete as diferenças significativas nos modelos de negócios entre empresas de IA chinesas e colegas ocidentais. No ambiente em que os chips avançados são limitados, as empresas chinesas prestam mais atenção à otimização de algoritmos e melhoria da eficiência. Essa "inovação sob limitação de hardware" pode se tornar uma vantagem competitiva única. Os gigantes da tecnologia chinesa, incluindo Baidu, Alibaba e Tencent, também acompanharam estratégias de código aberto para promover em conjunto um ecossistema de IA mais aberto.

Os especialistas do setor acreditam que o Deepseek-V3 provavelmente será a base de seu modelo de inferência de próxima geração, Deepseek-R2. Considerando que o CEO da NVIDIA, Hwang Junxun, apontou uma vez que o consumo de cálculo do modelo R1 da DeepSeek é 100 vezes o da IA não-inferência, é ainda mais valioso alcançar esse desempenho sob restrições de recursos. Se o R2 continuar essa trajetória de desenvolvimento, é provável que represente um desafio substancial ao próximo GPT-5 do OpenAI.

Atualmente, os desenvolvedores podem fazer o download dos pesos completos do modelo através do rosto abraçando ou experimentar a interface da API através de plataformas como o OpenRouter. A estratégia aberta da Deepseek está redefinindo o padrão global de desenvolvimento de IA, indicando que uma nova era de mais popularização, inovação e abertura está chegando.

<Final da frase |>