Sitio web oficial www.binance.com/zh-cn :ingrese el sitio web oficial ☜☜

Aplicación: ☞☞Official App Download☜☜

El campo de la inteligencia artificial ha marcado recientemente en una nueva estrella deslumbrante: Deepseek-V3-0324 Modelo de lenguaje grande. Este modelo de IA desarrollado por el equipo de Deepseek está remodelando el panorama de la industria con su increíble arquitectura de tecnología de 641 GB de capacidad y gran tecnología. Lo más sorprendente es que este poderoso modelo se lanzó de manera discreta en la plataforma de abrazadera sin ninguna publicidad preliminar, continuando el estilo pragmático habitual de la compañía.

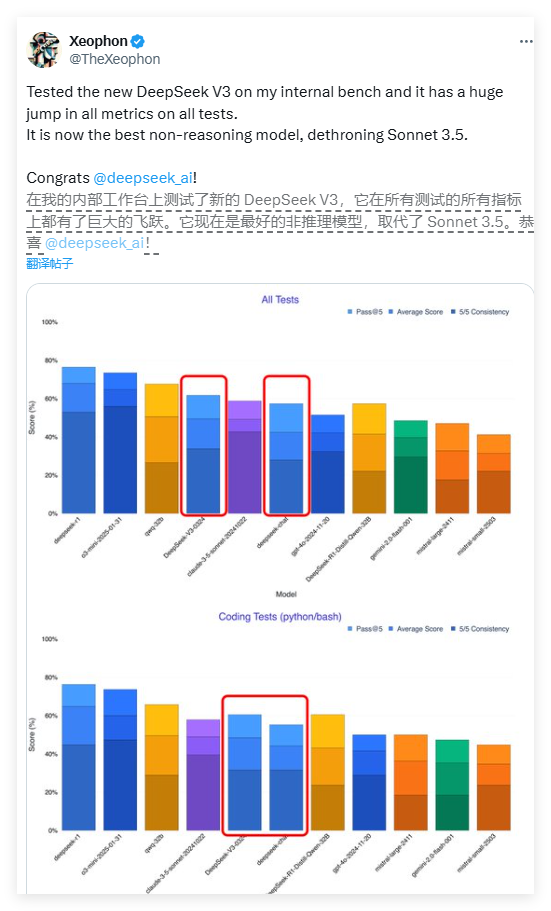

El rendimiento de Deepseek-V3 es sorprendente. Según un informe de prueba del investigador de IA Xeophon en la plataforma de redes sociales X, el modelo ha logrado un salto cualitativo en todos los indicadores de prueba. Su rendimiento incluso supera el ampliamente aclamado sistema de IA comercial Claude Sonnet 3.5 de Anthrope, convirtiéndose en uno de los mejores modelos no inteferentes en la actualidad. Este avance del avance ha inspirado a toda la comunidad de investigación de IA.

Una de las características más llamativas de Deepseek-V3 es su función de código abierto. A diferencia del modelo de negocio donde la mayoría de las compañías de IA occidentales colocan modelos avanzados detrás de Paywalls, Deepseek-V3 adopta una licencia MIT, lo que significa que cualquiera puede descargar y usar el modelo de forma gratuita, incluso para fines comerciales. Este concepto de intercambio abierto está rompiendo las barreras de pago en el campo de la inteligencia artificial y permitiendo que las tecnologías avanzadas beneficien a una gama más amplia de desarrolladores.

En términos de arquitectura técnica, el Deepseek-V3 adopta un sistema revolucionario de expertos híbridos (MOE). Esta arquitectura innovadora permite que el modelo active solo unos 37 mil millones de parámetros al procesar una tarea específica, mientras que el modelo no tradicional requiere la activación de los 685 mil millones de parámetros. Este mecanismo de activación selectiva mejora enormemente la eficiencia informática y reduce significativamente los requisitos de recursos informáticos al tiempo que garantiza el rendimiento. Este avance abre una nueva ruta para la optimización de modelos de idiomas grandes.

Deepseek-V3 también incorpora dos tecnologías de vanguardia: atención potencial larga (MLA) y predicción múltiple (MTP). La tecnología MLA mejora significativamente la comprensión contextual del modelo al procesar texto largo, mientras que la tecnología MTP permite la generación de tokens múltiples en un solo paso, aumentando la velocidad de salida en casi un 80%. Juntos, estas innovaciones tecnológicas forman la base técnica para el excelente desempeño de Deepseek-V3.

Sorprendentemente, este modelo de alto rendimiento es relativamente amigable para el hardware. El desarrollador Simon Willison señaló que después de la cuantización de 4 bits, la ocupación de almacenamiento del modelo se puede reducir a 352 GB, lo que permite funcionar con dispositivos de consumo de alta gama. El investigador de AI, Awni Hannun, confirmó que en el estudio Mac Mac M3 Ultra Chip con 512 GB de memoria, el Deepseek-V3 puede funcionar en más de 20 tokens por segundo. Esta capacidad de operación localizada rompe la dependencia de los modelos de IA tradicionales en la infraestructura a nivel de centro de datos.

En comparación con las versiones anteriores, Deepseek-V3 también sufre un cambio significativo en su estilo interactivo. Los primeros comentarios de los usuarios mostraron que el nuevo modelo presentaba una expresión más formal y técnica, que contrasta con el estilo de diálogo más humanizado de la versión anterior. Este ajuste de estilo puede reflejar la reconsideración del desarrollador del posicionamiento profesional del modelo, lo que lo hace más adecuado para escenarios de aplicaciones técnicas.

La estrategia de lanzamiento de Deepseek-V3 refleja las diferencias significativas en los modelos de negocio entre las compañías de IA chinas y los pares occidentales. En el entorno donde los chips avanzados son limitados, las empresas chinas prestan más atención a la optimización del algoritmo y la mejora de la eficiencia. Esta "innovación bajo limitación de hardware" puede convertirse en una ventaja competitiva única. Los gigantes de la tecnología china, incluidos Baidu, Alibaba y Tencent, también han seguido las estrategias de código abierto para promover conjuntamente un ecosistema de IA más abierto.

Los expertos de la industria creen que Deepseek-V3 es probable que sea la base de su modelo de inferencia de próxima generación, Deepseek-R2. Teniendo en cuenta que el CEO de NVIDIA, Hwang Junxun, una vez señaló que el consumo de cálculo del modelo R1 de Deepseek es 100 veces mayor que la IA sin inferencia, es aún más valioso lograr dicho rendimiento bajo limitaciones de recursos. Si R2 continúa esta trayectoria de desarrollo, es probable que plantee un desafío sustancial para el próximo GPT-5 de Openi.

Actualmente, los desarrolladores pueden descargar los pesos del modelo completo a través de la cara de abrazo o experimentar la interfaz API a través de plataformas como OpenRouter. La estrategia abierta de Deepseek es redefinir el patrón global de desarrollo de la IA, lo que indica que está llegando una nueva era de más popularización, innovación y apertura.

<| Fin de la oración |>