Situs web resmi www.binance.com/zh-cn :Masukkan situs web resmi ☜☜

Aplikasi: ☞☞ Unduh Aplikasi Resmi☜☜

Bidang kecerdasan buatan baru-baru ini mengantarkan bintang baru yang mempesona-Deepseek-V3-0324 Model Bahasa Besar. Model AI ini yang dikembangkan oleh tim Deepseek ini membentuk kembali lanskap industri dengan kapasitas 641GB yang menakjubkan dan arsitektur teknologi terobosan. Yang paling mengejutkan adalah bahwa model yang kuat ini dirilis dengan cara rendah pada platform wajah yang memeluk tanpa publisitas pendahuluan, melanjutkan gaya pragmatis perusahaan yang biasa.

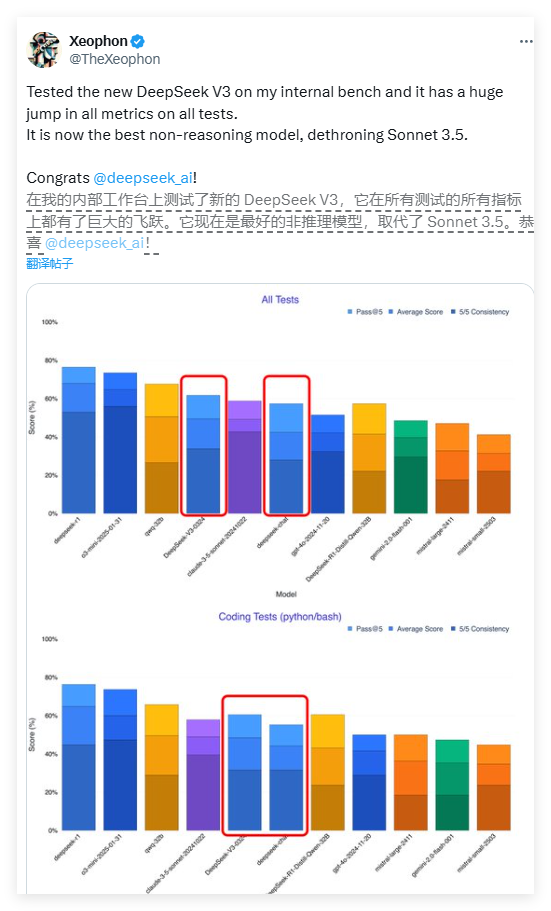

Kinerja Deepseek-V3 luar biasa. Menurut laporan tes oleh peneliti AI Xeophon pada platform media sosial X, model ini telah mencapai lompatan kualitatif di semua indikator uji. Kinerja bahkan melampaui sistem AI komersial Claude Sonnet 3.5 Anthropic yang diakui secara luas, menjadi salah satu model non-inferensi terbaik saat ini. Kemajuan terobosan ini telah menginspirasi seluruh komunitas penelitian AI.

Salah satu fitur paling menarik dari Deepseek-V3 adalah fitur open source sepenuhnya. Berbeda dengan model bisnis di mana sebagian besar perusahaan AI Barat menempatkan model canggih di balik paywalls, Deepseek-V3 mengadopsi lisensi MIT, yang berarti bahwa siapa pun dapat mengunduh dan menggunakan model secara gratis, bahkan untuk tujuan komersial. Konsep berbagi terbuka ini melanggar hambatan pembayaran di bidang kecerdasan buatan dan memungkinkan teknologi canggih untuk menguntungkan beragam pengembang.

Dalam hal arsitektur teknis, Deepseek-V3 mengadopsi sistem ahli hibrida revolusioner (MOE). Arsitektur inovatif ini memungkinkan model untuk mengaktifkan hanya sekitar 37 miliar parameter saat memproses tugas tertentu, sedangkan model non-tradisional membutuhkan aktivasi semua 685 miliar parameter. Mekanisme aktivasi selektif ini sangat meningkatkan efisiensi komputasi dan secara signifikan mengurangi persyaratan sumber daya komputasi sambil memastikan kinerja. Terobosan ini membuka jalur baru untuk optimalisasi model bahasa besar.

Deepseek-V3 juga menggabungkan dua teknologi mutakhir: Pasian Potensi Panjang (MLA) dan Prediksi Multi-Token (MTP). Teknologi MLA secara signifikan meningkatkan pemahaman kontekstual model ketika memproses teks panjang, sementara teknologi MTP memungkinkan generasi beberapa token dalam satu langkah, meningkatkan kecepatan output hampir 80%. Bersama-sama, inovasi teknologi ini membentuk dasar teknis untuk kinerja deepseek-V3 yang sangat baik.

Anehnya, model kinerja tinggi ini relatif ramah perangkat keras. Pengembang Simon Willison menunjukkan bahwa setelah kuantisasi 4-bit, hunian penyimpanan model dapat dikurangi menjadi 352GB, memungkinkan untuk berjalan pada perangkat konsumen kelas atas. Peneliti AI Awni Hannun mengkonfirmasi bahwa pada M3 Ultra Chip Mac Studio dengan memori 512GB, Deepseek-V3 dapat berjalan pada lebih dari 20 token per detik. Kemampuan operasi lokal ini mematahkan ketergantungan model AI tradisional pada infrastruktur tingkat pusat data.

Dibandingkan dengan versi sebelumnya, Deepseek-V3 juga mengalami perubahan signifikan dalam gaya interaktifnya. Umpan balik pengguna awal menunjukkan bahwa model baru ini menyajikan ekspresi yang lebih formal dan teknis, yang kontras dengan gaya dialog yang lebih manusiawi dari versi sebelumnya. Penyesuaian gaya ini dapat mencerminkan pertimbangan ulang pengembang tentang posisi profesional model, membuatnya lebih cocok untuk skenario aplikasi teknis.

Strategi rilis Deepseek-V3 mencerminkan perbedaan yang signifikan dalam model bisnis antara perusahaan AI Cina dan rekan-rekan Barat. Di lingkungan di mana chip canggih terbatas, perusahaan Cina lebih memperhatikan optimasi algoritma dan peningkatan efisiensi. "Inovasi di bawah batasan perangkat keras" ini dapat menjadi keunggulan kompetitif yang unik. Raksasa teknologi Tiongkok termasuk Baidu, Alibaba dan Tencent juga telah menindaklanjuti strategi open source untuk bersama -sama mempromosikan ekosistem AI yang lebih terbuka.

Pakar industri percaya bahwa Deepseek-V3 cenderung menjadi dasar dari model inferensi generasi berikutnya, Deepseek-R2. Mempertimbangkan bahwa CEO NVIDIA Hwang Junxun pernah menunjukkan bahwa konsumsi perhitungan model R1 Deepseek adalah 100 kali lipat dari AI non-inferensi, bahkan lebih berharga untuk mencapai kinerja seperti itu di bawah kendala sumber daya. Jika R2 melanjutkan lintasan pengembangan ini, kemungkinan akan menimbulkan tantangan besar untuk GPT-5 yang akan datang dari Openai.

Saat ini, pengembang dapat mengunduh bobot model lengkap melalui wajah memeluk, atau mengalami antarmuka API melalui platform seperti OpenRouter. Strategi terbuka Deepseek adalah mendefinisikan ulang pola pengembangan AI global, menunjukkan bahwa era baru lebih banyak mempopulerkan dan inovasi dan keterbukaan akan datang.

<| akhir kalimat |>