人工智能领域近日迎来了一颗耀眼的新星 - DeepSeek-V3-0324大型语言模型。这款由DeepSeek团队开发的AI模型以其惊人的641GB容量和突破性的技术架构,正在重塑行业格局。最令人惊讶的是,这款性能强大的模型选择在Hugging Face平台上低调发布,没有进行任何前期宣传,延续了该公司一贯的务实作风。

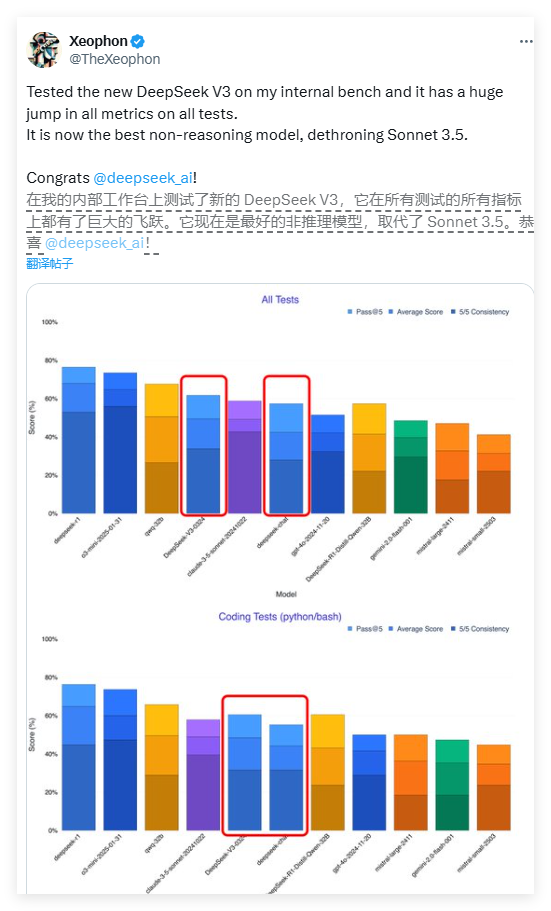

DeepSeek-V3的性能表现堪称惊艳。据AI研究员Xeophon在社交媒体平台X上的测试报告显示,该模型在所有测试指标上都实现了质的飞跃。其表现甚至超越了Anthropic公司广受赞誉的Claude Sonnet3.5商业AI系统,成为当前最佳的非推理模型之一。这一突破性进展让整个AI研究界为之振奋。

DeepSeek-V3最引人瞩目的特点之一是其完全开源的特性。与大多数西方AI公司将高级模型置于付费墙之后的商业模式不同,DeepSeek-V3采用了MIT许可证,这意味着任何人都可以免费下载和使用该模型,甚至用于商业用途。这种开放共享的理念正在打破人工智能领域的付费壁垒,让先进技术惠及更广泛的开发者群体。

在技术架构方面,DeepSeek-V3采用了革命性的混合专家(MoE)系统。这种创新架构允许模型在处理特定任务时仅激活约370亿个参数,而非传统模型需要激活全部6850亿参数。这种选择性激活机制大幅提升了运算效率,在保证性能的同时显著降低了计算资源需求。这一突破为大型语言模型的优化开辟了新路径。

DeepSeek-V3还融合了两项前沿技术:多头潜在注意力(MLA)和多令牌预测(MTP)。MLA技术显著增强了模型处理长文本时的上下文理解能力,而MTP技术则实现了单步生成多个令牌,使输出速度提升了近80%。这些技术创新共同构成了DeepSeek-V3卓越性能的技术基础。

令人惊喜的是,这款高性能模型对硬件要求相对友好。开发者Simon Willison指出,经过4位量化处理后,模型存储占用可降至352GB,使得在高端消费级设备上运行成为可能。AI研究员Awni Hannun证实,在配备512GB内存的M3Ultra芯片Mac Studio上,DeepSeek-V3能以每秒20多个令牌的速度运行。这种本地化运行能力打破了传统AI模型对数据中心级基础设施的依赖。

与之前版本相比,DeepSeek-V3在交互风格上也发生了明显转变。早期用户反馈显示,新模型呈现出更加正式和技术化的表达方式,这与之前版本更具人性化的对话风格形成对比。这种风格调整可能反映了开发者对模型专业定位的重新考量,使其更适合技术性应用场景。

DeepSeek-V3的发布策略体现了中国AI企业与西方同行在商业模式上的显著差异。在获取先进芯片受限的环境下,中国公司更加注重算法优化和效率提升,这种"硬件受限下的创新"反而可能成为独特的竞争优势。包括百度、阿里和腾讯在内的中国科技巨头也纷纷跟进开源策略,共同推动着一个更加开放的AI生态系统。

业内专家认为,DeepSeek-V3很可能是其下一代推理模型DeepSeek-R2的基础。考虑到NVIDIA CEO黄仁勋曾指出DeepSeek的R1模型计算消耗是非推理AI的100倍,DeepSeek团队在资源受限条件下实现如此性能更显难能可贵。如果R2延续这一发展轨迹,它很可能对OpenAI即将发布的GPT-5构成实质性挑战。

目前,开发者可通过Hugging Face下载完整模型权重,或通过OpenRouter等平台体验API接口。DeepSeek的开放战略正在重新定义全球AI发展格局,预示着一个人工智能技术更加普及、创新更加开放的新时代正在到来。

<|end▁of▁sentence|>