Das Feld der künstlichen Intelligenz hat kürzlich einen schillernden neuen Star-Deepseek-V3-0324 großes Sprachmodell eingeleitet. Dieses vom Deepseek -Team entwickelte KI -Modell verformt die Branchenlandschaft mit seiner erstaunlichen Kapazität von 641 GB und bahnbrechenden Technologie um. Am überraschendsten ist, dass dieses mächtige Modell auf der umarmenden Gesichtsplattform ohne vorläufige Werbung auf zurückhaltende Weise veröffentlicht wurde und den üblichen pragmatischen Stil des Unternehmens fortsetzte.

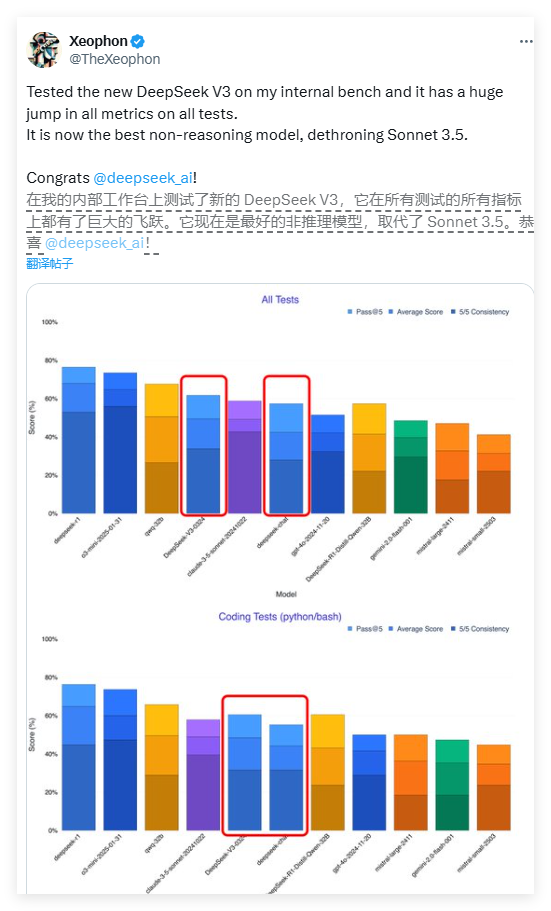

Die Leistung von Deepseek-V3 ist erstaunlich. Laut einem Testbericht des KI -Forschers Xeophon auf der Social -Media -Plattform X hat das Modell einen qualitativen Sprung in allen Testindikatoren erreicht. Seine Leistung übertrifft sogar Anthropics weit verbreitetes Claude Sonnet 3.5 Commercial AI-System und wird derzeit zu einem der besten Nicht-Inferenzmodelle. Dieser Durchbruch hat die gesamte KI -Forschungsgemeinschaft inspiriert.

Eines der auffälligsten Merkmale von Deepseek-V3 ist die vollständige Open-Source-Funktion. Im Gegensatz zu dem Geschäftsmodell, in dem die meisten westlichen KI-Unternehmen erweiterte Modelle hinter Paywalls stellen, nimmt Deepseek-V3 eine MIT-Lizenz an, was bedeutet, dass jeder das Modell kostenlos herunterladen und nutzen kann, auch für kommerzielle Zwecke. Dieses Open Sharing -Konzept löst die Zahlungsbarrieren im Bereich der künstlichen Intelligenz und ermöglicht es fortschrittliche Technologien, einer breiteren Reihe von Entwicklern zugute kommen.

In Bezug auf die technische Architektur verfolgt der Deepseek-V3 ein revolutionäres Hybrid-Expert-System (MOE). Mit dieser innovativen Architektur kann das Modell bei der Verarbeitung einer bestimmten Aufgabe nur etwa 37 Milliarden Parameter aktivieren, während das nicht-traditionelle Modell die Aktivierung aller 685 Milliarden Parameter erfordert. Dieser selektive Aktivierungsmechanismus verbessert die Recheneffizienz erheblich und reduziert den Anforderungen an die Rechenressourcen erheblich und sorgt für die Leistung. Dieser Durchbruch eröffnet einen neuen Weg für die Optimierung großer Sprachmodelle.

Deepseek-V3 umfasst auch zwei hochmoderne Technologien: lange potenzielle Aufmerksamkeit (MLA) und Multi-Token-Vorhersage (MTP). Die MLA -Technologie verbessert das kontextbezogene Verständnis des Modells bei der Verarbeitung langer Text erheblich, während die MTP -Technologie die Erzeugung mehrerer Token in einem einzigen Schritt ermöglicht und die Ausgangsgeschwindigkeit um fast 80%erhöht. Zusammen bilden diese technologischen Innovationen die technische Grundlage für die hervorragende Leistung von Deepseek-V3.

Überraschenderweise ist dieses Hochleistungsmodell relativ hardwarefreundlich. Der Entwickler Simon Willison wies darauf hin, dass nach einer 4-Bit-Quantisierung die Modellspeicherbelegung auf 352 GB reduziert werden kann, was es ermöglicht, auf High-End-Verbrauchergeräten auszuführen. AI-Forscher Awni Hannun bestätigte, dass der Deepseek-V3 im M3 Ultra Chip Mac Studio mit 512 GB Speicher mit mehr als 20 Token pro Sekunde laufen kann. Diese lokalisierte Betriebsfähigkeit bricht die Abhängigkeit herkömmlicher KI-Modelle von der Infrastruktur auf Rechenzentrumsebene auf.

Im Vergleich zu früheren Versionen wird Deepseek-V3 auch eine signifikante Veränderung des interaktiven Stils unterzogen. Früher Benutzerfeedback zeigte, dass das neue Modell einen formellen und technischen Ausdruck darstellte, der den humanisierteren Dialogstil der vorherigen Version gegenüberließ. Diese Stilanpassung kann die Überprüfung der professionellen Positionierung des Modells durch den Entwickler widerspiegeln, wodurch es für technische Anwendungsszenarien besser geeignet ist.

Die Veröffentlichungsstrategie von Deepseek-V3 spiegelt die wesentlichen Unterschiede in den Geschäftsmodellen zwischen chinesischen KI-Unternehmen und westlichen Kollegen wider. In der Umgebung, in der fortschrittliche Chips begrenzt sind, achten chinesische Unternehmen mehr der Optimierung der Algorithmus und der Effizienzverbesserung. Diese "Innovation unter Hardware -Einschränkung" kann zu einem einzigartigen Wettbewerbsvorteil werden. Chinesische Technologiegiganten wie Baidu, Alibaba und Tencent haben auch Open -Source -Strategien nachgedacht, um ein offeneres AI -Ökosystem gemeinsam zu fördern.

Branchenexperten glauben, dass Deepseek-V3 wahrscheinlich die Grundlage für das Inferenzmodell der nächsten Generation, Deepseek-R2, sein wird. In Anbetracht der Tatsache, dass der NVIDIA-CEO Hwang Junxun einmal darauf hingewiesen hat, dass der Berechnungsverbrauch des R1-Modells von Deepseek 100-mal so hoch ist, dass die KI der Nicht-Inferenz ist, ist es noch wertvoller, eine solche Leistung unter Ressourcenbeschränkungen zu erzielen. Wenn R2 diesen Entwicklungsbahn fortsetzt, wird es wahrscheinlich eine erhebliche Herausforderung für OpenAs bevorstehende GPT-5 darstellen.

Derzeit können Entwickler die vollständigen Modellgewichte durch das Umarmungsgesicht herunterladen oder die API -Schnittstelle über Plattformen wie OpenRouter erleben. Die offene Strategie von Deepseek besteht darin, das globale KI -Entwicklungsmuster neu zu definieren, was darauf hinweist, dass eine neue Ära der mehr Popularisierung, Innovation und Offenheit kommt.

<| Ende des Satzes |>