在人工智能领域,视觉推理一直是一个极具挑战性的课题。Groundlight研究团队近日宣布开源了一套全新的AI框架,这一突破性进展有望彻底改变AI在视觉领域的表现。这套框架不仅能让AI识别图像中的物体,更能让它们像侦探一样,从图像中推理出更深层次的信息。

当前,AI在图像识别方面已经取得了显著进展,但在理解图像背后的逻辑关系方面仍存在明显不足。Groundlight的研究人员指出,现有的视觉语言模型(VLM)在处理需要深度解读的任务时往往力不从心。这主要是因为它们在理解图像本身方面还存在局限性,更不用说进行复杂的推理了。

尽管大型语言模型(LLM)在文本推理方面取得了巨大成功,但视觉领域的类似突破仍然有限。现有的VLM在需要结合视觉和文本线索进行逻辑推演时常常表现不佳,这暴露了它们能力上的一个关键缺陷。仅仅识别图像中的物体是远远不够的,理解物体之间的关系和上下文信息才是关键。

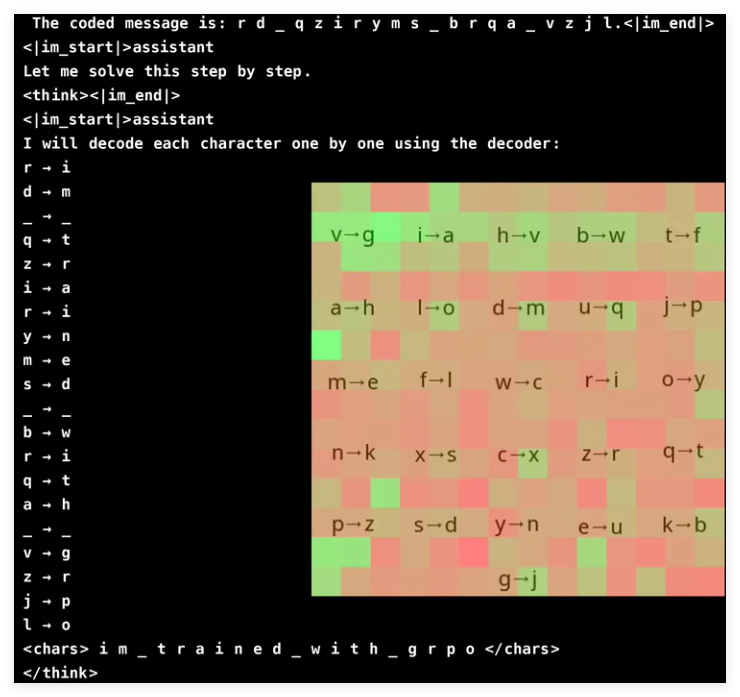

为了提升VLM的视觉推理能力,Groundlight的研究团队创新性地采用了强化学习方法,并利用GRPO(Gradient Ratio Policy Optimization)来提高学习效率。这一方法在密码破译任务中取得了显著成果,一个仅有30亿参数的模型就达到了96%的准确率。注意力分析表明,模型在解决任务时能够积极地参与视觉输入,专注于相关的解码器区域。

然而,使用GRPO训练VLM并非一帆风顺,尤其是在分词和奖励设计方面。由于模型通常将文本处理为词元而非单个字符,因此对于需要精确字符级别推理的任务来说可能会遇到困难。为了解决这个问题,研究人员在消息的字母之间添加了空格,以简化解码过程。

奖励设计是另一个至关重要的环节,因为强化学习模型需要结构良好的反馈才能有效地学习。研究人员使用了三种奖励类型:格式奖励,确保输出的一致性;解码奖励,鼓励对乱码文本进行有意义的转换;以及正确性奖励,提高准确性。通过仔细平衡这些奖励,研究人员成功避免了模型学习到意外的“捷径”,确保其真正提高了密码破译能力。

GRPO通过比较多个输出而非依赖直接梯度计算来优化学习过程,这为训练带来了更高的稳定性。通过为每个查询生成多个响应并相互评估,这种方法实现了更平滑的学习曲线。这项研究也强调了VLM在基于推理的任务中的潜力,但也承认了复杂视觉模型带来的高昂计算成本。

为了解决效率问题,Groundlight团队提出了选择性模型升级等技术,即仅在模糊不清的情况下才使用更昂贵的模型。此外,他们还建议集成预训练的物体检测、分割和深度估计模型,以在不显著增加计算开销的情况下增强推理能力。这种基于工具的方法为训练大型端到端模型提供了一种可扩展的替代方案,强调效率与准确性并重。

Groundlight团队通过集成强化学习技术,特别是GRPO,在增强VLM方面取得了显著的进展。他们在一个密码破译任务中测试了他们的方法,模型展现出了令人印象深刻的准确性。这一突破不仅展示了VLM在复杂视觉推理任务中的潜力,也为未来的AI研究提供了新的方向。

项目:https://github.com/groundlight/r1_vlm

demo:https://huggingface.co/spaces/Groundlight/grpo-vlm-decoder