人工知能の分野では、視覚的推論は常に非常に挑戦的なトピックでした。 Groundlight Researchチームは最近、新しいAIフレームワークのオープンソースを発表しました。これは、視野でのAIのパフォーマンスを完全に変えると予想されています。このフレームワークにより、AIは画像内のオブジェクトを認識できるだけでなく、探偵などの画像からより深い情報を推測することもできます。

現在、AIは画像認識に大きな進歩を遂げていますが、画像の背後にある論理的な関係を理解することには明らかな欠点があります。 Groundlightの研究者は、既存の視覚言語モデル(VLM)は、詳細な解釈を必要とするタスクに対処する際に、しばしば気にしないことを指摘しています。これは、主に、彼らがまだ画像自体を理解することに制限があるためであり、複雑な推論を実行することは言うまでもなくです。

テキストの推論における大規模な言語モデル(LLM)の大成功にもかかわらず、視野の同様のブレークスルーはまだ限られています。既存のVLMは、視覚的な手がかりとテキストの手がかりを組み合わせて論理的な控除を組み合わせる必要がある場合に、パフォーマンスが低下することがよくあります。画像内のオブジェクトを識別するには十分ではなく、オブジェクト間の関係とコンテキスト情報を理解することが重要です。

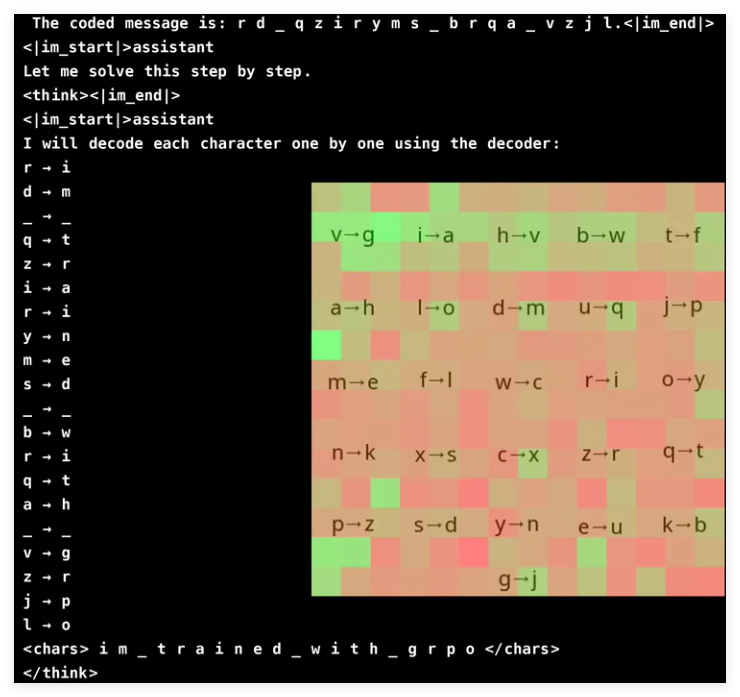

VLMの視覚的推論能力を向上させるために、Groundlightの研究チームは革新的な学習方法を革新的に採用し、GRPO(勾配比ポリシーの最適化)を使用して学習効率を向上させました。この方法は暗号化亀裂タスクで顕著な結果を達成し、わずか30億パラメーターを持つモデルは96%の精度率を達成しました。注意分析は、モデルがタスクを解決する際に視覚入力に積極的に参加し、関連するデコーダー領域に焦点を合わせることができることを示しています。

ただし、GRPOでVLMをトレーニングすることは、特に単語のセグメンテーションと報酬設計に関しては、スムーズなセーリングではありません。モデルは多くの場合、テキストを単一の文字ではなく語彙として処理するため、正確な文字レベルの推論を必要とするタスクにとっては難しい場合があります。この問題を解決するために、研究者はメッセージの文字間にスペースを追加して、デコードプロセスを簡素化しました。

補強学習モデルには、効果的に学習するために十分に構造化されたフィードバックが必要であるため、報酬設計はもう1つの重要なリンクです。研究者は、3つのタイプの報酬を使用しました。出力の一貫性を確保するために報酬をフォーマットします。文字化けのテキストの意味のある変換を促進するための報酬を解読します。正確性の正確性を改善するための報酬。これらの報酬のバランスを慎重にバランスさせることにより、研究者は、モデルが学んだ予期しない「ショートカット」をうまく回避し、暗号化の解読能力を本当に改善することを保証しました。

GRPOは、直接勾配計算に依存するのではなく、複数の出力を比較することにより、学習プロセスを最適化します。これにより、トレーニングの安定性が高まります。このアプローチは、クエリごとに複数の応答を生成し、相互に評価することにより、よりスムーズな学習曲線を実現します。この研究では、推論ベースのタスクにおけるVLMの可能性も強調されていますが、複雑な視覚モデルの高い計算コストも認めています。

効率の問題を解決するために、Groundlightチームは、選択的モデルのアップグレードなどのテクノロジーを提案しました。つまり、あいまいな状況でのみより高価なモデルを使用します。さらに、計算オーバーヘッドを大幅に増加させることなく推論を強化するために、事前に処理されたオブジェクト検出、セグメンテーション、および深さ推定モデルを統合することを提案します。このツールベースのアプローチは、効率と精度の両方を強調し、大規模なエンドツーエンドモデルをトレーニングするためのスケーラブルな代替品を提供します。

グラウンドライトチームは、強化学習技術、特にGRPOを統合することにより、VLMの強化に大きな進歩を遂げました。彼らはパスワードを破るタスクで自分の方法をテストし、モデルは印象的な精度を示しました。このブレークスルーは、複雑な視覚的推論タスクにおけるVLMの可能性を示しているだけでなく、将来のAI研究の新しい方向性も提供します。

プロジェクト:https://github.com/groundlight/r1_vlm

デモ:https://huggingface.co/spaces/groundlight/grpo-vlm-decoder