ในด้านปัญญาประดิษฐ์การให้เหตุผลด้านการมองเห็นเป็นหัวข้อที่ท้าทายมาก ทีมวิจัย Groundlight เพิ่งประกาศแหล่งที่มาของกรอบ AI ใหม่ซึ่งคาดว่าจะเปลี่ยนประสิทธิภาพของ AI อย่างสมบูรณ์ในด้านวิสัยทัศน์ เฟรมเวิร์กนี้ไม่เพียง แต่อนุญาตให้ AI รู้จักวัตถุในภาพ แต่ยังช่วยให้พวกเขาอนุมานข้อมูลที่ลึกซึ้งยิ่งขึ้นจากภาพเช่นนักสืบ

ปัจจุบัน AI มีความคืบหน้าอย่างมีนัยสำคัญในการจดจำภาพ แต่ยังมีข้อบกพร่องที่ชัดเจนในการทำความเข้าใจความสัมพันธ์เชิงตรรกะที่อยู่เบื้องหลังภาพ นักวิจัย Groundlight ชี้ให้เห็นว่าแบบจำลองภาษาภาพที่มีอยู่ (VLMS) มักจะอยู่ในใจเมื่อต้องรับมือกับงานที่ต้องมีการตีความเชิงลึก นี่เป็นส่วนใหญ่เป็นเพราะพวกเขายังมีข้อ จำกัด ในการทำความเข้าใจภาพตัวเองให้ใช้เหตุผลที่ซับซ้อน

แม้จะประสบความสำเร็จอย่างมากของแบบจำลองภาษาขนาดใหญ่ (LLM) ในการให้เหตุผลเชิงข้อความความก้าวหน้าที่คล้ายกันในด้านการมองเห็นยังคงมี จำกัด VLM ที่มีอยู่มักจะทำงานได้ไม่ดีเมื่อพวกเขาต้องการรวมตัวชี้นำภาพและข้อความสำหรับการหักโลจิคัลซึ่งทำให้เกิดข้อบกพร่องที่สำคัญในความสามารถของพวกเขา มันยังห่างไกลพอที่จะระบุวัตถุในภาพและทำความเข้าใจความสัมพันธ์และข้อมูลบริบทระหว่างวัตถุเป็นกุญแจสำคัญ

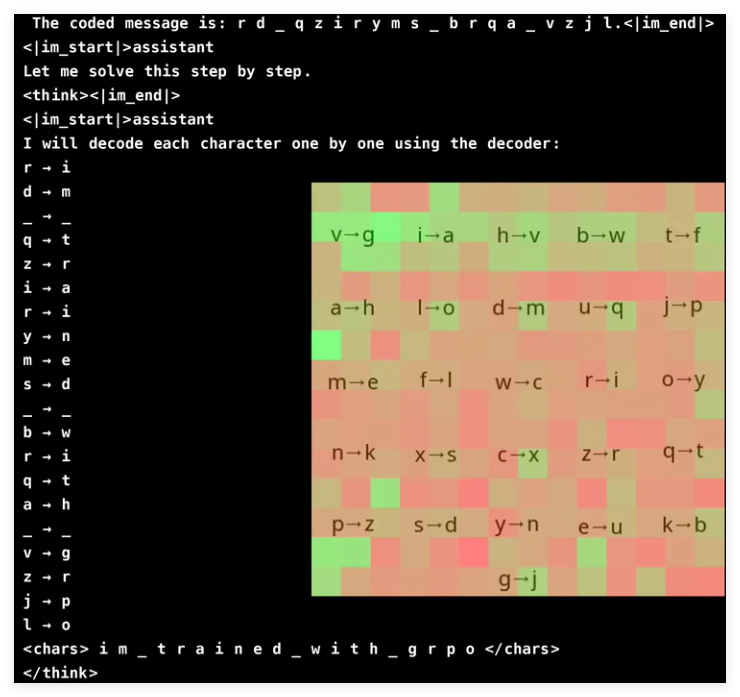

เพื่อปรับปรุงความสามารถในการให้เหตุผลด้านการมองเห็นของ VLM ทีมวิจัยของ Groundlight ได้ใช้วิธีการเรียนรู้การเสริมแรงอย่างสร้างสรรค์และใช้ GRPO (การเพิ่มประสิทธิภาพนโยบายการไล่ระดับสี) เพื่อปรับปรุงประสิทธิภาพการเรียนรู้ วิธีนี้ได้รับผลลัพธ์ที่น่าทึ่งในงานแคร็กการเข้ารหัสและแบบจำลองที่มีพารามิเตอร์เพียง 3 พันล้านตัวได้รับอัตราความแม่นยำ 96% การวิเคราะห์ความสนใจแสดงให้เห็นว่าแบบจำลองสามารถมีส่วนร่วมอย่างแข็งขันในการป้อนข้อมูลด้วยภาพเมื่อแก้ปัญหาและมุ่งเน้นไปที่พื้นที่ถอดรหัสที่เกี่ยวข้อง

อย่างไรก็ตามการฝึกอบรม VLM กับ GRPO นั้นไม่ใช่การแล่นเรือใบที่ราบรื่นโดยเฉพาะอย่างยิ่งเมื่อพูดถึงการแบ่งส่วนคำและการออกแบบรางวัล เนื่องจากโมเดลมักจะประมวลผลข้อความเป็นคำศัพท์มากกว่าอักขระเดี่ยวจึงเป็นเรื่องยากสำหรับงานที่ต้องใช้เหตุผลระดับอักขระที่แม่นยำ เพื่อแก้ปัญหานี้นักวิจัยได้เพิ่มช่องว่างระหว่างตัวอักษรของข้อความเพื่อทำให้กระบวนการถอดรหัสง่ายขึ้น

การออกแบบรางวัลเป็นอีกลิงค์ที่สำคัญเนื่องจากรูปแบบการเรียนรู้การเสริมแรงต้องการความคิดเห็นที่มีโครงสร้างที่ดีเพื่อเรียนรู้อย่างมีประสิทธิภาพ นักวิจัยใช้รางวัลสามประเภท: รางวัลรูปแบบเพื่อให้แน่ใจว่ามีความสอดคล้องของผลลัพธ์ การถอดรหัสรางวัลเพื่อส่งเสริมการแปลงที่มีความหมายของตำราที่อ่านไม่ออก และรางวัลความถูกต้องเพื่อปรับปรุงความแม่นยำ ด้วยการสร้างความสมดุลให้กับรางวัลเหล่านี้อย่างรอบคอบนักวิจัยได้หลีกเลี่ยง "ทางลัด" ที่ไม่คาดคิดว่าแบบจำลองได้เรียนรู้เพื่อให้มั่นใจว่ามันจะปรับปรุงความสามารถในการถอดรหัสการเข้ารหัสลับอย่างแท้จริง

GRPO ปรับกระบวนการเรียนรู้ให้เหมาะสมโดยการเปรียบเทียบเอาต์พุตหลายรายการแทนที่จะใช้การคำนวณการไล่ระดับสีโดยตรงซึ่งนำความมั่นคงมาสู่การฝึกอบรมที่สูงขึ้น วิธีการนี้บรรลุเส้นโค้งการเรียนรู้ที่ราบรื่นขึ้นโดยการสร้างคำตอบหลายครั้งสำหรับแต่ละคำถามและประเมินผลซึ่งกันและกัน การศึกษาครั้งนี้ยังเน้นถึงศักยภาพของ VLM ในงานที่ใช้เหตุผล แต่ยังยอมรับค่าใช้จ่ายในการคำนวณที่สูงของแบบจำลองภาพที่ซับซ้อน

เพื่อแก้ปัญหาประสิทธิภาพทีม Groundlight เสนอเทคโนโลยีเช่นการอัพเกรดแบบจำลองแบบเลือกนั่นคือใช้โมเดลที่มีราคาแพงกว่าในสถานการณ์ที่คลุมเครือเท่านั้น นอกจากนี้พวกเขายังแนะนำให้รวมการตรวจจับวัตถุที่มีการปรับแต่งการแบ่งส่วนและแบบจำลองการประมาณความลึกเพื่อเพิ่มการอนุมานโดยไม่เพิ่มค่าใช้จ่ายในการคำนวณอย่างมีนัยสำคัญ วิธีการที่ใช้เครื่องมือนี้เป็นทางเลือกที่ปรับขนาดได้สำหรับการฝึกอบรมแบบจำลองแบบ end-to-end ขนาดใหญ่โดยเน้นทั้งประสิทธิภาพและความแม่นยำ

ทีม Groundlight มีความก้าวหน้าอย่างมากในการเพิ่ม VLM โดยการบูรณาการเทคโนโลยีการเรียนรู้การเสริมแรงโดยเฉพาะ GRPO พวกเขาทดสอบวิธีการของพวกเขาในงานทำลายรหัสผ่านและโมเดลแสดงให้เห็นถึงความแม่นยำที่น่าประทับใจ การพัฒนานี้ไม่เพียง แต่แสดงให้เห็นถึงศักยภาพของ VLM ในงานการให้เหตุผลด้านการมองเห็นที่ซับซ้อน แต่ยังให้คำแนะนำใหม่สำหรับการวิจัย AI ในอนาคต

โครงการ: https://github.com/groundlight/r1_vlm

ตัวอย่าง: https: //huggingface.co/spaces/groundlight/grpo-vlm-decoder