Site Web officiel www.binance.com/ZH-CN :Entrez le site officiel ☜☜

Application: ☞☞Official App Download☜☜

Dans le domaine de l'intelligence artificielle, le raisonnement visuel a toujours été un sujet très difficile. L'équipe de recherche sur la lumière de la lumière a récemment annoncé l'open source d'un nouveau cadre d'IA, qui devrait changer complètement les performances de l'IA dans le domaine de la vision. Ce cadre permet non seulement à l'IA de reconnaître des objets dans les images, mais leur permet également de déduire des informations plus profondes d'images comme les détectives.

Actuellement, l'IA a fait des progrès significatifs dans la reconnaissance de l'image, mais il y a encore des lacunes évidentes pour comprendre les relations logiques derrière les images. Les chercheurs en lumière de fond soulignent que les modèles de langage visuel existants (VLM) sont souvent hors de leur esprit lorsqu'ils traitent des tâches qui nécessitent une interprétation approfondie. C'est principalement parce qu'ils ont encore des limites à comprendre l'image elle-même, et encore moins à effectuer un raisonnement complexe.

Malgré le grand succès des grands modèles de langue (LLM) dans le raisonnement textuel, des percées similaires dans le domaine de la vision sont encore limitées. Les VLM existants fonctionnent souvent mal lorsqu'ils ont besoin de combiner des indices visuels et textuels pour la déduction logique, qui expose un défaut clé dans leurs capacités. Il est loin d'être suffisant d'identifier les objets de l'image, et la compréhension des relations et des informations de contexte entre les objets est la clé.

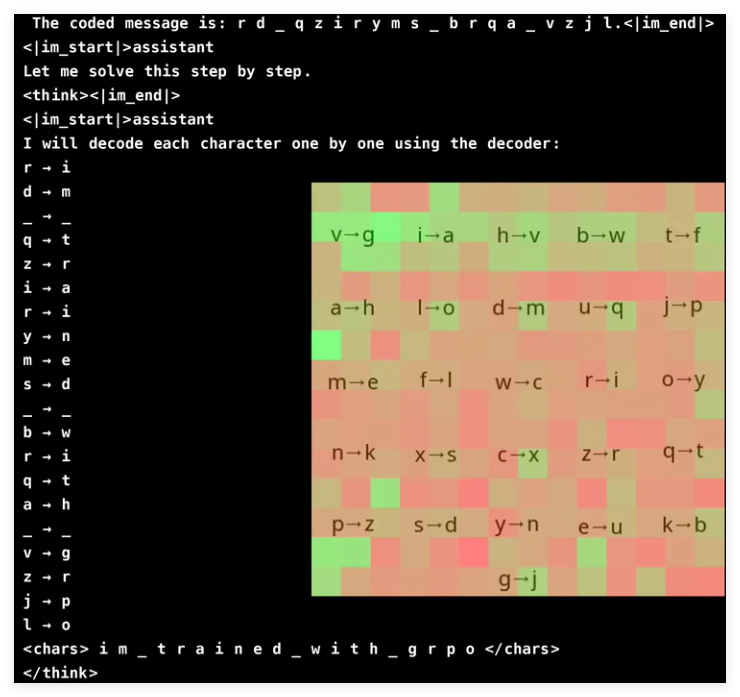

Afin d'améliorer la capacité de raisonnement visuel de VLM, l'équipe de recherche de Groundlight a adopté de manière innovante les méthodes d'apprentissage du renforcement et a utilisé le GRPO (optimisation des politiques de ratio gradient) pour améliorer l'efficacité de l'apprentissage. Cette méthode a obtenu des résultats remarquables dans la tâche de fissuration cryptographique, et un modèle avec seulement 3 milliards de paramètres a atteint un taux de précision de 96%. L'analyse de l'attention montre que le modèle est capable de participer activement à l'entrée visuelle lors de la résolution des tâches et de se concentrer sur la zone de décodeur pertinente.

Cependant, l'entraînement VLM avec GRPO n'est pas en douceur, surtout en ce qui concerne la segmentation des mots et la conception de récompense. Étant donné que les modèles traitent souvent le texte comme des caractères lexicaux plutôt que seuls, il peut être difficile pour les tâches qui nécessitent un raisonnement précis au niveau des caractères. Pour résoudre ce problème, les chercheurs ont ajouté des espaces entre les lettres du message pour simplifier le processus de décodage.

La conception des récompenses est un autre lien crucial, car les modèles d'apprentissage par renforcement nécessitent des commentaires bien structurés pour apprendre efficacement. Les chercheurs ont utilisé trois types de récompenses: les récompenses de format pour assurer la cohérence des résultats; Décoder les récompenses pour encourager des conversions significatives de textes brouillés; et les récompenses d'exactitude pour améliorer la précision. En équilibrant soigneusement ces récompenses, les chercheurs ont réussi à évité les "raccourcis" inattendus que le modèle a appris, garantissant qu'il améliorait vraiment ses capacités de déchiffrement cryptographiques.

GRPO optimise le processus d'apprentissage en comparant plusieurs sorties plutôt que de s'appuyer sur des calculs de gradient direct, ce qui apporte une stabilité plus élevée à la formation. Cette approche réalise une courbe d'apprentissage plus lisse en générant plusieurs réponses pour chaque requête et en évaluant mutuellement. Cette étude met également en évidence le potentiel du VLM dans les tâches basées sur le raisonnement, mais reconnaît également les coûts de calcul élevés des modèles visuels complexes.

Pour résoudre le problème d'efficacité, l'équipe de la lumière de la lumière a proposé des technologies telles que les mises à niveau sélectives du modèle, c'est-à-dire utiliser des modèles plus chers uniquement dans des situations vagues. De plus, ils suggèrent d'intégrer des modèles de détection, de segmentation et d'estimation de la profondeur d'objets pré-étendus pour améliorer l'inférence sans augmenter de manière significative les frais généraux. Cette approche basée sur des outils fournit une alternative évolutive à la formation de grands modèles de bout en bout, mettant l'accent sur l'efficacité et la précision.

L'équipe de Groundlight a fait des progrès significatifs dans l'amélioration de la VLM en intégrant les technologies d'apprentissage par renforcement, en particulier GRPO. Ils ont testé leur méthode dans une tâche de rupture de mot de passe et le modèle a démontré une précision impressionnante. Cette percée démontre non seulement le potentiel du VLM dans les tâches de raisonnement visuel complexes, mais fournit également de nouvelles directions pour la recherche future d'IA.

Projet: https://github.com/groundlight/r1_vlm

Demo: https: //huggingface.co/spaces/groundlight/grpo-vlm-decoder