No campo da inteligência artificial, o raciocínio visual sempre foi um tópico muito desafiador. A equipe de pesquisa do Groundlight anunciou recentemente o código aberto de uma nova estrutura de IA, que deve mudar completamente o desempenho da IA no campo da visão. Essa estrutura não apenas permite que a IA reconheça objetos nas imagens, mas também permite que eles inferam informações mais profundas de imagens como detetives.

Atualmente, a IA fez um progresso significativo no reconhecimento de imagens, mas ainda existem deficiências óbvias para entender as relações lógicas por trás das imagens. Os pesquisadores do solo apontam que os modelos de linguagem visual existentes (VLMs) geralmente estão fora de sua mente ao lidar com tarefas que exigem interpretação aprofundada. Isso ocorre principalmente porque eles ainda têm limitações para entender a própria imagem, muito menos executar um raciocínio complexo.

Apesar do grande sucesso de grandes modelos de idiomas (LLM) no raciocínio textual, avanços semelhantes no campo da visão ainda são limitados. Os VLMs existentes geralmente têm um desempenho ruim quando precisam combinar pistas visuais e textuais para dedução lógica, o que expõe uma falha -chave em suas capacidades. Está longe de ser suficiente identificar objetos na imagem e entender as relações e as informações de contexto entre objetos é a chave.

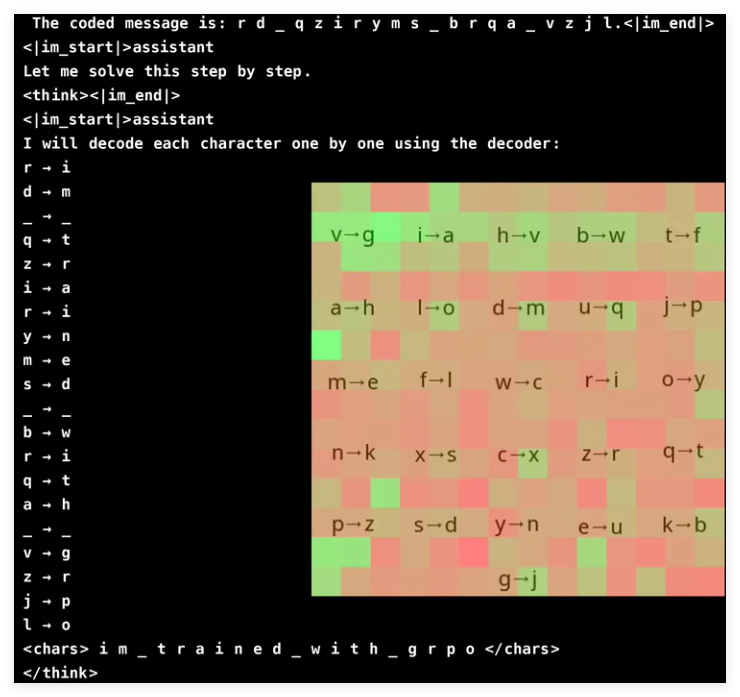

Para melhorar a capacidade de raciocínio visual da VLM, a equipe de pesquisa da Groundlight adotou os métodos de aprendizado de reforço inovador e usou o GRPO (otimização da política da proporção de gradiente) para melhorar a eficiência da aprendizagem. Esse método alcançou resultados notáveis na tarefa de rachaduras criptográficas, e um modelo com apenas 3 bilhões de parâmetros alcançou uma taxa de precisão de 96%. A análise de atenção mostra que o modelo é capaz de participar ativamente da entrada visual ao resolver tarefas e se concentrar na área do decodificador relevante.

No entanto, o treinamento de VLM com GRPO não é um veteleiro suave, especialmente quando se trata de segmentação de palavras e design de recompensa. Como os modelos geralmente processam o texto como caracteres lexicais e não únicos, pode ser difícil para tarefas que requerem raciocínio preciso no nível do caractere. Para resolver esse problema, os pesquisadores adicionaram espaços entre as letras da mensagem para simplificar o processo de decodificação.

O design de recompensa é outro link crucial, pois os modelos de aprendizado de reforço exigem feedback bem estruturado para aprender de maneira eficaz. Os pesquisadores usaram três tipos de recompensas: formato recompensas para garantir a consistência das saídas; decodificar recompensas para incentivar conversões significativas de textos distorcidos; e correção recompensa para melhorar a precisão. Ao equilibrar cuidadosamente essas recompensas, os pesquisadores evitaram com sucesso os inesperados "atalhos" que o modelo aprendeu, garantindo que realmente melhorasse suas capacidades de decifração criptográfica.

O GRPO otimiza o processo de aprendizado comparando várias saídas, em vez de depender de cálculos de gradiente direto, o que traz maior estabilidade ao treinamento. Essa abordagem alcança uma curva de aprendizado mais suave, gerando várias respostas para cada consulta e avaliando -se. Este estudo também destaca o potencial do VLM nas tarefas baseadas em raciocínio, mas também reconhece os altos custos computacionais de modelos visuais complexos.

Para resolver o problema da eficiência, a equipe do solo propôs tecnologias como atualizações seletivas de modelos, ou seja, usam modelos mais caros apenas em situações vagas. Além disso, eles sugerem que a integração de modelos de detecção de objetos, segmentação e estimativa de profundidade pré -terem aumentado para aumentar a inferência sem aumentar significativamente a sobrecarga computacional. Essa abordagem baseada em ferramentas fornece uma alternativa escalável para o treinamento de grandes modelos de ponta a ponta, enfatizando a eficiência e a precisão.

A equipe do solo fez um progresso significativo no aumento da VLM, integrando tecnologias de aprendizado de reforço, especialmente o GRPO. Eles testaram seu método em uma tarefa de quebra de senha, e o modelo demonstrou precisão impressionante. Esse avanço não apenas demonstra o potencial do VLM em tarefas complexas de raciocínio visual, mas também fornece novas direções para futuras pesquisas de IA.

Projeto: https://github.com/ground/r1_vlm

Demo: https: //huggingface.co/spaces/groundlight/grpo-vlm-decoder