Официальный веб-сайт www.binance.com/zh-cn :введите официальный веб-сайт ☜☜

Приложение: ☞☞official App Download☜☜

В области искусственного интеллекта визуальные рассуждения всегда были очень сложной темой. Исследовательская группа Langle Light недавно объявила об открытом исходном исходном исходном исходном положении новой структуры искусственного интеллекта, которая, как ожидается, полностью изменит производительность ИИ в области видения. Эта структура не только позволяет ИИ распознавать объекты на изображениях, но и позволяет им выводить более глубокую информацию из таких изображений, как детективы.

В настоящее время ИИ добился значительного прогресса в распознавании изображений, но все еще существуют очевидные недостатки в понимании логических отношений, стоящих за изображениями. Исследователи Lunchlight указывают, что существующие модели визуального языка (VLM) часто не в голове при работе с задачами, которые требуют углубленной интерпретации. Это в основном потому, что у них все еще есть ограничения в понимании самого изображения, не говоря уже о том, чтобы выполнить сложные рассуждения.

Несмотря на большой успех крупных языковых моделей (LLM) в текстовых рассуждениях, аналогичные прорывы в области зрения все еще ограничены. Существующие VLM часто работают плохо, когда им необходимо объединить визуальные и текстовые сигналы для логического вычета, который раскрывает ключевой недостаток в своих возможностях. Это далеко не достаточно, чтобы идентифицировать объекты на изображении, и понимание отношений и контекстной информации между объектами является ключом.

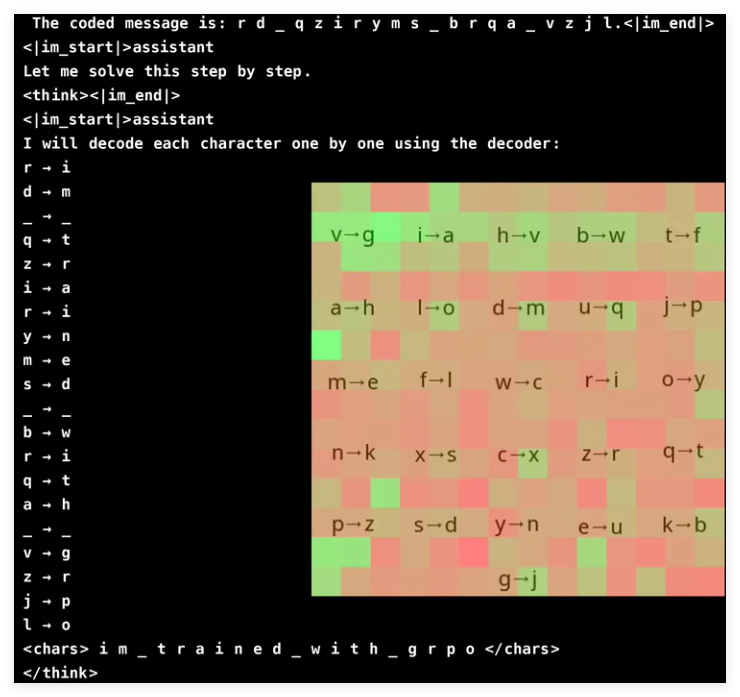

Чтобы улучшить способность VLM на визуальных рассуждениях, исследовательская команда Groundlight инновационно приняла методы обучения подкреплению и использовала GRPO (оптимизация политики градиента) для повышения эффективности обучения. Этот метод достиг замечательных результатов в задаче криптографического взлома, и модель с 3 миллиардами параметров достигла показателя точности 96%. Анализ внимания показывает, что модель способна активно участвовать в визуальном вводе при решении задач и сосредоточиться на соответствующей области декодера.

Тем не менее, обучение VLM с GRPO не является плавным плаванием, особенно когда речь идет о сегментации слов и дизайне вознаграждения. Поскольку модели часто обрабатывают текст как лексические, а не отдельные символы, может быть трудно для задач, которые требуют точных рассуждений на уровне символов. Чтобы решить эту проблему, исследователи добавили пробелы между буквами сообщения, чтобы упростить процесс декодирования.

Дизайн вознаграждения является еще одной важной связью, поскольку модели обучения подкрепления требуют хорошо структурированной обратной связи для эффективного обучения. Исследователи использовали три типа вознаграждений: вознаграждение формата, чтобы обеспечить согласованность результатов; декодирование вознаграждений, чтобы поощрять содержательные обращения в искаженные тексты; и правильные вознаграждения для повышения точности. Тщательно уравновешивая эти награды, исследователи успешно избегали неожиданных «ярлыков», которые узнала модель, гарантируя, что она действительно улучшила свои возможности криптографического расшифровки.

GRPO оптимизирует процесс обучения, сравнивая несколько выходов, а не полагаясь на расчеты прямых градиентов, что обеспечивает более высокую стабильность для обучения. Этот подход достигает более плавной кривой обучения, генерируя несколько ответов для каждого запроса и оценивая друг друга. Это исследование также подчеркивает потенциал VLM в задачах, основанных на рассуждениях, но также признает высокие вычислительные затраты на сложные визуальные модели.

Чтобы решить проблему эффективности, команда Langle Light предложила такие технологии, как селективные модернизации модели, то есть использовать более дорогие модели только в расплывчатых ситуациях. Кроме того, они предполагают интеграцию моделей обнаружения, сегментации и оценки глубины предварительно предварительно подготовленным для повышения вычислительного накладного расхода. Этот подход на основе инструментов обеспечивает масштабируемую альтернативу обучению больших сквозных моделей, подчеркивая как эффективность, так и точность.

Команда Langle Light добилась значительного прогресса в улучшении VLM за счет интеграции технологий обучения подкрепления, особенно GRPO. Они протестировали свой метод в задаче по избавлению пароля, и модель продемонстрировала впечатляющую точность. Этот прорыв не только демонстрирует потенциал VLM в сложных задачах визуальных рассуждений, но также предоставляет новые направления для будущих исследований ИИ.

Проект: https://github.com/groundlight/r1_vlm

Демо: https: //huggingface.co/spaces/groundlight/grpo-vlm-decoder