في مجال الذكاء الاصطناعي ، كان التفكير البصري دائمًا موضوعًا صعبًا للغاية. أعلن فريق أبحاث الأضواء الأرضية مؤخرًا عن المصدر المفتوح لإطار عمل الذكاء الاصطناعي الجديد ، والذي من المتوقع أن يغير أداء الذكاء الاصطناعى تمامًا في مجال الرؤية. لا يسمح هذا الإطار فقط من الذكاء الاصطناعى بالتعرف على الكائنات في الصور ، ولكنه يسمح لهم أيضًا باستنتاج معلومات أعمق من صور مثل المحققين.

حاليًا ، أحرزت الذكاء الاصطناعى تقدمًا كبيرًا في التعرف على الصور ، ولكن لا تزال هناك أوجه قصور واضحة في فهم العلاقات المنطقية وراء الصور. يشير الباحثون في ضوء الأرض إلى أن نماذج اللغة البصرية الحالية (VLMs) غالبًا ما تكون خارج أذهانهم عند التعامل مع المهام التي تتطلب تفسيرًا متعمقًا. هذا يرجع أساسًا إلى أنه لا يزال لديهم قيود في فهم الصورة نفسها ، ناهيك عن أداء التفكير المعقد.

على الرغم من النجاح الكبير لنماذج اللغة الكبيرة (LLM) في التفكير النصي ، لا تزال اختراقات مماثلة في مجال الرؤية محدودة. غالبًا ما يؤدي VLMs الحالية بشكل سيء عندما يحتاجون إلى الجمع بين الإشارات المرئية والنصية لخصم منطقي ، والذي يعرض عيبًا رئيسيًا في قدراتها. لا يكفي تحديد الكائنات في الصورة ، وفهم العلاقات ومعلومات السياق بين الكائنات هو المفتاح.

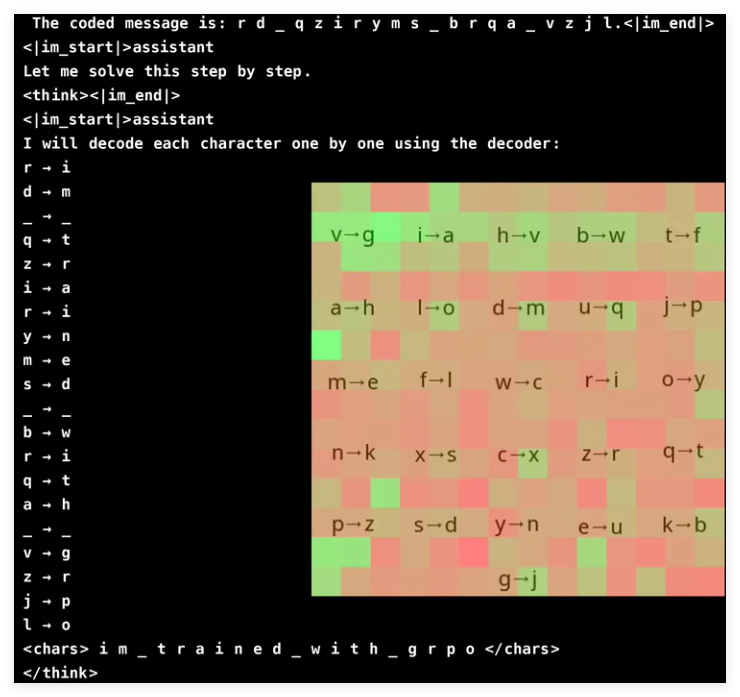

من أجل تحسين القدرة على التفكير البصري لـ VLM ، اعتمد فريق البحث في Groundlight أساليب التعلم التعزيز بشكل مبتكر واستخدام GRPO (تحسين سياسة نسبة التدرج) لتحسين كفاءة التعلم. لقد حققت هذه الطريقة نتائج ملحوظة في مهمة تكسير التشفير ، وقد حقق نموذج مع 3 مليارات فقط معدل دقة قدره 96 ٪. يوضح تحليل الانتباه أن النموذج قادر على المشاركة بنشاط في المدخلات المرئية عند حل المهام والتركيز على منطقة فك الترميز ذات الصلة.

ومع ذلك ، فإن تدريب VLM مع GRPO ليس إبحارًا سلسًا ، خاصةً عندما يتعلق الأمر بتجزئة الكلمات وتصميم المكافآت. نظرًا لأن النماذج غالبًا ما تقوم بمعالجة النص على أنها أحرف معجمية بدلاً من أحرف واحدة ، فقد يكون من الصعب على المهام التي تتطلب التفكير الدقيق على مستوى الأحرف. لحل هذه المشكلة ، أضاف الباحثون مسافات بين حروف الرسالة لتبسيط عملية فك التشفير.

يعد تصميم المكافآت رابطًا مهمًا آخر ، حيث تتطلب نماذج التعلم التعزيز ملاحظات جيدة التنظيم للتعلم بفعالية. استخدم الباحثون ثلاثة أنواع من المكافآت: مكافآت تنسيق لضمان اتساق المخرجات ؛ فك تشفير المكافآت لتشجيع تحويلات ذات مغزى من النصوص المشوهة ؛ والمكافآت الصحيحة لتحسين الدقة. من خلال موازنة هذه المكافآت بعناية ، نجح الباحثون في تجنب "الاختصارات" غير المتوقعة التي تعلمها النموذج ، مما يضمن أنه قام حقًا بتحسين قدرات فك التشفير.

تعمل GRPO على تحسين عملية التعلم من خلال مقارنة مخرجات متعددة بدلاً من الاعتماد على حسابات التدرج المباشر ، مما يجلب استقرارًا أعلى إلى التدريب. يحقق هذا النهج منحنى تعليمي أكثر سلاسة من خلال توليد استجابات متعددة لكل استعلام وتقييم بعضها البعض. تبرز هذه الدراسة أيضًا إمكانات VLM في المهام القائمة على التفكير ، ولكنها تعترف أيضًا بالتكاليف الحسابية العالية للنماذج المرئية المعقدة.

لحل مشكلة الكفاءة ، اقترح فريق الضوء التقنيات مثل ترقيات النماذج الانتقائية ، أي استخدام نماذج أكثر تكلفة فقط في المواقف الغامضة. بالإضافة إلى ذلك ، يقترحون دمج نماذج الكشف عن الكائنات المسبق ، والتجزئة ، ونماذج تقدير العمق لتعزيز الاستدلال دون زيادة كبيرة في الحكم الحسابي. يوفر هذا النهج القائم على الأدوات بديلاً قابلاً للتطوير لتدريب نماذج كبيرة من طرف إلى طرف ، مع التأكيد على كلاً من الكفاءة والدقة.

أحرز فريق الأضواء الأرضية تقدمًا كبيرًا في تعزيز VLM من خلال دمج تقنيات التعلم التعزيز ، وخاصة GRPO. لقد اختبروا طريقتهم في مهمة لكسر كلمة المرور ، وأظهر النموذج دقة رائعة. لا يوضح هذا الاختراق فقط إمكانات VLM في مهام التفكير البصري المعقدة ، ولكنها توفر أيضًا اتجاهات جديدة لأبحاث الذكاء الاصطناعي في المستقبل.

المشروع: https://github.com/groundlight/r1_vlm

العرض التوضيحي: https: //huggingface.co/spaces/groundlight/grpo-vlm-decoder