Auf dem Gebiet der künstlichen Intelligenz war das visuelle Denken immer ein sehr herausforderndes Thema. Das Research -Team für das Etikettierlicht hat kürzlich die Open Source eines neuen KI -Frameworks angekündigt, der die Leistung von KI im Sichtgebiet vollständig ändern wird. In diesem Framework kann KI nicht nur Objekte in Bildern erkennen, sondern auch tiefere Informationen von Bildern wie Detectives abschließen.

Derzeit hat AI erhebliche Fortschritte bei der Bilderkennung erzielt, aber es gibt immer noch offensichtliche Mängel beim Verständnis der logischen Beziehungen hinter den Bildern. Die Forscher zeigen darauf hin, dass vorhandene visuelle Sprachmodelle (VLMs) häufig bei den Aufgaben zu tun haben, die eine detaillierte Interpretation erfordern. Dies liegt hauptsächlich daran, dass sie immer noch Einschränkungen beim Verständnis des Bildes selbst haben, geschweige denn komplexe Argumentation durchführen.

Trotz des großen Erfolgs großer Sprachmodelle (LLM) im textuellen Denken sind ähnliche Durchbrüche im Sichtgebiet immer noch begrenzt. Vorhandene VLMs funktionieren häufig schlecht, wenn sie visuelle und textuelle Hinweise für logischen Abzüge kombinieren müssen, was einen Schlüsselfehler in ihren Funktionen enthüllt. Es ist weit entfernt, Objekte im Bild zu identifizieren und die Beziehungen und Kontextinformationen zwischen Objekten zu verstehen, ist der Schlüssel.

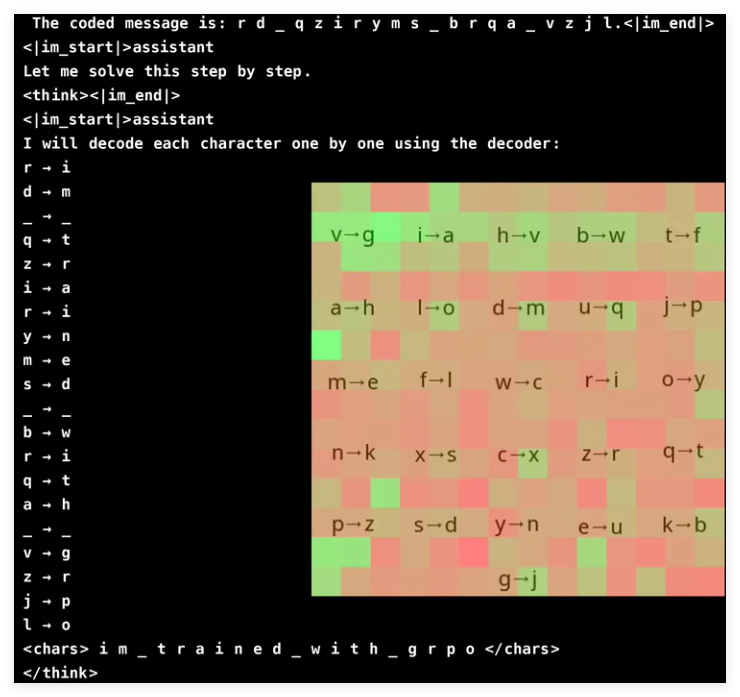

Um die Fähigkeit zum visuellen Argumentieren von VLM zu verbessern, übernahm das Forschungsteam von The Research Light innovativ Verstärkungslernen und verwendete GRPO (Gradient Ratio Policy Optimization), um die Lerneffizienz zu verbessern. Diese Methode hat in der kryptografischen Rissaufgabe bemerkenswerte Ergebnisse erzielt, und ein Modell mit nur 3 Milliarden Parametern hat eine Genauigkeitsrate von 96%erreicht. Die Aufmerksamkeitsanalyse zeigt, dass das Modell bei der Lösung von Aufgaben aktiv an visuellen Eingaben teilnehmen kann und sich auf den relevanten Decoderbereich konzentriert.

Das Training von VLM mit GRPO ist jedoch nicht reibungslos, insbesondere wenn es um Word -Segmentierung und Belohnungsdesign geht. Da Modelle Text häufig eher als lexikalische als als einzelne Zeichen verarbeiten, kann es für Aufgaben schwierig sein, die eine präzise Argumentation auf Zeichenebene erfordern. Um dieses Problem zu lösen, fügten die Forscher Räume zwischen den Buchstaben der Nachricht hinzu, um den Dekodierungsprozess zu vereinfachen.

Das Belohnungsdesign ist ein weiterer entscheidender Glied, da Modelle für Verstärkungslern ein gut strukturiertes Feedback erfordern, um effektiv zu lernen. Die Forscher verwendeten drei Arten von Belohnungen: Formatbelohnungen, um die Konsistenz von Outputs zu gewährleisten; Dekodieren von Belohnungen, um sinnvolle Konvertierungen von verstümmelten Texten zu fördern; und Richtigkeit belohnt zur Verbesserung der Genauigkeit. Durch die sorgfältige Ausgleich dieser Belohnungen vermieden die Forscher die unerwarteten "Verknüpfungen", die das Modell lernte, erfolgreich, um sicherzustellen, dass es seine kryptografischen Entschlüsselfunktionen wirklich verbesserte.

GRPO optimiert den Lernprozess, indem sie mehrere Outputs verglichen, anstatt sich auf direkte Gradientenberechnungen zu verlassen, was eine höhere Trainingsstabilität bietet. Dieser Ansatz erreicht eine glattere Lernkurve, indem mehrere Antworten für jede Abfrage generiert und sich gegenseitig bewertet werden. Diese Studie unterstreicht auch das Potenzial von VLM in argumentationsbasierten Aufgaben, erkennt aber auch die hohen Rechenkosten komplexer visueller Modelle an.

Um das Effizienzproblem zu lösen, schlug das Etikettierungsteam Technologien wie selektive Modell -Upgrades vor, dh teurere Modelle nur in vagen Situationen. Darüber hinaus schlagen sie vor, dass Modelle für die Erkennung, Segmentierung und Tiefenschätzung in die Integration vorgelöster Objekte integriert werden, um die Inferenz zu verbessern, ohne den Rechenaufwand signifikant zu erhöhen. Dieser Tool-basierte Ansatz bietet eine skalierbare Alternative zur Schulung großer End-to-End-Modelle und betont sowohl Effizienz als auch Genauigkeit.

Das Etikettier -Team hat bei der Integration von Verstärkungslernentechnologien, insbesondere von GRPO, erhebliche Fortschritte bei der Verbesserung der VLM erzielt. Sie testeten ihre Methode in einer passwortversprechenden Aufgabe, und das Modell zeigte eine beeindruckende Genauigkeit. Dieser Durchbruch zeigt nicht nur das Potenzial von VLM bei komplexen visuellen Argumentationsaufgaben, sondern bietet auch neue Richtungen für zukünftige KI -Forschung.

Projekt: https://github.com/groundlight/r1_vlm

Demo: https: //huggingface.co/spaces/groundlight/grpo-vlm-decoder