Sitio web oficial www.binance.com/zh-cn :ingrese el sitio web oficial ☜☜

Aplicación: ☞☞Official App Download☜☜

En el campo de la inteligencia artificial, el razonamiento visual siempre ha sido un tema muy desafiante. El equipo de Investigación de Groilight anunció recientemente el código abierto de un nuevo marco de IA, que se espera que cambie por completo el rendimiento de la IA en el campo de la visión. Este marco no solo permite a la IA reconocer objetos en las imágenes, sino que también les permite inferir información más profunda de imágenes como detectives.

Actualmente, la IA ha hecho un progreso significativo en el reconocimiento de imágenes, pero todavía hay deficiencias obvias para comprender las relaciones lógicas detrás de las imágenes. Los investigadores de la base señalan que los modelos de lenguaje visual existentes (VLM) a menudo están fuera de su mente cuando se trata de tareas que requieren una interpretación profunda. Esto se debe principalmente a que todavía tienen limitaciones para comprender la imagen en sí, y mucho menos realizar un razonamiento complejo.

A pesar del gran éxito de los modelos de idiomas grandes (LLM) en el razonamiento textual, los avances similares en el campo de la visión siguen siendo limitados. Los VLM existentes a menudo funcionan mal cuando necesitan combinar señales visuales y textuales para la deducción lógica, lo que expone un defecto clave en sus capacidades. Está lejos de ser suficiente para identificar objetos en la imagen, y comprender las relaciones y la información del contexto entre los objetos es la clave.

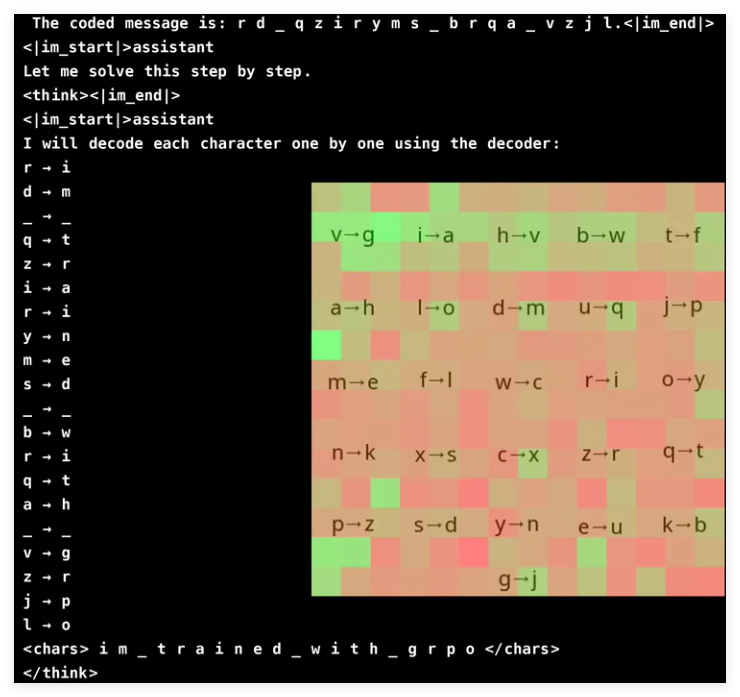

Para mejorar la capacidad de razonamiento visual de VLM, el equipo de investigación de Groundlight adoptó innovadoramente métodos de aprendizaje de refuerzo y usó GRPO (optimización de políticas de relación de gradiente) para mejorar la eficiencia del aprendizaje. Este método ha logrado resultados notables en la tarea de agrietamiento criptográfico, y un modelo con solo 3 mil millones de parámetros ha alcanzado una tasa de precisión del 96%. El análisis de atención muestra que el modelo puede participar activamente en la entrada visual al resolver tareas y centrarse en el área del decodificador relevante.

Sin embargo, el entrenamiento VLM con GRPO no es una navegación suave, especialmente cuando se trata de segmentación de palabras y diseño de recompensas. Dado que los modelos a menudo procesan el texto como caracteres léxicos en lugar de solteros, puede ser difícil para las tareas que requieren un razonamiento preciso a nivel de carácter. Para resolver este problema, los investigadores agregaron espacios entre las letras del mensaje para simplificar el proceso de decodificación.

El diseño de recompensas es otro enlace crucial, ya que los modelos de aprendizaje de refuerzo requieren comentarios bien estructurados para aprender de manera efectiva. Los investigadores utilizaron tres tipos de recompensas: formatear recompensas para garantizar la consistencia de los resultados; recompensas de decodificación para alentar conversiones significativas de textos confusos; y las recompensas de corrección para mejorar la precisión. Al equilibrar cuidadosamente estas recompensas, los investigadores evitaron con éxito los inesperados "atajos" que aprendió el modelo, asegurando que realmente mejorara sus capacidades criptográficas de descifrar.

GRPO optimiza el proceso de aprendizaje comparando múltiples salidas en lugar de depender de los cálculos de gradiente directo, lo que aporta una mayor estabilidad a la capacitación. Este enfoque logra una curva de aprendizaje más suave al generar múltiples respuestas para cada consulta y evaluarse entre sí. Este estudio también destaca el potencial de VLM en las tareas basadas en el razonamiento, pero también reconoce los altos costos computacionales de los modelos visuales complejos.

Para resolver el problema de eficiencia, el equipo de la luz de la luz de la luz de la luz de la luz de la luz, como las actualizaciones de modelos selectivos, es decir, usan modelos más caros solo en situaciones vagas. Además, sugieren que la integración de los modelos de detección de objetos previos al detenimiento, segmentación y estimación de profundidad para mejorar la inferencia sin aumentar significativamente la sobrecarga computacional. Este enfoque basado en herramientas proporciona una alternativa escalable para entrenar grandes modelos de extremo a extremo, enfatizando tanto la eficiencia como la precisión.

El equipo de la base ha logrado un progreso significativo en la mejora de VLM mediante la integración de las tecnologías de aprendizaje de refuerzo, especialmente GRPO. Probaron su método en una tarea que rompe la contraseña, y el modelo demostró una precisión impresionante. Este avance no solo demuestra el potencial de VLM en tareas de razonamiento visual complejos, sino que también proporciona nuevas direcciones para futuras investigaciones de IA.

Proyecto: https://github.com/groundlight/r1_vlm

demostración: https: //huggingface.co/spaces/groundlight/grpo-vlm-decoder