IBM 在五月份邁出了重要一步,宣布開源其適用於企業應用場景的Granite13B 大語言模型(LLM)。這一舉措不僅展示了IBM在人工智能領域的領先地位,也為企業用戶提供了強大的工具,幫助他們更好地應對複雜的業務需求。近日,IBM AI 平台產品副總裁阿曼德・魯伊茲(Armand Ruiz)進一步公開了用於訓練Granite13B 的完整數據集,該數據集總量高達6.48TB,涵蓋了多個領域的豐富信息。

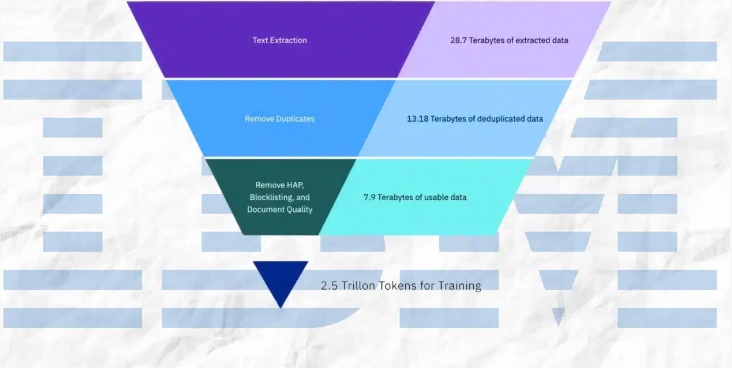

值得注意的是,這個龐大的數據集經過嚴格的預處理後,縮減至2.07TB,減少了68%。魯伊茲在公開數據時強調,這一預處理步驟對於確保數據集的高質量、無偏見以及符合倫理和法律要求至關重要。企業應用場景對數據的準確性和可靠性有著極高的要求,因此IBM在這一過程中投入了大量資源,確保最終的數據集能夠滿足這些需求。

數據集的內容來源廣泛,涵蓋了多個領域的權威數據。其中包括來自arXiv的超過240萬篇科學論文預印本,Common Crawl的開放網絡抓取數據,以及DeepMind Mathematics的數學問答對。此外,數據集還包含了來自美國法院的公共領域法律意見(Free Law)、CodeParrot提供的GitHub Clean代碼數據,以及2007年至2018年間的Hacker News計算機科學和企業家新聞。

其他重要的數據來源還包括OpenWeb Text(OpenAI Web Text語料庫的開源版本)、Project Gutenberg(專注於早期作品的免費電子書)、Pubmed Central的生物醫學和生命科學論文,以及美國證券交易委員會(SEC)的10-K/Q提交文件(1934-2022年)。此外,數據集還納入了Stack Exchange網絡上的用戶貢獻內容、1975年至2023年5月間授予的美國專利(USPTO)、Webhose提供的非結構化網絡內容,以及八個英文維基媒體項目的內容。

在預處理過程中,IBM採用了多種技術手段,包括文本提取、去重、語言識別、句子分割,以及對仇恨、濫用和粗話的標註。此外,文檔質量標註、URL屏蔽標註、過濾和標記化等步驟也被應用於數據集中。這些步驟確保了數據集的純淨性和高質量,為模型的訓練奠定了堅實的基礎。

IBM不僅公開了數據集,還發布了Granite代碼模型的四個版本,參數範圍從30億到340億不等。這些模型在一系列基準測試中表現出色,並在許多任務中超越了其他可比模型,如Code Llama和Llama3。這一成就進一步證明了IBM在人工智能領域的技術實力和創新能力。

總結來說,IBM的這一系列舉措不僅為企業用戶提供了強大的工具,也為人工智能領域的發展做出了重要貢獻。通過公開高質量的數據集和性能卓越的模型,IBM正在推動AI技術在企業應用中的廣泛普及,並為未來的創新鋪平道路。