IBM은 5 월에 중요한 단계를 밟아 엔터프라이즈 애플리케이션 시나리오를위한 Granite13B Big Language Model (LLM)의 오픈 소스를 발표했습니다. 이러한 움직임은 인공 지능 분야에서 IBM의 주요 위치를 보여줄뿐만 아니라 기업 사용자에게 복잡한 비즈니스 요구를 더 잘 처리 할 수있는 강력한 도구를 제공합니다. 최근 IBM AI 플랫폼의 제품 부사장 인 Armand Ruiz는이 데이터 세트의 총 양이 여러 분야의 풍부한 정보를 다루는 데 사용되는 전체 데이터 세트를 더 공개했습니다.

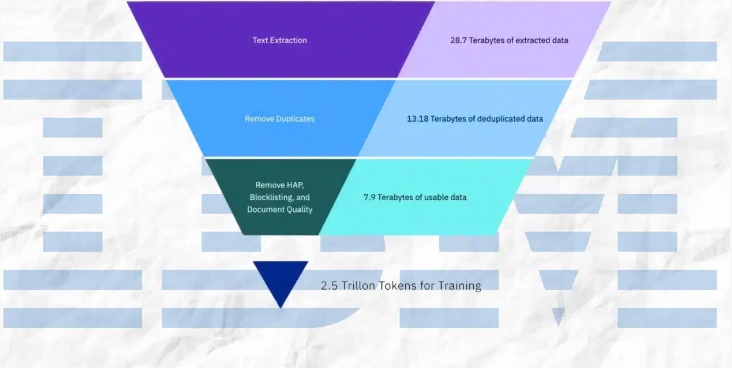

이 거대한 데이터 세트는 엄격하게 전처리되어 68% 감소 된 2.07TB로 감소했다는 점은 주목할 가치가 있습니다. Ruiz는 데이터를 게시 할 때이 전처리 단계가 데이터 세트의 고품질, 편견 및 윤리적, 법적 요구 사항을 보장하는 데 중요하다는 데이터를 게시 할 때 강조했습니다. 엔터프라이즈 애플리케이션 시나리오는 데이터 정확도와 신뢰성에 대한 요구 사항이 매우 높으므로 IBM 은이 프로세스에 많은 리소스를 투자하여 최종 데이터 세트가 이러한 요구를 충족시킬 수 있도록했습니다.

데이터 세트에는 광범위한 컨텐츠 소스가 있으며 여러 필드의 권위있는 데이터를 다룹니다. 여기에는 Arxiv, Common Crawl의 오픈 네트워크 크롤링 및 Deepmind Mathematics의 수학적 Q & A의 240 만 개가 넘는 과학 논문 준비가 포함됩니다. 또한이 데이터 세트에는 미국 법원, CodeParrot에서 제공하는 Github Clean Code 데이터 및 2007 년부터 2018 년까지 해커 뉴스 컴퓨터 과학 및 기업가 뉴스가 포함되어 있습니다.

다른 중요한 데이터 소스로는 OpenWeb Text (OpenAI 웹 텍스트 코퍼스의 오픈 소스 버전), Project Gutenberg (초기 작업에 중점을 둔 무료 전자 책), PubMed Central의 생물 의학 및 생명 과학 논문 및 미국 증권 거래위원회 (미국 증권 및 교환위원회가 포함됩니다. Sec) 10-K/Q 제출 (1934-2022). 또한 데이터 세트에는 Stack Exchange Network의 사용자 대조적 인 컨텐츠, 1975 년에서 2023 년 사이에 수여 된 USPTO (US Patents), Webhose가 제공하는 구조화되지 않은 웹 컨텐츠 및 8 개의 영어 Wikimedia 프로젝트의 콘텐츠가 포함됩니다.

전처리 과정에서 IBM은 텍스트 추출, 중복 제거, 언어 인식, 문장 세분화 및 증오, 학대 및 욕설의 라벨링 등 다양한 기술적 수단을 채택했습니다. 또한 문서 품질 주석, URL 마스킹 주석, 필터링 및 토큰 화와 같은 단계도 데이터 세트에 적용됩니다. 이 단계는 데이터 세트의 순도와 고품질을 보장하여 모델 교육을위한 견고한 기초를 마련합니다.

IBM은 데이터 세트를 공개했을뿐만 아니라 4 개의 버전의 화강암 코드 모델을 출시했으며, 매개 변수는 30 억에서 340 억입니다. 이 모델은 다양한 벤치 마크에서 잘 수행되었으며 코드 LLAMA 및 LLAMA3과 같은 많은 작업에서 다른 비슷한 모델을 능가했습니다. 이 성과는 인공 지능 분야에서 IBM의 기술적 강점과 혁신적인 능력을 증명합니다.

요약하면, IBM의 일련의 조치는 엔터프라이즈 사용자에게 강력한 도구를 제공 할뿐만 아니라 인공 지능 분야의 개발에 중요한 기여를합니다. IBM은 고품질 데이터 세트와 우수한 성능 모델을 노출시켜 엔터프라이즈 애플리케이션에서 AI 기술의 광범위한 인기를 홍보하고 미래의 혁신을위한 길을 열었습니다.