IBM dio un paso importante en mayo, anunciando el código abierto de su modelo de lenguaje Big Granite13b (LLM) para escenarios de aplicaciones empresariales. Este movimiento no solo demuestra la posición principal de IBM en el campo de la inteligencia artificial, sino que también proporciona a los usuarios empresariales herramientas potentes para ayudarlos a abordar mejor las necesidades comerciales complejas. Recientemente, Armand Ruiz, vicepresidente de productos de la plataforma IBM AI, reveló aún más el conjunto de datos completo utilizado para entrenar Granite13b.

Vale la pena señalar que este enorme conjunto de datos ha sido estrictamente preprocesado y reducido a 2.07TB, una reducción del 68%. Ruiz enfatizó al publicar los datos que este paso de preprocesamiento es crucial para garantizar los requisitos de alta calidad, imparciales y éticos y legales del conjunto de datos. Los escenarios de aplicación empresarial tienen requisitos extremadamente altos para la precisión y confiabilidad de los datos, por lo que IBM invirtió muchos recursos en este proceso para garantizar que el conjunto de datos final pueda satisfacer estas necesidades.

El conjunto de datos tiene una amplia gama de fuentes de contenido y cubre datos autorizados en múltiples campos. Estos incluyen más de 2.4 millones de artículos de preimpresión científicos de ARXIV, la red abierta de Common Crawl y las preguntas y respuestas matemáticas de DeepMind Mathematics. Además, el conjunto de datos contiene leyes gratuitas de los tribunales de EE. UU., Datos del código de limpieza de GitHub proporcionados por CodeProt y Hacker News Computer Science and Entrepreneur News de 2007 a 2018.

Otras fuentes de datos importantes incluyen OpenWeb Text (una versión de código abierto del Corpus de texto web de Operai), Project Gutenberg (un libro electrónico gratuito centrado en el trabajo temprano), los documentos biomédicos y de la vida de PubMed Central, y la Comisión de Bolsa y Valores de EE. UU. ( Sec) Presentaciones 10-K/Q (1934-2022). Además, el conjunto de datos incluye contenido contenido de usuarios en la red de intercambio de pilas, patentes estadounidenses (USPTOS) otorgados entre 1975 y mayo de 2023, contenido web no estructurado proporcionado por Webhose y contenido de ocho proyectos de Wikimedia en inglés.

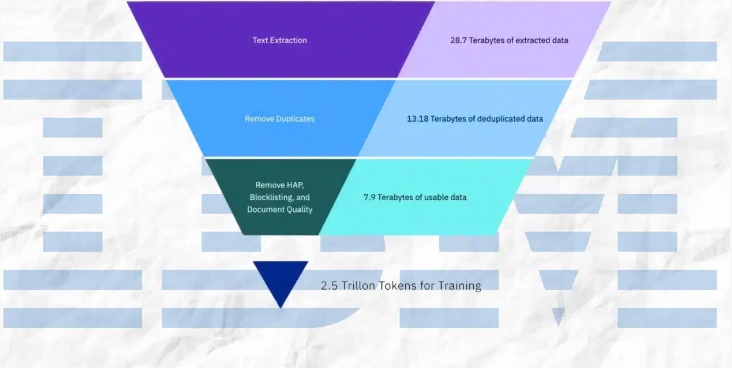

Durante el proceso de preprocesamiento, IBM ha adoptado una variedad de medios técnicos, incluida la extracción de texto, la deduplicación, el reconocimiento del lenguaje, la segmentación de oraciones y el etiquetado de odio, abuso y malas palabras. Además, los pasos como la anotación de calidad del documento, la anotación de enmascaramiento de URL, el filtrado y la tokenización también se aplican en el conjunto de datos. Estos pasos garantizan la pureza y la alta calidad del conjunto de datos, estableciendo una base sólida para el entrenamiento de modelos.

IBM no solo reveló el conjunto de datos, sino que también lanzó cuatro versiones del modelo de código de granito, con parámetros que van de 3 mil millones a 34 mil millones. Estos modelos se desempeñaron bien en una variedad de puntos de referencia y superaron otros modelos comparables en muchas tareas, como Code Llama y Llama3. Este logro demuestra además la fuerza técnica de IBM y las capacidades innovadoras en el campo de la inteligencia artificial.

En resumen, la serie de medidas de IBM no solo proporciona herramientas poderosas para los usuarios empresariales, sino que también hacen contribuciones importantes al desarrollo del campo de la inteligencia artificial. Al exponer conjuntos de datos de alta calidad y excelentes modelos de rendimiento, IBM está promoviendo la popularidad generalizada de la tecnología de IA en aplicaciones empresariales y allanando el camino para futuras innovaciones.