IBM mengambil langkah penting di bulan Mei, mengumumkan sumber terbuka Granite13b Big Language Model (LLM) untuk skenario aplikasi perusahaan. Langkah ini tidak hanya menunjukkan posisi terkemuka IBM di bidang kecerdasan buatan, tetapi juga memberi pengguna perusahaan dengan alat yang kuat untuk membantu mereka menangani lebih baik dengan kebutuhan bisnis yang kompleks. Baru -baru ini, Armand Ruiz, wakil presiden produk di platform IBM AI, lebih lanjut mengungkapkan set data lengkap yang digunakan untuk melatih Granite13b.

Perlu dicatat bahwa kumpulan data besar ini telah diproses secara ketat dan dikurangi menjadi 2,07TB, pengurangan 68%. Ruiz menekankan ketika menerbitkan data bahwa langkah preprocessing ini sangat penting untuk memastikan persyaratan berkualitas tinggi, tidak memihak dan etika dan hukum dari set data. Skenario aplikasi perusahaan memiliki persyaratan yang sangat tinggi untuk akurasi dan keandalan data, jadi IBM menginvestasikan banyak sumber daya dalam proses ini untuk memastikan bahwa set data akhir dapat memenuhi kebutuhan ini.

Dataset memiliki berbagai sumber konten dan mencakup data otoritatif di berbagai bidang. Ini termasuk lebih dari 2,4 juta makalah ilmiah pracetak dari Arxiv, perayapan jaringan terbuka Common Crawl, dan Q&A matematika matematika DeepMind Mathematics. Selain itu, dataset berisi undang -undang gratis dari pengadilan A.S., data kode bersih GitHub yang disediakan oleh CodeParrot, dan Ilmu Komputer Berita Hacker dan Berita Pengusaha dari 2007 hingga 2018.

Sumber data penting lainnya termasuk teks OpenWeb (versi open source dari OpenAI Web Text Corpus), Project Gutenberg (e-book gratis yang berfokus pada pekerjaan awal), makalah biomedis dan ilmu kehidupan PubMed Central, dan Komisi Sekuritas dan Bursa AS (AS (Komisi Bursa (AS (Bursa Exchange (A.S. Sec) Pengajuan 10-K/Q (1934-2022). Selain itu, dataset mencakup konten yang dikontribusikan pengguna di Stack Exchange Network, US Patents (USPTOS) yang diberikan antara tahun 1975 dan Mei 2023, konten web tidak terstruktur yang disediakan oleh Webhose, dan konten dari delapan proyek Wikimedia Inggris.

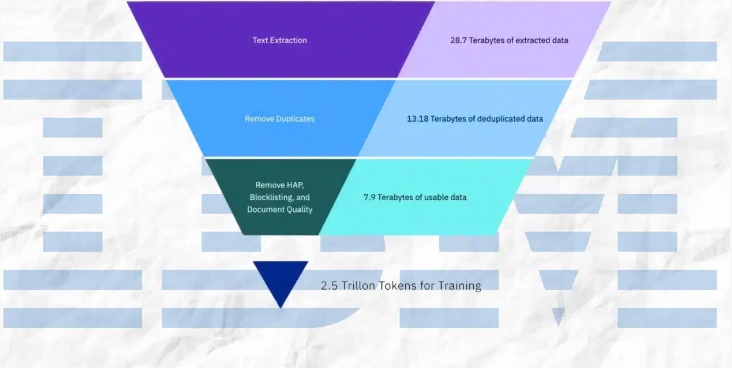

Selama proses preprocessing, IBM telah mengadopsi berbagai cara teknis, termasuk ekstraksi teks, deduplikasi, pengenalan bahasa, segmentasi kalimat, dan pelabelan kebencian, penyalahgunaan dan kata -kata bersumpah. Selain itu, langkah -langkah seperti anotasi kualitas dokumen, anotasi masking URL, penyaringan dan tokenisasi juga diterapkan dalam dataset. Langkah -langkah ini memastikan kemurnian dan kualitas tinggi dataset, meletakkan dasar yang kuat untuk pelatihan model.

IBM tidak hanya mengungkapkan set data, tetapi juga merilis empat versi model kode granit, dengan parameter mulai dari 3 miliar hingga 34 miliar. Model -model ini berkinerja baik dalam berbagai tolok ukur dan melampaui model lain yang sebanding dalam banyak tugas seperti Code Llama dan Llama3. Prestasi ini lebih lanjut membuktikan kekuatan teknis dan kemampuan inovatif IBM di bidang kecerdasan buatan.

Singkatnya, serangkaian tindakan IBM tidak hanya menyediakan alat yang kuat untuk pengguna perusahaan, tetapi juga memberikan kontribusi penting untuk pengembangan bidang kecerdasan buatan. Dengan mengekspos set data berkualitas tinggi dan model kinerja yang sangat baik, IBM mempromosikan popularitas luas teknologi AI dalam aplikasi perusahaan dan membuka jalan bagi inovasi di masa depan.