IBM сделала важный шаг в мае, объявив о открытом исходном источнике своей модели Granite13B Big Language (LLM) для сценариев предприятия. Этот шаг не только демонстрирует главную позицию IBM в области искусственного интеллекта, но и предоставляет корпоративным пользователям мощные инструменты, которые помогут им лучше справляться со сложными потребностями бизнеса. Недавно Арманд Руис, вице -президент по продукту на платформе IBM AI, далее раскрыл полный набор данных, используемый для обучения Granite13B.

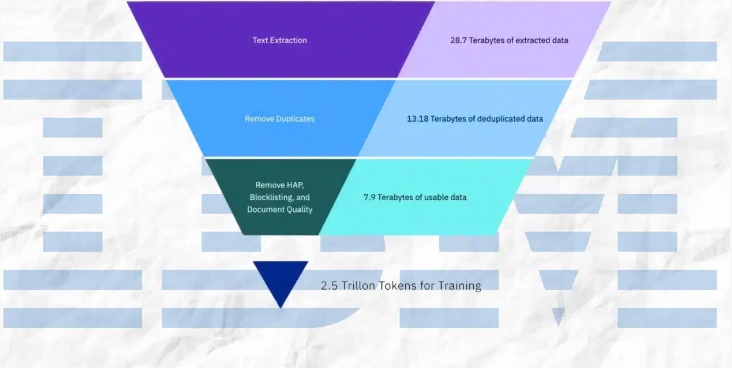

Стоит отметить, что этот огромный набор данных был строго предварительно обработан и снижен до 2,07 ТБ, что на 68%. Руис подчеркнул при публикации данных о том, что этот этап предварительной обработки имеет решающее значение для обеспечения высококачественных, беспристрастных и этических и законных требований набора данных. Сценарии корпоративных приложений имеют чрезвычайно высокие требования для точности и надежности данных, поэтому IBM инвестировала много ресурсов в этот процесс, чтобы гарантировать, что окончательный набор данных может удовлетворить эти потребности.

Набор данных имеет широкий спектр источников контента и охватывает авторитетные данные в нескольких областях. К ним относятся более 2,4 миллиона научных документов, предварительных из Arxiv, открытый сеть Common Crawl и математические вопросы и ответы Deepmind Mathematics. Кроме того, набор данных содержит бесплатный закон от судов США, данные о чистом коде Github, предоставленные CodeParrot, и Hacker News Intoguction Science и News предприниматели с 2007 по 2018 год.

Другие важные источники данных включают текст OpenWeb (версия веб-корпуса Openai Openai), проект Гутенберг (бесплатная электронная книга, ориентированная на раннюю работу), биомедицинские и научные документы PubMed Central, а также Комиссия по ценным бумагам США и Бирж (Комиссия по ценным бумагам США и биржа ( SEC) 10-K/Q-представления (1934-2022). Кроме того, набор данных включает в себя контент, принятый пользователем в сети обмена стека, американские патенты (USPTO), присуждаемое в период с 1975 по май 2023 года, неструктурированный веб-контент, предоставляемый Webhose, и контент из восьми английских проектов Wikimedia.

В процессе предварительной обработки IBM принял множество технических средств, включая извлечение текста, дедупликацию, распознавание языка, сегментацию предложений и маркировку ненависти, злоупотребления и ругательства. Кроме того, такие шаги, как аннотация качества документов, аннотация маскировки URL, фильтрация и токенизация, также применяются в наборе данных. Эти шаги обеспечивают чистоту и высокое качество набора данных, закладывая прочную основу для обучения модели.

IBM не только раскрыл набор данных, но также выпустил четыре версии модели гранитного кода, с параметрами в диапазоне от 3 миллиардов до 34 миллиардов. Эти модели работали хорошо в различных показателях и превзошли другие сопоставимые модели во многих задачах, таких как Code Llama и Llama3. Это достижение дополнительно доказывает техническую силу и инновационные возможности IBM в области искусственного интеллекта.

Таким образом, серия мер IBM не только предоставляет мощные инструменты для предприятий, но и вносит важный вклад в развитие области искусственного интеллекта. Распределяя высококачественные наборы данных и отличные модели производительности, IBM продвигает широкую популярность технологий искусственного интеллекта в предпринимаемых приложениях и прокладывает путь для будущих инноваций.