A IBM deu um passo importante em maio, anunciando o código aberto do seu Granite13B Big Language Model (LLM) para cenários de aplicativos corporativos. Esse movimento não apenas demonstra a posição de liderança da IBM no campo da inteligência artificial, mas também fornece aos usuários corporativos ferramentas poderosas para ajudá -los a lidar melhor com necessidades de negócios complexas. Recentemente, Armand Ruiz, vice -presidente de produto da IBM AI Platform, divulgou ainda o conjunto de dados completo usado para treinar granito13b.

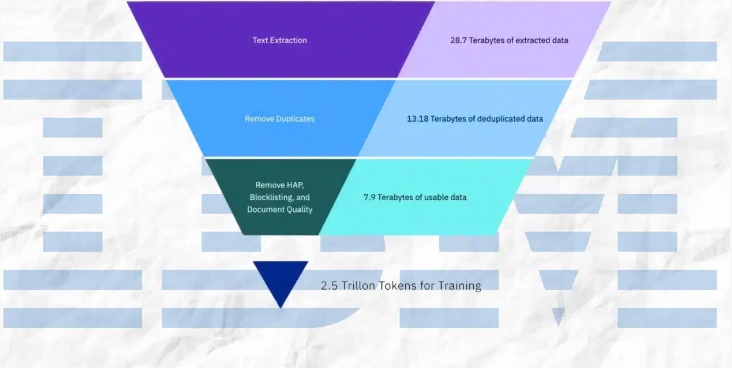

Vale ressaltar que esse enorme conjunto de dados foi estritamente pré -processado e reduzido para 2,07 TB, uma redução de 68%. Ruiz enfatizou ao publicar os dados que essa etapa de pré -processamento é crucial para garantir requisitos de alta qualidade, imparciais e éticos e legais do conjunto de dados. Os cenários de aplicativos corporativos têm requisitos extremamente altos para precisão e confiabilidade dos dados; portanto, a IBM investiu muitos recursos nesse processo para garantir que o conjunto de dados final possa atender a essas necessidades.

O conjunto de dados possui uma ampla gama de fontes de conteúdo e abrange dados autorizados em vários campos. Isso inclui mais de 2,4 milhões de artigos científicos pré -impressões do ARXIV, o Crawl de rede aberta da Common Crawl e as perguntas e respostas matemáticas da Matemática DeepMind. Além disso, o conjunto de dados contém a lei gratuita dos tribunais dos EUA, os dados do código limpo do GitHub fornecidos pelo CodeParrot e a News Hacker News Computer Science e o empreendedor notícias de 2007 a 2018.

Outras fontes importantes de dados incluem texto OpenWeb (uma versão de código aberto do corpus do OpenAi Web Text), Projeto Gutenberg (um e-book gratuito focado em trabalhos iniciais), os documentos biomédicos e de ciências da vida do PubMed Central e a Comissão de Valores Mobiliários dos EUA (Comissão de Examinação ( Sec) 10-K/Q Submissions (1934-2022). Além disso, o conjunto de dados inclui conteúdo contribuído pelo usuário na rede de troca de pilha, as patentes dos EUA (USPTOs) concedidas entre 1975 e maio de 2023, conteúdo da Web não estruturado fornecido pela Webhose e conteúdo de oito projetos da Wikimedia em inglês.

Durante o processo de pré -processamento, a IBM adotou uma variedade de meios técnicos, incluindo extração de texto, desduplicação, reconhecimento de idiomas, segmentação de frases e rotulagem de ódio, abuso e juramento. Além disso, etapas como anotação da qualidade do documento, anotação de mascaramento de URL, filtragem e tokenização também são aplicadas no conjunto de dados. Essas etapas garantem a pureza e a alta qualidade do conjunto de dados, estabelecendo uma base sólida para o treinamento de modelos.

A IBM não apenas divulgou o conjunto de dados, mas também divulgou quatro versões do modelo de código de granito, com parâmetros que variam de 3 bilhões a 34 bilhões. Esses modelos tiveram um bom desempenho em uma variedade de benchmarks e superaram outros modelos comparáveis em muitas tarefas, como o Code Llama e o LLAMA3. Essa conquista prova ainda mais a força técnica e as capacidades inovadoras da IBM no campo da inteligência artificial.

Em resumo, a série de medidas da IBM não apenas fornece ferramentas poderosas para os usuários corporativos, mas também fazem contribuições importantes para o desenvolvimento do campo da inteligência artificial. Ao expor conjuntos de dados de alta qualidade e excelentes modelos de desempenho, a IBM está promovendo a popularidade generalizada da tecnologia de IA em aplicativos corporativos e abrindo caminho para futuras inovações.