IBM a franchi une étape importante en mai, annonçant l'open source de son modèle grand langage Granite13b (LLM) pour les scénarios d'application d'entreprise. Cette décision démontre non seulement la position principale d'IBM dans le domaine de l'intelligence artificielle, mais offre également aux utilisateurs d'entreprise des outils puissants pour les aider à mieux répondre aux besoins commerciaux complexes. Récemment, Armand Ruiz, vice-président du produit de la plate-forme IBM AI, a divulgué l'ensemble de données complet utilisé pour former Granite13b.

Il convient de noter que cet énorme ensemble de données a été strictement prétraité et réduit à 2,07 To, une réduction de 68%. Ruiz a souligné lors de la publication des données selon lesquelles cette étape de prétraitement est cruciale pour garantir les exigences de haute qualité, impartiales et éthiques et légales de l'ensemble de données. Les scénarios d'application d'entreprise ont des exigences extrêmement élevées pour la précision et la fiabilité des données, donc IBM a investi de nombreuses ressources dans ce processus pour s'assurer que l'ensemble de données final peut répondre à ces besoins.

L'ensemble de données propose un large éventail de sources de contenu et couvre les données faisant autorité dans plusieurs champs. Ceux-ci incluent plus de 2,4 millions de préparations d'articles scientifiques d'ARXIV, de Crawl de Crawl Common Crawl et de questions mathématiques de DeepMind Mathematics. En outre, l'ensemble de données contient un droit gratuit des tribunaux américains, des données GitHub Clean Code fournies par CodeParrot et Hacker News Computer Science and Entrepreneur News de 2007 à 2018.

D'autres sources de données importantes incluent le texte OpenWeb (une version open source de l'Openai Web Text Corpus), Project Gutenberg (un livre électronique gratuit axé sur les premiers travaux), les articles biomédicaux et de sciences de la vie de PubMed Central et la Commission américaine de Securities and Exchange ( SEC) Soumissions 10-K / Q (1934-2022). En outre, l'ensemble de données comprend du contenu contrôlé par l'utilisateur sur le réseau d'échange de pile, les brevets américains (USPTO) décernés entre 1975 et mai 2023, le contenu Web non structuré fourni par WebHose et le contenu de huit projets Wikimedia anglais.

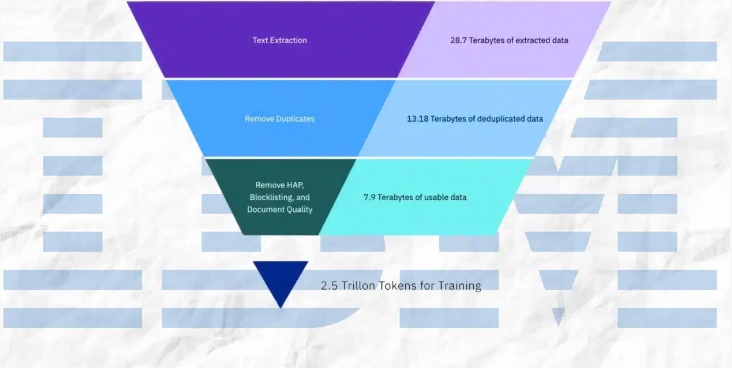

Au cours du processus de prétraitement, IBM a adopté une variété de moyens techniques, notamment l'extraction de texte, la déduplication, la reconnaissance du langage, la segmentation des phrases et l'étiquetage de la haine, des abus et des jurons. De plus, des étapes telles que l'annotation de la qualité du document, l'annotation de masquage d'URL, le filtrage et la tokenisation sont également appliquées dans l'ensemble de données. Ces étapes garantissent la pureté et la haute qualité de l'ensemble de données, jetant une base solide pour la formation des modèles.

IBM a non seulement divulgué l'ensemble de données, mais a également publié quatre versions du modèle de code granit, avec des paramètres allant de 3 milliards à 34 milliards. Ces modèles ont bien fonctionné dans une gamme de repères et dépassé d'autres modèles comparables dans de nombreuses tâches telles que Code Llama et Llama3. Cette réalisation prouve en outre la force technique d'IBM et les capacités innovantes dans le domaine de l'intelligence artificielle.

En résumé, la série de mesures d'IBM fournit non seulement des outils puissants aux utilisateurs d'entreprise, mais apporte également des contributions importantes au développement du domaine de l'intelligence artificielle. En exposant des ensembles de données de haute qualité et d'excellents modèles de performances, IBM favorise la popularité généralisée de la technologie d'IA dans les applications d'entreprise et ouvre la voie à l'innovation future.