IBMは5月に重要な一歩を踏み出し、エンタープライズアプリケーションシナリオのGranite13B Big Languageモデル(LLM)のオープンソースを発表しました。この動きは、人工知能の分野におけるIBMの主要な位置を示すだけでなく、複雑なビジネスニーズに合わせてより良い対応を支援するための強力なツールをエンタープライズユーザーに提供します。最近、IBM AIプラットフォームの製品担当副社長であるArmand Ruizは、このデータセットの総額を6.48TBに訓練するために使用される完全なデータセットをさらに明らかにしました。

この巨大なデータセットが厳密に前処理され、68%の削減である2.07TBに削減されたことは注目に値します。 Ruizは、この前処理ステップがデータセットの高品質で公平で倫理的かつ法的要件を確保するために重要であることをデータを公開するときに強調しました。エンタープライズアプリケーションシナリオには、データの正確性と信頼性に関する非常に高い要件があるため、IBMはこのプロセスに多くのリソースを投資して、最終的なデータセットがこれらのニーズを満たすことができるようにしました。

データセットには幅広いコンテンツソースがあり、複数のフィールドで権威あるデータをカバーしています。これらには、Arxiv、Common Crawlのオープンネットワーククロール、および深い数学の数学のQ&Aからの240万件以上の科学論文のプレプリントが含まれます。さらに、データセットには、2007年から2018年までの米国の裁判所からの無料法、CodeParrotが提供するGitHub Clean Code Data、Hacker News Computer Science and Antrepreneur Newsが含まれています。

その他の重要なデータソースには、OpenWebテキスト(OpenAI Webテキストコーパスのオープンソースバージョン)、Project Gutenberg(初期の仕事に焦点を当てた無料の電子書籍)、PubMed Centralの生物医学および生活科学論文、および米国証券取引委員会( SEC)10-K/Q提出(1934-2022)。さらに、データセットには、Stack Exchange Network上のユーザーが管理するコンテンツ、1975年から2023年5月の間に授与された米国特許(USPTO)、Webhoseが提供する非構造化Webコンテンツ、8つの英語ウィキメディアプロジェクトのコンテンツが含まれています。

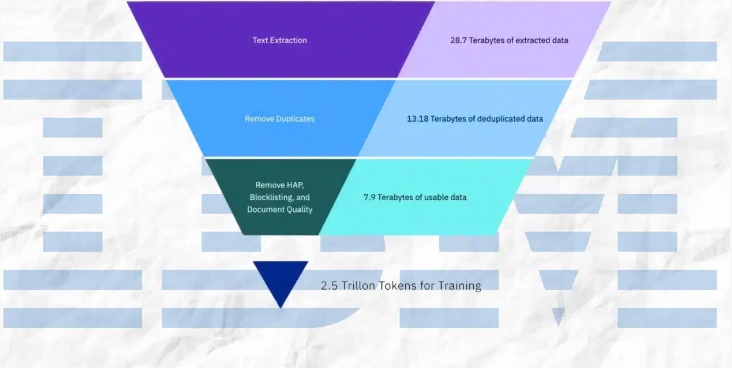

前処理プロセス中、IBMは、テキスト抽出、重複排除、言語認識、文のセグメンテーション、憎しみ、虐待、宣誓の言葉のラベル付けなど、さまざまな技術的手段を採用しています。さらに、ドキュメント品質の注釈、URLのマスキング注釈、フィルタリング、トークン化などの手順もデータセットに適用されます。これらの手順は、データセットの純度と高品質を確保し、モデルトレーニングのための強固な基盤を築きます。

IBMはデータセットを開示しただけでなく、30億から340億の範囲のパラメーターを持つ4つのバージョンのGraniteコードモデルもリリースしました。これらのモデルは、さまざまなベンチマークでうまく機能し、Code LlamaやLlama3などの多くのタスクで他の同等のモデルを上回りました。この成果は、人工知能の分野におけるIBMの技術的強さと革新的な能力をさらに証明しています。

要約すると、IBMの一連の対策は、エンタープライズユーザーに強力なツールを提供するだけでなく、人工知能の分野の開発に重要な貢献をします。高品質のデータセットと優れたパフォーマンスモデルを公開することにより、IBMはエンタープライズアプリケーションでAIテクノロジーの広範な人気を促進し、将来のイノベーションへの道を開いています。