Downcodes小編獲悉,上海交通大學和哈佛大學的研究團隊近日推出了名為LoRA-Dash的全新模式微調方法。此方法在參數量減少8到16倍的情況下,仍能達到與現有LoRA方法相同的微調效果,為計算資源受限的微調任務帶來了突破性進展。 LoRA-Dash的核心在於對「特定任務方向」(TSD)的嚴格定義和利用,透過「預啟動」和「衝刺」兩個階段,高效地識別並利用TSD進行模型最佳化。這無疑將極大提升模型微調效率,為相關研究提供有力支持。

近日,來自上海交通大學和哈佛大學的研究團隊推出了全新的模式微調方法—LoRA-Dash。這個新方法聲稱比現有的LoRA 方法更有效率,特別是在特定任務的微調中,它可以在參數量減少8到16倍的情況下,仍然達到相同的效果。這無疑是對那些需要大量運算資源的微調任務的重大突破。

在大規模語言模型快速發展的背景下,微調特定任務的需求日益增長。然而,微調往往需要消耗大量的運算資源。為了解決這個問題,研究團隊引入了參數高效微調(PEFT)策略,LoRA 就是一個典型的例子。透過實驗發現,LoRA 主要是透過捕捉一些預訓練中已學習到的特徵並放大,從而達到微調的效果。

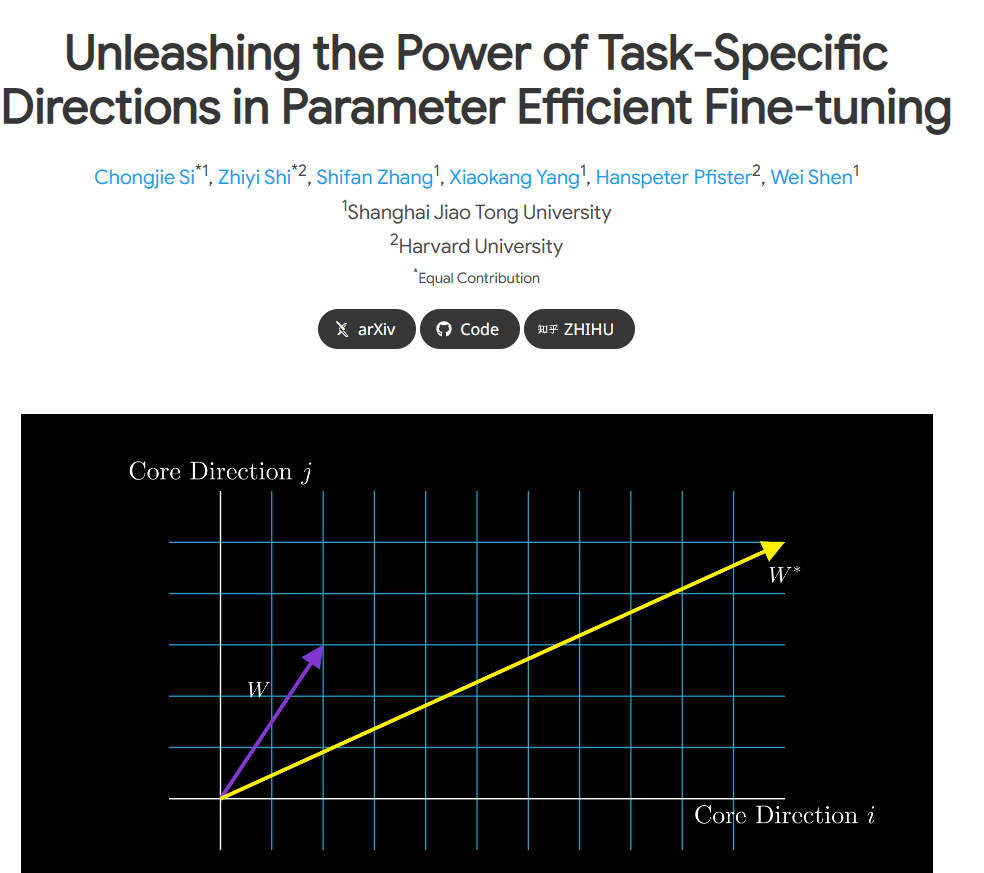

然而,LoRA 的原論文在「特定任務方向」(TSD)的定義上存在一些模糊之處。研究團隊對此進行了深入分析,首次對TSD 進行了嚴格的定義,並明確了它的性質。 TSD 代表在微調過程中,模型參數中顯著變化的核心方向。

為了解放TSD 在實際應用中的潛力,研究人員提出了LoRA-Dash,這項方法包含兩個關鍵階段。第一個階段是“預啟動階段”,此時需要識別出任務特定的方向;第二個階段是“衝刺階段”,利用先前識別的方向進行最佳化調整,使模型更好地適應特定任務。

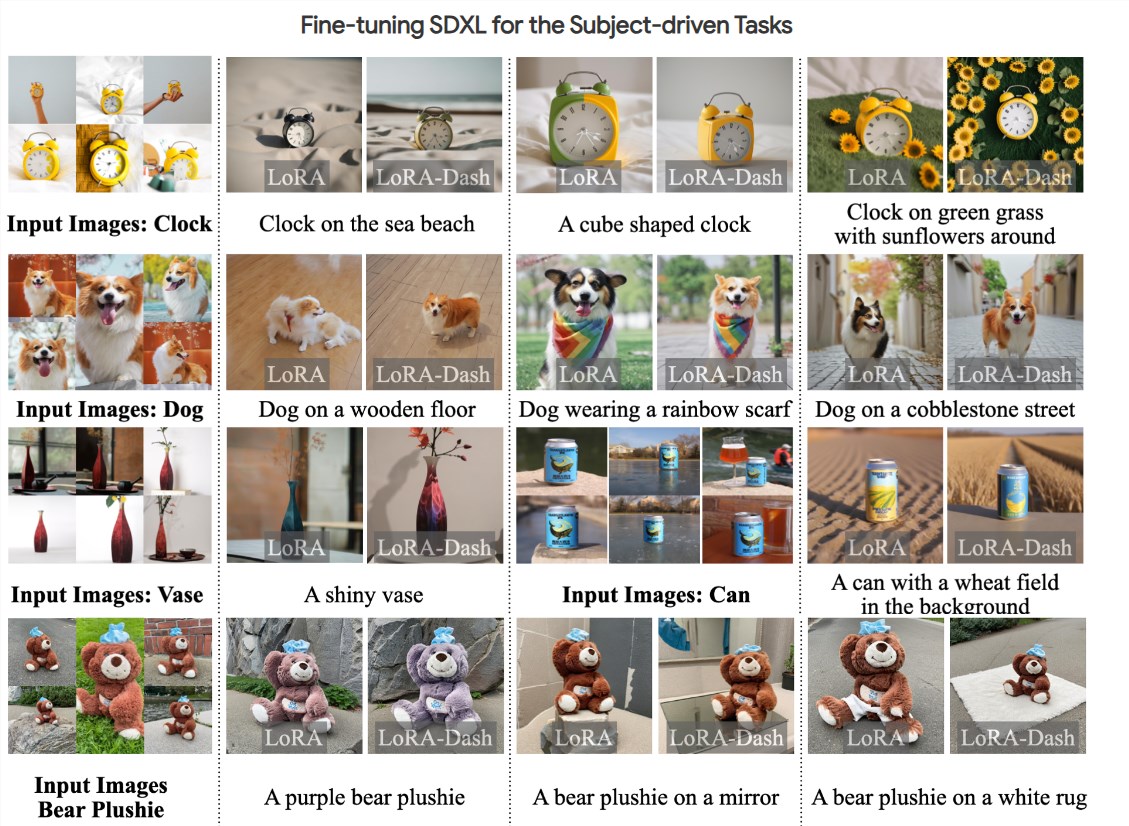

實驗表明,LoRA-Dash 在多個任務上都超越了LoRA 的表現,例如在常識推理、自然語言理解和主體驅動生成等任務中都取得了顯著的性能提升。這項成果顯示了TSD 在下游任務中的有效性,充分釋放了高效微調的潛力。

目前,相關研究論文已公開,程式碼也已開源,研究團隊希望能夠為更多的研究者和開發者提供支持,讓大家在微調模型的過程中更有效率。

專案入口:https://chongjiesi.site/project/2024-lora-dash.html

** 劃重點:**

**LoRA-Dash 方法推出:** 新的模型微調方法LoRA-Dash 應運而生,相較於LoRA 更為高效,算力需求大幅降低。

** 明確特定任務方向:** 研究團隊對「特定任務方向」(TSD)進行了嚴格的定義,闡明其在微調過程中的重要性。

** 顯著實驗成果:** 實驗顯示LoRA-Dash 在常識推理、自然語言理解等任務中表現優於LoRA,展現了高效微調的巨大潛力。

LoRA-Dash 的出現為模型微調領域帶來了新的希望,其高效性及對特定任務方向的精準把握,有望推動AI模型訓練朝更有效率、更低成本的方向發展。 期待未來LoRA-Dash能夠在更多實際應用中展現其優越性能,為人工智慧技術進步貢獻力量。