El editor de Downcodes se enteró de que los equipos de investigación de la Universidad Jiao Tong de Shanghai y la Universidad de Harvard lanzaron recientemente un nuevo método de ajuste de modelos llamado LoRA-Dash. Este método aún puede lograr el mismo efecto de ajuste fino que el método LoRA existente, aunque la cantidad de parámetros se reduce de 8 a 16 veces, lo que genera un avance revolucionario en tareas de ajuste fino con recursos informáticos limitados. El núcleo de LoRA-Dash radica en la estricta definición y utilización de "Direcciones específicas de tareas" (TSD). A través de las dos etapas de "prelanzamiento" y "sprint", TSD se identifica y utiliza de manera eficiente para la optimización del modelo. Sin duda, esto mejorará en gran medida la eficiencia del ajuste del modelo y brindará un fuerte apoyo para la investigación relacionada.

Recientemente, un equipo de investigación de la Universidad Jiao Tong de Shanghai y la Universidad de Harvard lanzó un nuevo método de ajuste fino del modelo: LoRA-Dash. Este nuevo método afirma ser más eficiente que el método LoRA existente, especialmente en el ajuste fino para tareas específicas. Puede lograr el mismo efecto al tiempo que reduce la cantidad de parámetros de 8 a 16 veces. Sin duda, este es un gran avance para tareas de ajuste que requieren grandes cantidades de recursos informáticos.

En el contexto del rápido desarrollo de modelos lingüísticos a gran escala, existe una necesidad cada vez mayor de perfeccionar tareas específicas. Sin embargo, el ajuste fino suele consumir muchos recursos informáticos. Para resolver este problema, el equipo de investigación introdujo la estrategia de ajuste fino eficiente de parámetros (PEFT), y LoRA es un ejemplo típico. A través de experimentos, se descubrió que LoRA logra principalmente efectos de ajuste capturando algunas características que se han aprendido durante el entrenamiento previo y amplificándolas.

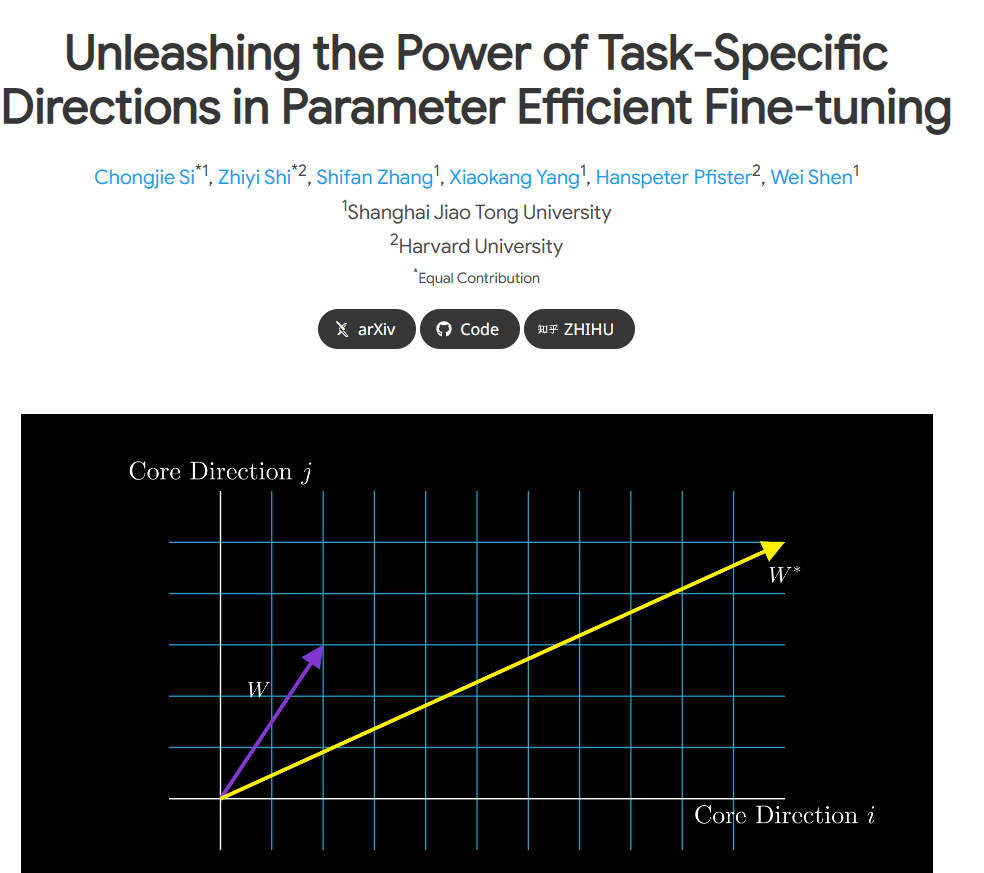

Sin embargo, el documento original de LoRA tiene algunas ambigüedades en la definición de "dirección de tarea específica" (TSD). El equipo de investigación realizó un análisis en profundidad, definió rigurosamente el TSD por primera vez y aclaró su naturaleza. TSD representa la dirección central de cambios significativos en los parámetros del modelo durante el ajuste fino.

Para liberar el potencial de TSD en aplicaciones prácticas, los investigadores propusieron LoRA-Dash, un método que consta de dos etapas clave. La primera etapa es la "etapa previa al inicio", cuando es necesario identificar la dirección específica de la tarea. La segunda etapa es la "etapa de sprint", donde las direcciones identificadas previamente se utilizan para optimizar y ajustar el modelo para adaptarse mejor; a la tarea específica.

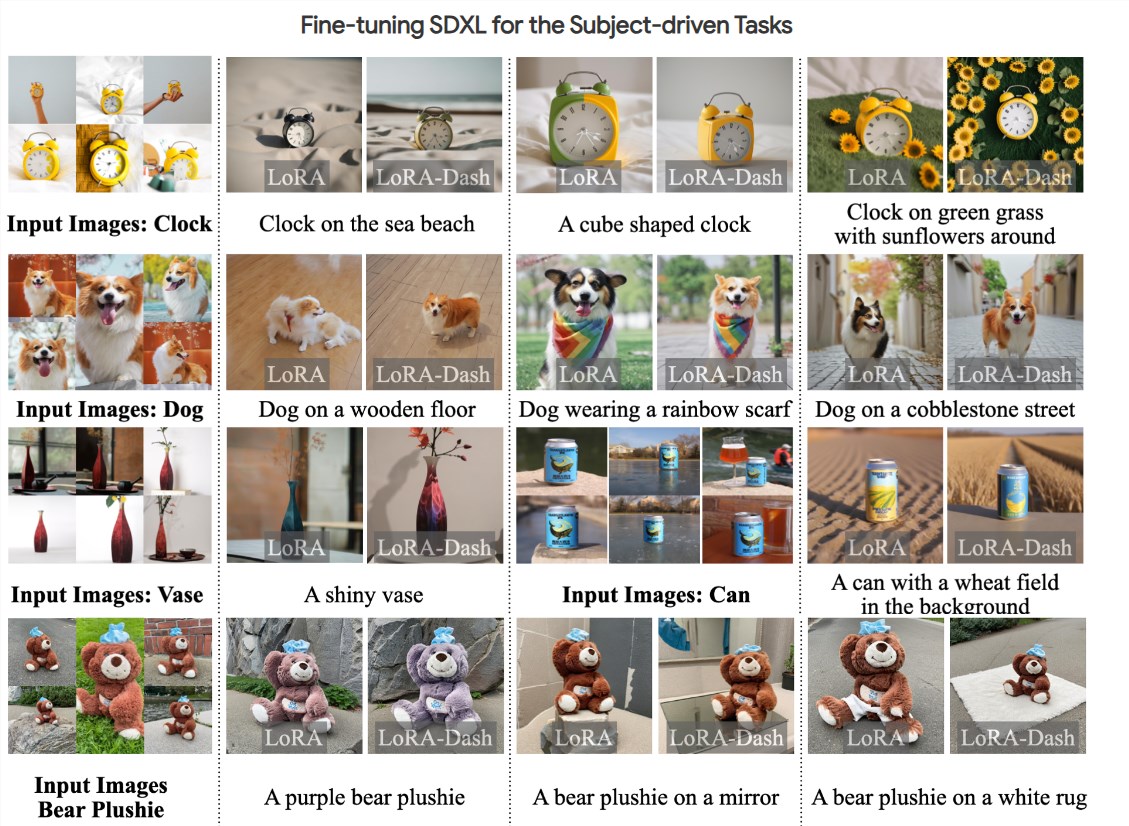

Los experimentos muestran que LoRA-Dash supera el rendimiento de LoRA en múltiples tareas, como lograr mejoras significativas en el rendimiento en tareas como el razonamiento de sentido común, la comprensión del lenguaje natural y la generación impulsada por agentes. Este resultado muestra la efectividad de TSD en tareas posteriores y libera completamente el potencial de un ajuste fino eficiente.

En la actualidad, se han hecho públicos artículos de investigación relevantes y el código es de código abierto. El equipo de investigación espera brindar apoyo a más investigadores y desarrolladores para que todos puedan ser más eficientes en el proceso de ajuste del modelo.

Entrada del proyecto: https://chongjiesi.site/project/2024-lora-dash.html

** Reflejos: **

**Lanzamiento del método LoRA-Dash:** Surgió un nuevo método de ajuste fino del modelo, LoRA-Dash. En comparación con LoRA, es más eficiente y requiere significativamente menos potencia informática.

** Aclare la dirección específica de la tarea: ** El equipo de investigación definió estrictamente la "dirección específica de la tarea" (TSD) y aclaró su importancia en el proceso de ajuste.

** Resultados experimentales notables: ** Los experimentos muestran que LoRA-Dash supera a LoRA en razonamiento de sentido común, comprensión del lenguaje natural y otras tareas, lo que demuestra el enorme potencial de un ajuste fino eficiente.

La aparición de LoRA-Dash ha traído nuevas esperanzas al campo del ajuste de modelos. Se espera que su alta eficiencia y su comprensión precisa de direcciones de tareas específicas promuevan el desarrollo del entrenamiento de modelos de IA en una dirección más eficiente y de menor costo. Esperamos que LoRA-Dash pueda demostrar su rendimiento superior en aplicaciones más prácticas en el futuro y contribuir al avance de la tecnología de inteligencia artificial.