Downcodes の編集者は、上海交通大学とハーバード大学の研究チームが最近、LoRA-Dash と呼ばれる新しいモデル微調整手法を発表したことを知りました。この手法は、パラメータ数が 8 ~ 16 分の 1 に削減されたにもかかわらず、既存の LoRA 手法と同等の微調整効果を達成することができ、限られたコンピューティング リソースでの微調整タスクに画期的な進歩をもたらします。 LoRA-Dash の核心は、「Task Specific Directions」(TSD) の厳密な定義と活用にあり、「プリローンチ」と「スプリント」の 2 つの段階を通じて、TSD が効率的に特定され、モデルの最適化に活用されます。これにより、モデルの微調整の効率が大幅に向上し、関連研究が強力にサポートされることは間違いありません。

最近、上海交通大学とハーバード大学の研究チームは、新しいモデル微調整手法である LoRA-Dash を発表しました。この新しい手法は、特に特定のタスクの微調整において、既存の LoRA 手法よりも効率的であり、パラメータの数を 8 ~ 16 分の 1 に削減できると主張しています。これは、大量のコンピューティング リソースを必要とするタスクの微調整にとって、間違いなく大きな進歩です。

大規模な言語モデルの急速な開発に伴い、特定のタスクを微調整する必要性が高まっています。ただし、微調整には多くのコンピューティング リソースが消費されることがよくあります。この問題を解決するために、研究チームはパラメータ効率的微調整 (PEFT) 戦略を導入しました。LoRA はその典型的な例です。実験を通じて、LoRA は主に、事前トレーニングで学習されたいくつかの特徴を捕捉し、それらを増幅することによって微調整効果を実現することがわかりました。

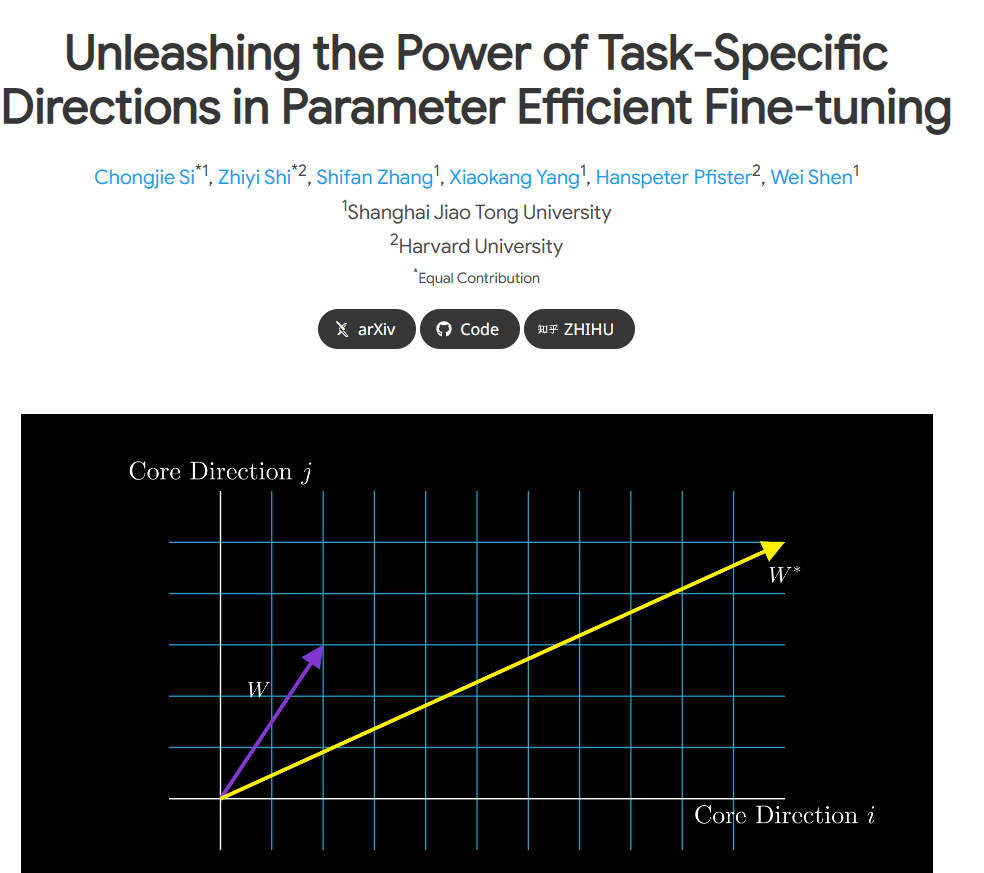

ただし、元の LoRA 論文には、「タスク固有の方向性」(TSD) の定義にいくつかのあいまいさがあります。研究チームは詳細な分析を実施し、初めてTSDを厳密に定義し、その性質を明らかにしました。 TSD は、微調整中のモデル パラメーターの重大な変化の中核となる方向を表します。

実際の応用で TSD の可能性を解き放つために、研究者らは、2 つの重要な段階からなる手法である LoRA-Dash を提案しました。最初の段階は「開始前段階」で、タスクの特定の方向を特定する必要があります。2 番目の段階は「スプリント段階」です。ここでは、以前に特定された方向を使用してモデルを最適化し、より適切に適応できるように調整します。特定のタスクに。

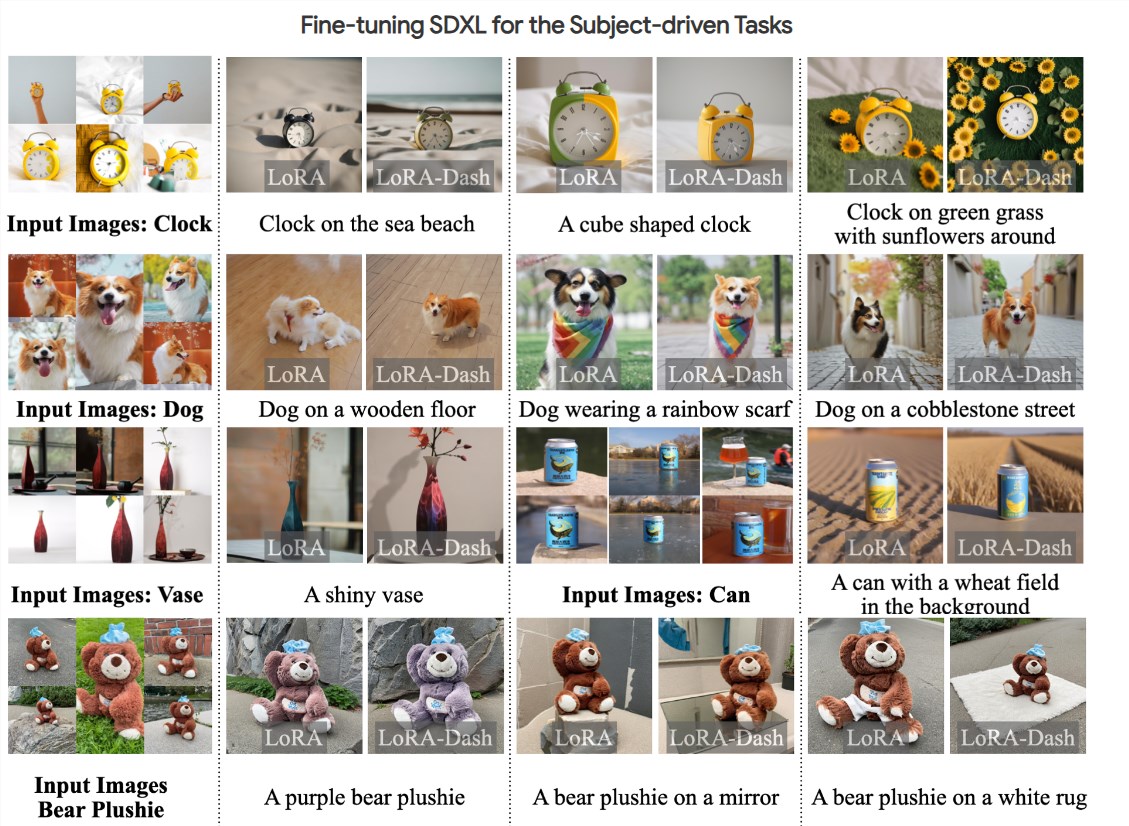

実験の結果、LoRA-Dash は、常識推論、自然言語理解、エージェント駆動生成などのタスクで大幅なパフォーマンスの向上を達成するなど、複数のタスクで LoRA のパフォーマンスを上回ることが示されています。この結果は、下流タスクにおける TSD の有効性を示しており、効率的な微調整の可能性を完全に解き放ちます。

現在、関連する研究論文が公開されており、コードはオープンソースとなっており、研究チームはより多くの研究者や開発者にサポートを提供して、誰もがモデルの微調整のプロセスをより効率的に行えるようにしたいと考えています。

プロジェクトの入り口: https://chongjiesi.site/project/2024-lora-dash.html

** ハイライト: **

**LoRA-Dash 手法の開始:** 新しいモデル微調整手法である LoRA-Dash が登場しました。LoRA と比較して、より効率的で、必要な計算能力が大幅に削減されます。

** タスク固有の方向性を明確にする:** 研究チームは「タスク固有の方向性」(TSD) を厳密に定義し、微調整プロセスにおけるその重要性を明確にしました。

** 注目すべき実験結果: ** 実験では、LoRA-Dash が常識推論、自然言語理解、その他のタスクにおいて LoRA より優れていることが示されており、効率的な微調整の大きな可能性が実証されています。

LoRA-Dash の登場は、モデルの微調整の分野に新たな希望をもたらし、その高い効率性と特定のタスクの方向性の正確な把握により、より効率的かつ低コストの方向で AI モデルのトレーニングの開発が促進されることが期待されています。 今後、LoRA-Dashがより実用的なアプリケーションにおいてその優れた性能を発揮し、人工知能技術の発展に貢献できることを期待しています。