Downcodes의 편집자는 Shanghai Jiao Tong University와 Harvard University의 연구팀이 최근 LoRA-Dash라는 새로운 모델 미세 조정 방법을 출시했다는 사실을 알게 되었습니다. 이 방법은 매개변수 개수를 8~16배로 줄여도 기존 LoRA 방식과 동일한 미세 조정 효과를 얻을 수 있어 제한된 컴퓨팅 자원으로 미세 조정 작업을 획기적으로 발전시킬 수 있다. LoRA-Dash의 핵심은 "사전 실행"과 "스프린트"의 두 단계를 통해 TSD를 효율적으로 식별하고 모델 최적화에 활용하는 "작업별 방향"(TSD)에 있습니다. 이는 의심할 여지없이 모델 미세 조정의 효율성을 크게 향상시키고 관련 연구에 대한 강력한 지원을 제공할 것입니다.

최근 상하이자오퉁대학교와 하버드대학교 연구팀은 새로운 모델 미세 조정 방법인 LoRA-Dash를 출시했습니다. 이 새로운 방법은 특히 특정 작업에 대한 미세 조정에서 기존 LoRA 방법보다 더 효율적이라고 주장하며, 매개 변수 수를 8~16배 줄이면서 동일한 효과를 얻을 수 있습니다. 이는 의심할 여지 없이 많은 양의 컴퓨팅 리소스가 필요한 미세 조정 작업에 있어 획기적인 발전입니다.

대규모 언어 모델의 급속한 개발 상황에서 특정 작업을 미세 조정해야 할 필요성이 점점 더 커지고 있습니다. 그러나 미세 조정에는 많은 컴퓨팅 리소스가 소모되는 경우가 많습니다. 연구팀은 이런 문제를 해결하기 위해 PEFT(Parameter Efficient Fine-Tuning) 전략을 도입했는데, LoRA가 대표적이다. 실험을 통해 LoRA는 주로 사전 훈련에서 학습한 일부 특징을 포착하고 증폭시켜 미세 조정 효과를 얻는다는 것을 알 수 있었습니다.

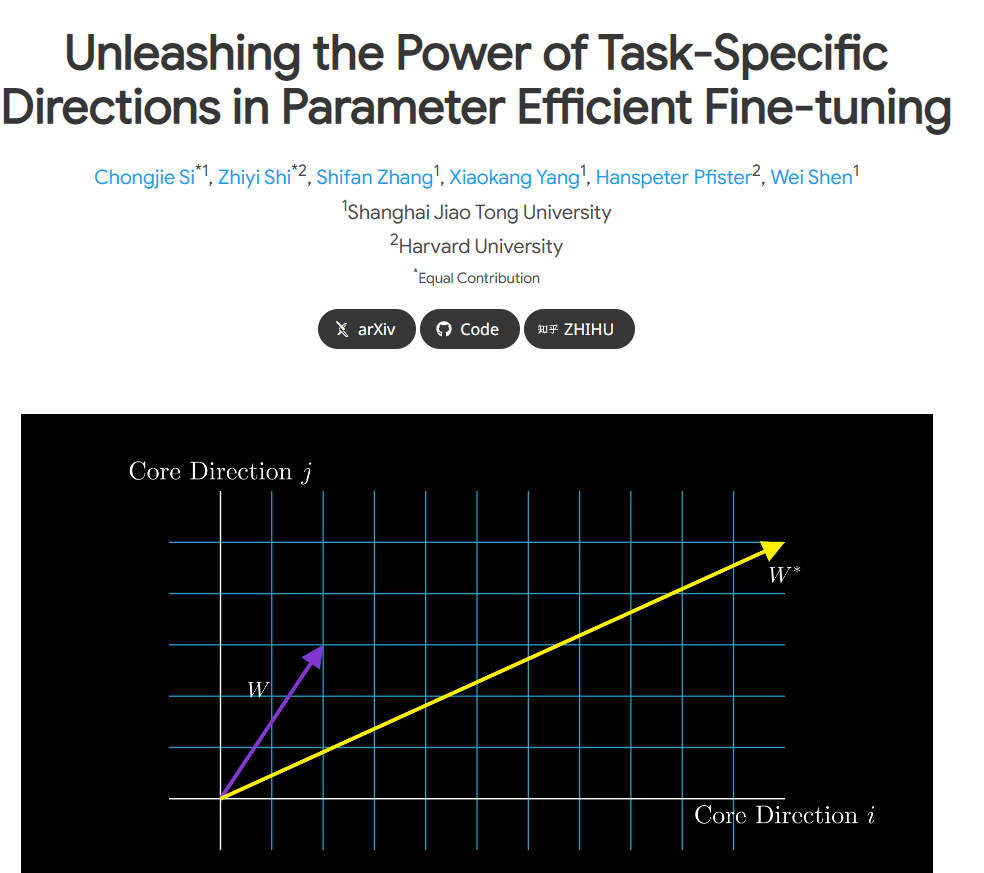

그러나 원본 LoRA 논문에는 "TSD(Task-Specific Direction)" 정의에 일부 모호함이 있습니다. 연구팀은 심층 분석을 통해 처음으로 TSD를 엄격하게 정의하고 그 성격을 규명했습니다. TSD는 미세 조정 중 모델 매개변수의 중요한 변화의 핵심 방향을 나타냅니다.

실제 응용 분야에서 TSD의 잠재력을 발휘하기 위해 연구자들은 두 가지 핵심 단계로 구성된 방법인 LoRA-Dash를 제안했습니다. 첫 번째 단계는 작업의 특정 방향을 식별해야 하는 "시작 전 단계"입니다. 두 번째 단계는 이전에 식별된 방향을 사용하여 더 나은 적응을 위해 모델을 최적화하고 조정합니다. 특정 작업에.

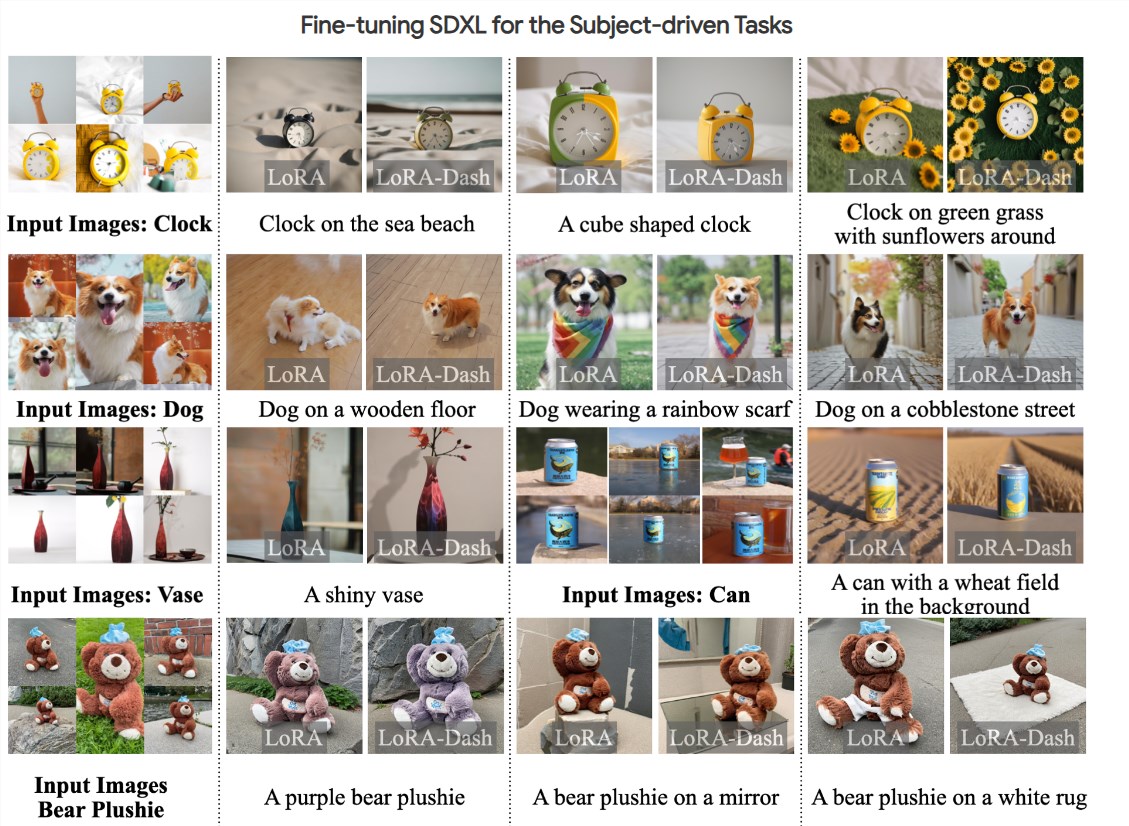

실험에 따르면 LoRA-Dash는 상식 추론, 자연어 이해, 에이전트 기반 생성과 같은 작업에서 상당한 성능 향상을 달성하는 등 여러 작업에서 LoRA의 성능을 능가하는 것으로 나타났습니다. 이 결과는 다운스트림 작업에서 TSD의 효율성을 보여주고 효율적인 미세 조정의 잠재력을 최대한 활용합니다.

현재 관련 연구 논문이 공개되었고 코드가 오픈 소스로 공개되었습니다. 연구팀은 더 많은 연구자와 개발자가 모델을 미세 조정하는 과정에서 보다 효율적으로 작업할 수 있도록 지원하기를 희망합니다.

프로젝트 입구: https://chongjiesi.site/project/2024-lora-dash.html

** 하이라이트: **

**LoRA-Dash 방식 출시:** 새로운 모델 미세 조정 방식인 LoRA-Dash가 출시되었습니다. LoRA에 비해 훨씬 효율적이고 훨씬 적은 컴퓨팅 성능을 필요로 합니다.

** 업무별 방향 명확화:** 연구팀은 '업무별 방향'(TSD)을 엄격하게 정의하고 미세 조정 과정에서 그 중요성을 명확히 했습니다.

** 주목할만한 실험 결과: ** 실험에 따르면 LoRA-Dash는 상식 추론, 자연어 이해 및 기타 작업에서 LoRA를 능가하며 효율적인 미세 조정의 엄청난 잠재력을 보여줍니다.

LoRA-Dash의 등장은 모델 미세 조정 분야에 새로운 희망을 가져왔습니다. LoRA-Dash의 높은 효율성과 특정 작업 방향의 정확한 파악은 AI 모델 훈련의 개발을 보다 효율적이고 저렴한 방향으로 촉진할 것으로 기대됩니다. 앞으로 LoRA-Dash가 보다 실용적인 응용 분야에서 뛰어난 성능을 발휘하여 인공지능 기술 발전에 기여할 수 있기를 기대합니다.