PromptRank

1.0.0

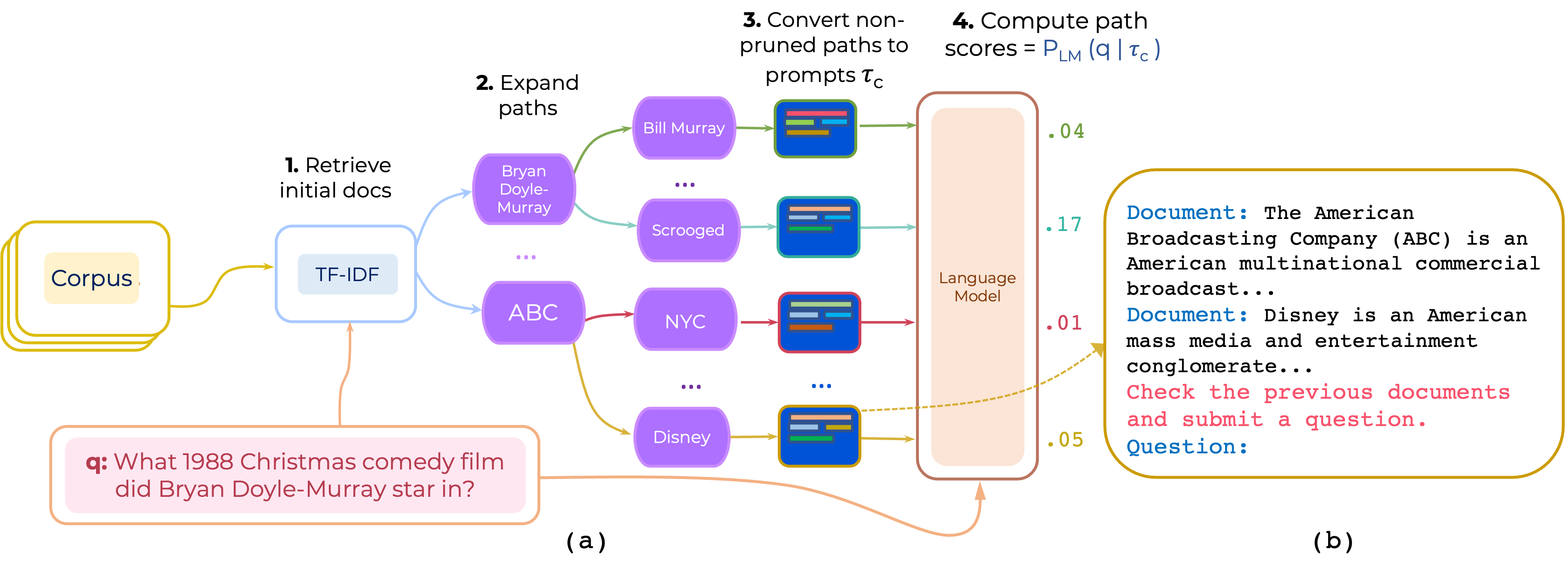

我們提出了一種用於開放域QA的多跳文檔路徑的零和少量重新排列的方法。 PROMPTRANK構建一個提示,該提示由(i)指令和(ii)路徑並使用LLM來評分路徑,以此作為生成提示的問題的概率。

從此鏈接下載Pathretriever提供的HotPotQA的TF-IDF檢索器和數據庫,並將其內容放在path-retriever/models中

pip install -r requirements.txt

可以從[Google Drive]下載HOTPOTQA和2WIKIMQA處理的數據,通過檢索200個頂級TF-IDF文章以播種推斷,可以預處理數據。 (https://drive.google.com/file/d/1mi7xadhwlhlw6fmow3ljqmpipsmlnp67/view?usp = share_link)。然後解壓縮數據,然後將內容放入data/

python run.py

--model google/t5-base-lm-adapt

--eval_batch_size=50

--max_prompt_len 600

--max_doc_len 230

--tfidf_pool_size 100

--n_eval_examples 1000

--temperature 1.0

--eval_data data/hotpotqa/dev.json

--prompt_template 'Document: <P> Review previous documents and ask some question. Question:'

python run.py

--model google/t5-base-lm-adapt

--eval_batch_size=50

--max_prompt_len 600

--max_doc_len 230

--tfidf_pool_size 100

--n_eval_examples 1000

--temperature 1.0

--eval_data data/hotpotqa/dev.json

--instruction_template_file instruction-templates/top_instructions.txt

--ensemble_prompts

這使用了在HotPotQA上找到的前10個說明,該指令在instruction-templates/top_instructions.txt中找到:

Document : < P > Review previous documents and ask some question . Question

Document : < P > Review the previous documents and answer question . Question :

Document : < P > Read the previous documents and write the following question . Question :

Document : < P > Search previous documents and ask the question . Question :

To analyze the documents and ask question . Document : < P > Question :

Document : < P > To read the previous documents and write a question . Question :

Document : < P > Read previous documents and write your exam question . Question :

Document : < P > Read the previous documents and ask this question . Question :

Read two documents and answer a question . Document : < P > Question :

Identify all documents and ask question . Document : < P > Question : python run.py

--model google/t5-base-lm-adapt

--eval_batch_size=50

--max_prompt_len 600

--max_doc_len 230

--tfidf_pool_size 100

--n_eval_examples 1000

--temperature 1.0

--eval_data data/hotpotqa/dev.json

--prompt_template 'Document: <P> Review previous documents and ask some question. Question:'

--demos_ids 0,1

--demos_file data/hotpotqa/in_context_demos.json

python run.py

--model google/t5-base-lm-adapt

--eval_batch_size=50

--max_prompt_len 600

--max_doc_len 230

--tfidf_pool_size 100

--n_eval_examples 1000

--temperature 1.0

--eval_data data/hotpotqa/dev.json

--prompt_template 'Document: <P> Review previous documents and ask some question. Question:'

--demos_ids 0,1

--demos_file data/hotpotqa/in_context_demos.json

--n_ensemble_demos 3

注意:該代碼支持指令結合或演示結合 - 不是兩者兼而有之。

我們使用Pathretriever的許多組件。因此,感謝Akari Asai和其他人提供的代碼和模型。

如果您使用此代碼,請考慮引用我們的論文:

@article{promptrank,

title={Few-shot Reranking for Multi-hop QA via Language Model Prompting},

author={Khalifa, Muhammad and Logeswaran, Lajanugen and Lee, Moontae and Lee, Honglak and Wang, Lu},

journal={arXiv preprint arXiv:2205.12650},

year={2023}

}