PromptRank

1.0.0

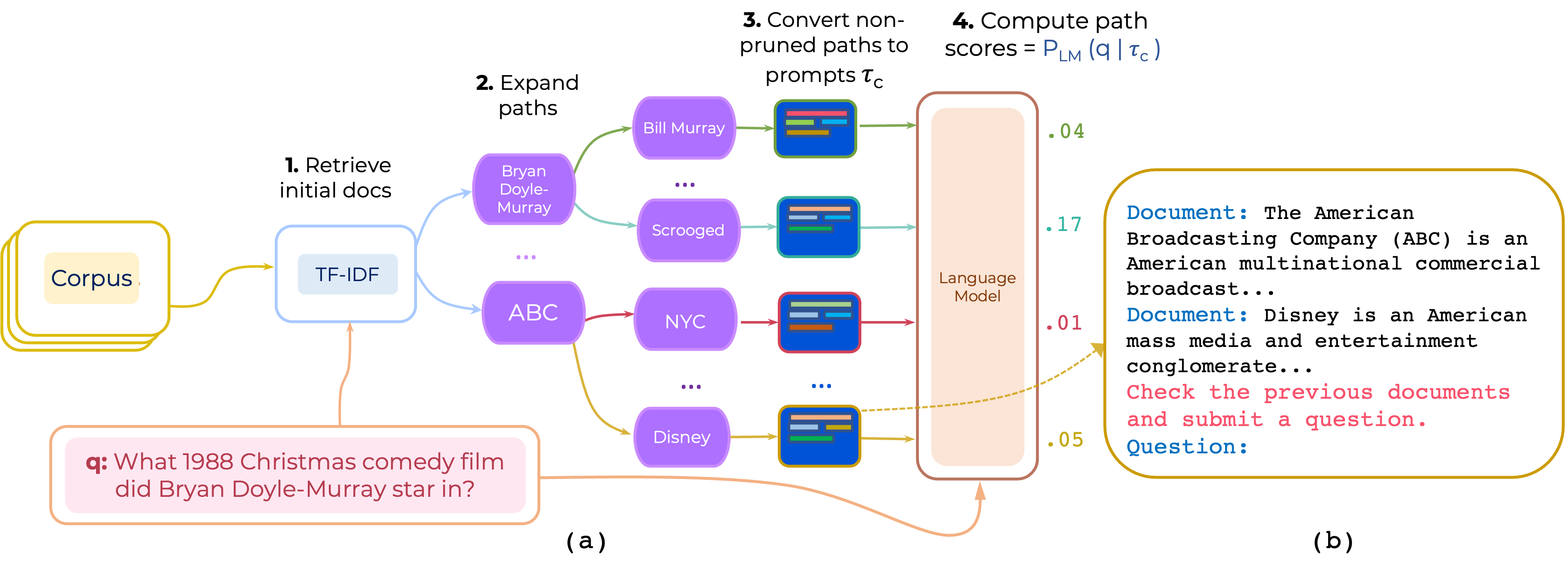

オープンドメインQAのマルチホップドキュメントパスのゼロおよび少数のショットの再ランキングのアプローチを提案します。 PromPtrankは、(i)命令と(ii)パスを使用し、LLMを使用して、プロンプトを考慮して質問を生成する確率としてパスを獲得するプロンプトを構築します。

このリンクからPathretrieverが提供するHotPotQA用のTF-IDFレトリバーとデータベースをダウンロードし、その内容をpath-retriever/modelsに配置します

pip install -r requirements.txt

hotpotqaおよび2wikimqa処理されたデータは、[Google Drive]からダウンロードできます。データは、推論をシードするために200のTF-IDF記事を取得することにより前処理されます。 (https://drive.google.com/file/d/1mi7xadhwlhlw6fmow3ljqmpipsmlnp67/view?usp=share_link)。次に、データを解凍してコンテンツをdata/

python run.py

--model google/t5-base-lm-adapt

--eval_batch_size=50

--max_prompt_len 600

--max_doc_len 230

--tfidf_pool_size 100

--n_eval_examples 1000

--temperature 1.0

--eval_data data/hotpotqa/dev.json

--prompt_template 'Document: <P> Review previous documents and ask some question. Question:'

python run.py

--model google/t5-base-lm-adapt

--eval_batch_size=50

--max_prompt_len 600

--max_doc_len 230

--tfidf_pool_size 100

--n_eval_examples 1000

--temperature 1.0

--eval_data data/hotpotqa/dev.json

--instruction_template_file instruction-templates/top_instructions.txt

--ensemble_prompts

これはinstruction-templates/top_instructions.txt hotpotqaに見られるトップ10の指示を使用します。

Document : < P > Review previous documents and ask some question . Question

Document : < P > Review the previous documents and answer question . Question :

Document : < P > Read the previous documents and write the following question . Question :

Document : < P > Search previous documents and ask the question . Question :

To analyze the documents and ask question . Document : < P > Question :

Document : < P > To read the previous documents and write a question . Question :

Document : < P > Read previous documents and write your exam question . Question :

Document : < P > Read the previous documents and ask this question . Question :

Read two documents and answer a question . Document : < P > Question :

Identify all documents and ask question . Document : < P > Question : python run.py

--model google/t5-base-lm-adapt

--eval_batch_size=50

--max_prompt_len 600

--max_doc_len 230

--tfidf_pool_size 100

--n_eval_examples 1000

--temperature 1.0

--eval_data data/hotpotqa/dev.json

--prompt_template 'Document: <P> Review previous documents and ask some question. Question:'

--demos_ids 0,1

--demos_file data/hotpotqa/in_context_demos.json

python run.py

--model google/t5-base-lm-adapt

--eval_batch_size=50

--max_prompt_len 600

--max_doc_len 230

--tfidf_pool_size 100

--n_eval_examples 1000

--temperature 1.0

--eval_data data/hotpotqa/dev.json

--prompt_template 'Document: <P> Review previous documents and ask some question. Question:'

--demos_ids 0,1

--demos_file data/hotpotqa/in_context_demos.json

--n_ensemble_demos 3

注:コードは、両方ではなく、命令アンサンブルまたはデモンストレーションアンサンミングをサポートしています。

Pathretrieverの多くのコンポーネントを使用しています。そのため、コードとモデルを提供してくれたAkari Asaiなどに感謝します。

このコードを使用する場合は、私たちの論文を引用することを検討してください。

@article{promptrank,

title={Few-shot Reranking for Multi-hop QA via Language Model Prompting},

author={Khalifa, Muhammad and Logeswaran, Lajanugen and Lee, Moontae and Lee, Honglak and Wang, Lu},

journal={arXiv preprint arXiv:2205.12650},

year={2023}

}