在最近的論文中,我們提出了Glow-TTS:通過單調對準搜索進行文本到語音的生成流程。

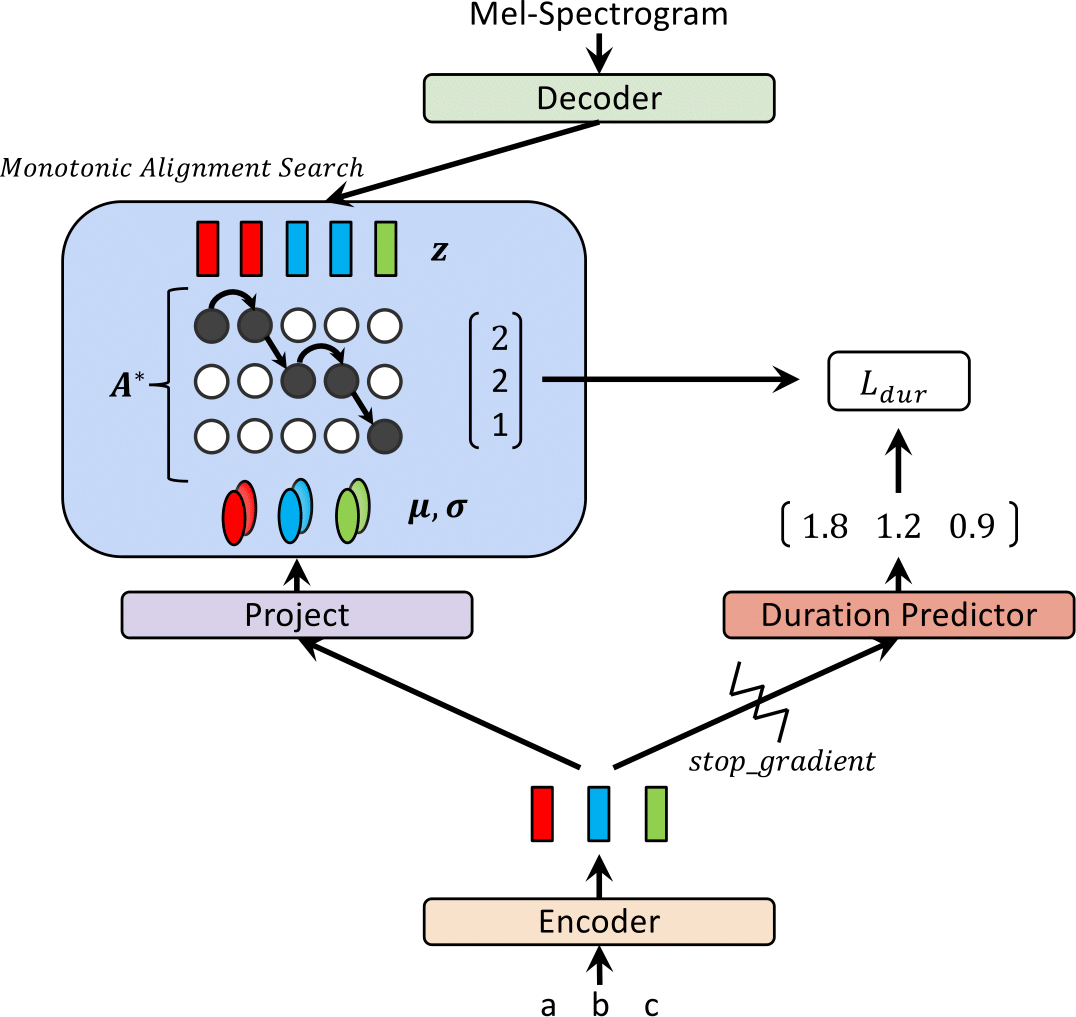

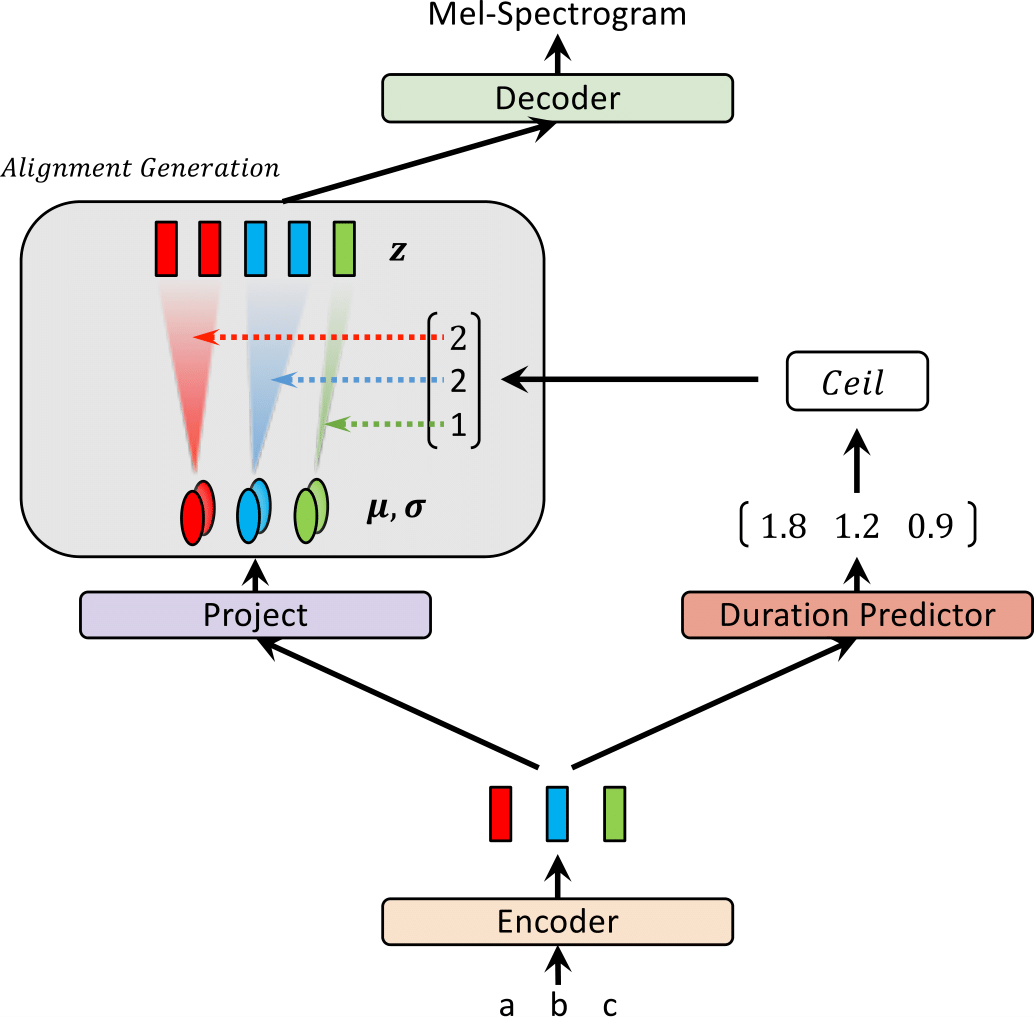

最近,已經提出了文本對語音(TTS)模型,例如FastSpeech和Paranet,以並行從文本中生成MEL-SEXPROGRAM。儘管有優勢,但如果沒有自回歸TTS模型作為其外部對齊器的指導,則不能對平行的TTS模型進行培訓。在這項工作中,我們提出了Glow-TTS,這是一種基於流動的生成模型,用於並行TT,不需要任何外部對齊器。通過結合流量和動態編程的屬性,提出的模型可以搜索文本和語音潛在語音之間最可能的單調比對。我們證明,執行硬單調的對準可以實現強大的TT,從而概括了長時間的話語,並且採用生成流動可以快速,多樣化和可控制的語音綜合。 Glow-TTS在合成時以相當的語音質量而獲得了自回歸模型TaCotron 2的速度速度加速。我們進一步表明,我們的模型可以輕鬆擴展到多演講者的設置。

訪問我們的演示以獲取音頻樣本。

我們還提供了驗證的模型。

| 在訓練中發光 | 推理時發光 |

|---|---|

|  |

該結果不包括在論文中。最近,我們發現兩種修改有助於提高Glow-TTS的合成質量。 1)搬到Vocoder,Hifi-GAN以減少噪聲,2)將空白令牌放在任何兩個輸入令牌之間以改善發音。具體而言,我們使用了帶有Tacotron 2的微型輔助聲碼器,該聲音器在HIFI-GAN存儲庫中作為驗證模型提供。如果您有興趣,請聽我們的演示中的樣本。

為了添加空白令牌,我們提供了一個配置文件和驗證的模型。我們還提供了一個推理示例temperion_hifigan.ipynb。您可能需要初始化hifi-gan子模塊: git submodule init; git submodule update

對於混合精確培訓,我們使用APEX;提交:37CDAF4

a)下載並提取LJ語音數據集,然後重命名或創建指向數據集文件夾的鏈接: ln -s /path/to/LJSpeech-1.1/wavs DUMMY

b)初始化wavelow subsodule: git submodule init; git submodule update

不要忘記下載驗證的Wavellow模型,然後將其放入Wavellow文件夾中。

c) cd monotonic_align; python setup.py build_ext --inplace

sh train_ddi.sh configs/base.json base請參閱推理。 IPYNB

我們的實施受到以下存儲庫的極大影響: