LLMsPracticalGuide

1.0.0

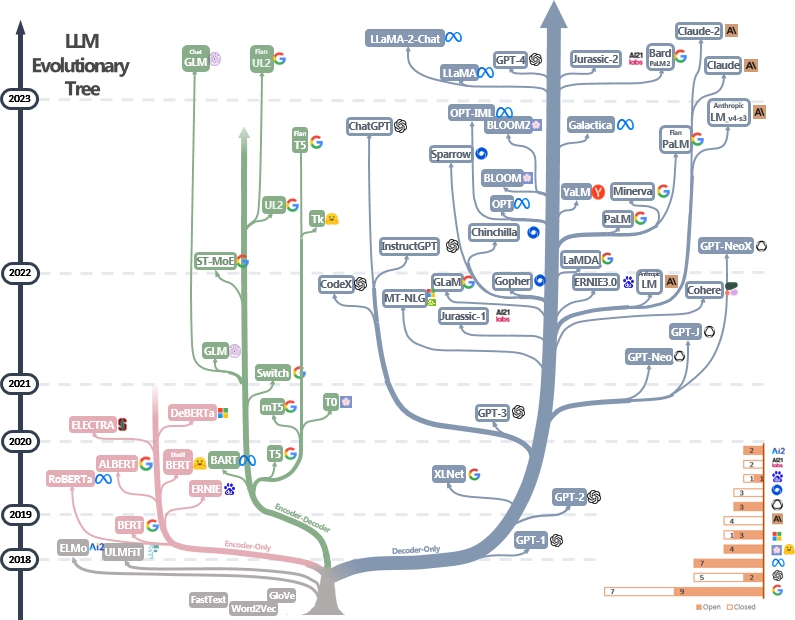

LLMS實用指南資源的策劃(仍在積極更新)列表。它基於我們的調查論文:利用LLM的實踐力量:Chatgpt及其境內的調查以及@xinyadu的努力。該調查部分基於此博客的後半部分。我們還建立了一棵現代大型語言模型(LLM)的進化樹,以追踪近年來語言模型的發展,並突出顯示一些最著名的模型。

這些資料旨在幫助從業者瀏覽大語言模型(LLM)的廣闊景觀及其在自然語言處理(NLP)應用中的應用。我們還根據模型和數據許可信息包括他們的使用限制。如果您在我們的存儲庫中發現任何資源有幫助,請隨時使用它們(不要忘記引用我們的論文!?)。我們歡迎拉動請求來完善這個數字!

@article { yang2023harnessing ,

title = { Harnessing the Power of LLMs in Practice: A Survey on ChatGPT and Beyond } ,

author = { Jingfeng Yang and Hongye Jin and Ruixiang Tang and Xiaotian Han and Qizhang Feng and Haoming Jiang and Bing Yin and Xia Hu } ,

year = { 2023 } ,

eprint = { 2304.13712 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CL }

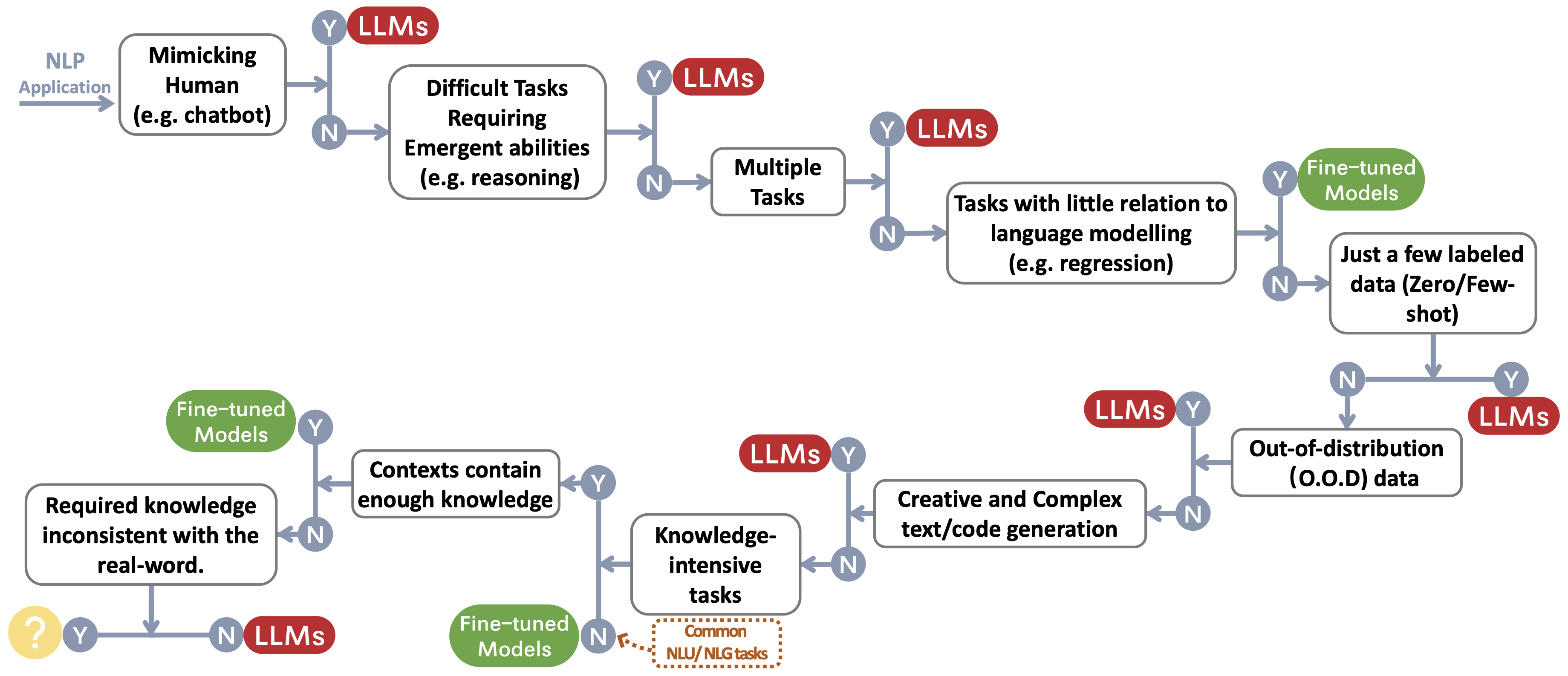

}我們為選擇LLM或微調模型〜 protect footnotemark構建決策流,用於用戶的NLP應用程序。決策流幫助用戶評估其下游的NLP應用程序是否符合特定條件,並基於該評估,確定LLMS或微型模型是否是其應用程序最合適的選擇。

我們構建了一個總結LLMS使用限制的表(例如,用於商業和研究目的)。特別是,我們從模型及其預處理數據的角度提供信息。我們敦促社區中的用戶參考公共模型和數據的許可信息,並以負責任的方式使用它們。我們敦促開發人員特別注意許可,使他們透明和全面,以防止任何不必要的和無法預料的用法。

| LLMS | 模型 | 數據 | |||

|---|---|---|---|---|---|

| 執照 | 商業用途 | 其他明顯的限制 | 執照 | 語料庫 | |

| 僅編碼 | |||||

| BERT系列模型(通用域) | Apache 2.0 | ✅ | 民眾 | Bookscorpus,英語Wikipedia | |

| 羅伯塔 | 麻省理工學院許可證 | ✅ | 民眾 | BookCorpus,CC-News,OpenWebText,故事 | |

| 厄尼 | Apache 2.0 | ✅ | 民眾 | 英語維基百科 | |

| Scibert | Apache 2.0 | ✅ | 民眾 | 伯特語料庫,語義學者114萬篇論文 | |

| Legalbert | CC BY-SA 4.0 | 公共(判例法訪問項目的數據除外) | 歐盟立法,美國法院案件等 | ||

| 生物Biobert | Apache 2.0 | ✅ | PubMed | PubMed,PMC | |

| 編碼器 | |||||

| T5 | Apache 2.0 | ✅ | 民眾 | C4 | |

| Flan-T5 | Apache 2.0 | ✅ | 民眾 | C4,任務的混合物(圖2中的圖2) | |

| 巴特 | Apache 2.0 | ✅ | 民眾 | 羅伯塔語料庫 | |

| Glm | Apache 2.0 | ✅ | 民眾 | bookscorpus和英語維基百科 | |

| chatglm | chatglm許可證 | 無用於非法目的或軍事研究,不會損害社會的公共利益 | N/A。 | 中文和英語語料庫的1T令牌 | |

| 僅解碼 | |||||

| GPT2 | 修改後的MIT許可證 | ✅ | 負責任地使用GPT-2,並清楚地表明您的內容是使用GPT-2創建的。 | 民眾 | WebText |

| gpt-neo | 麻省理工學院許可證 | ✅ | 民眾 | 樁 | |

| GPT-J | Apache 2.0 | ✅ | 民眾 | 樁 | |

| --->多莉 | CC由NC 4.0 | CC由NC 4.0,遵守OpenAI生成的數據的使用條款 | 堆,自我指導 | ||

| ---> gpt4all-j | Apache 2.0 | ✅ | 民眾 | GPT4ALL-J數據集 | |

| 畢田 | Apache 2.0 | ✅ | 民眾 | 樁 | |

| ---> Dolly V2 | 麻省理工學院許可證 | ✅ | 民眾 | 堆,數據映 - dolly-15k | |

| 選擇 | OPT-175B許可協議 | 沒有與監視研究和軍事有關的發展,也不會損害社會的公共利益 | 民眾 | Roberta Corpus,堆,PushShift.io reddit | |

| ---> opt-iml | OPT-175B許可協議 | 同樣選擇 | 民眾 | Opt copus,超簡短結構的擴展版本 | |

| YALM | Apache 2.0 | ✅ | 未指定 | 堆,團隊收集了俄語的文字 | |

| 盛開 | Bigscience Rail許可證 | ✅ | 無需使用可危害他人的目的來生成虛假信息; 內容沒有明確否認文本是機器生成的 | 民眾 | Roots copus(Lauren≥Con等,2022) |

| ---> Bloomz | Bigscience Rail許可證 | ✅ | 也很開心 | 民眾 | 根語料庫,xp3 |

| 銀河系 | CC BY-NC 4.0 | N/A。 | Galactica語料庫 | ||

| 駱駝 | 非商業定制許可證 | 沒有與監視研究和軍事有關的發展,也不會損害社會的公共利益 | 民眾 | CommonCrawl,C4,Github,Wikipedia等。 | |

| --->羊駝 | CC由NC 4.0 | CC由NC 4.0,遵守OpenAI生成的數據的使用條款 | Llama語料庫,自我指導 | ||

| --->維庫納 | CC由NC 4.0 | 遵守OpenAI生成的數據的使用條款; 共享的隱私慣例 | Llama語料庫,ShareGPT.com的70k對話 | ||

| ---> gpt4All | GPL許可的駱駝 | 民眾 | GPT4ALL數據集 | ||

| Ottinllama | Apache 2.0 | ✅ | 民眾 | Redpajama | |

| Codegeex | Codegeex許可證 | 無用於非法目的或軍事研究 | 民眾 | 堆,codeparrot,等。 | |

| Starcoder | BigCode OpenRail-M V1許可證 | ✅ | 無需使用可危害他人的目的來生成虛假信息; 內容沒有明確否認文本是機器生成的 | 民眾 | 堆棧 |

| MPT-7B | Apache 2.0 | ✅ | 民眾 | MC4(英語),堆棧,Redpajama,S2orc | |

| 鶻 | TII Falcon LLM許可證 | ✅/ | 根據允許商業用途的許可證可用 | 民眾 | 精製網絡 |