Vaaku2Vec

1.0.0

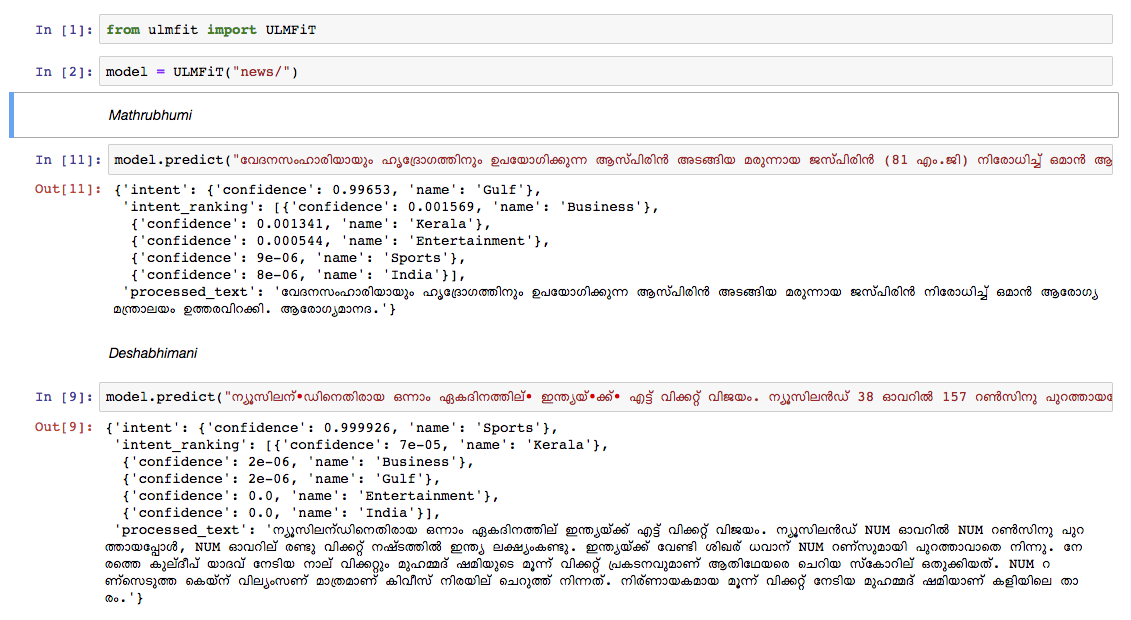

我们从2018年10月的Wikipedia文章转储中培训了马拉雅拉姆语的语言模型。WikipediaDump有55K+文章。在训练马拉雅拉姆语的语言模型中,难度是文本象征化,因为马拉雅拉姆语是一种高度变化和凝结的语言。在当前模型中,我们正在使用nltk tokenizer (将来会尝试更好的替代方案),而词汇大小为30k。该语言模型用于培训分类器,该分类器将新闻分为5个类别(印度,喀拉拉邦,体育,商业,娱乐)。我们的分类器在分类任务中以92%的高度准确性提出。

预审前的马拉雅拉姆语模型

预算的马拉雅拉姆语新闻分类器- 仅运行预测,请使用此。

Malayalam Wikipedia文章的RAW DATADUMP:Malayalam文章

Python3.6> =

如果您使用的是VirtualenvWrapper,请使用以下步骤:

git clone https://github.com/adamshamsudeen/Vaaku2Vec.gitmkvirtualenv -p python3.6 venvworkon venvcd Vaaku2Vecpip install -r requirements.txt python lm/create_toks.py <path_to_processed_wiki_dump>python lm/create_toks.py /home/adamshamsudeen/mal/Vaaku2Vec/wiki/ml/python lm/tok2id.py <path_to_processed_wiki_dump>python lm/tok2id.py /home/adamshamsudeen/mal/Vaaku2Vec/wiki/ml/python lm/pretrain_lm.py <path_to_processed_wiki_dump> 0 --lr 1e-3 --cl 40eg: python lm/pretrain_lm.py /home/adamshamsudeen/mal/Vaaku2Vec/wiki/ml/ 0 --lr 1e-3 --cl 40lr是学习率, cl是时代的NO。train_classifier.ipynb训练马拉雅拉姆语文本分类器。Pretrained Malyalam Text Classifier 。prediction.ipynb并测试您的输入。我们在其他领先的新闻报纸的新闻上手动测试了该模型,并且该模型的表现非常出色。